作者:紫陌 | 来源:互联网 | 2023-08-11 16:28

Linux下配置hadoop环境配置系统环境:centos7jdk:jdk-8u291hadoop:hadoop-3.3.0http:archive.apache.orgdisth

Linux下配置hadoop环境配置

系统环境:centos7

jdk:jdk-8u291

hadoop:hadoop-3.3.0

http://archive.apache.org/dist/hadoop/core/

ssh:finalshell

一、jdk安装

cd 到跟目录下

cd /

新建文件安装目录

mkdir -p /export/server/

使用finalshell将jdk压缩包上传至/export/server/目录

切换到server目录

cd /export/server/

将压缩包解压到server下

tar -zxvf jdk-8u291-linux-x64.tar.gz

配置环境变量

vim /etc/profile

在文件最后面添加

export JAVA_HOME=/export/server/jdk1.8.0_291

export PATH=$PATH:$JAVA_HOME/bin

保存退出

重新加载配置文件

source /etc/profile

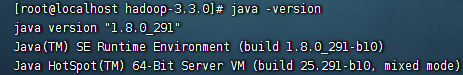

查看是否配置文件成功

java -version

出现以下信息说明配置成功

二、hadoop安装

1、设置ssh免密登录

ssh-keygen

按回车 生成公钥、私钥

将生成的密钥发送到本机地址

ssh-copy-id localhost

2、关闭禁用防火墙

关闭防火墙

systemctl stop firewalld.service

禁用防火墙

systemctl disable firewalld.service

查看当前状态(出现dead表示成功)

systemctl status firewalld.service

3、配置Hadoop

(1)配置core-site.xml文件

fs.defaultFS

hdfs://localhost:9000

hadoop.tmp.dir

file:/export/server/hadoop-3.3.0/data/tmp

hadoop.proxyuser.root.hosts

*

hadoop.proxyuser.root.groups

*

(2)配置hdfs-site.xml文件

dfs.namenode.name.dir

/export/server/hadoop-3.3.0/data/dfs/name

true

dfs.datanode.data.dir

/export/server/hadoop-3.3.0/data/dfs/data

true

dfs.replication

1

dfs.permissions

false

(3)配置hadoop-env.sh文件

export JAVA_HOME=/export/server/jdk1.8.0_291

export HDFS_NAMENODE_USER=root

export HDFS_DATENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

(4)配置mapred-site.xml文件

mapredure.frameword.name

yarn

(5)配置yarn-site.xml 文件

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.address

192.168.200.138:8032

yarn.resourcemanager.scheduler.address

192.168.200.138:8030

yarn.resourcemanager.resource-tracker.address

192.168.200.138:8031

yarn.resourcemanager.admin.address

192.168.200.138:8033

yarn.resourcemanager.webapp.address

192.168.200.138:8088

(6)配置hadoop环境变量

vim /etc/profile

在文件最后面添加

export HADOOP_HOME=/export/server/hadoop-3.3.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

保存退出

重新加载配置文件

source /etc/profile

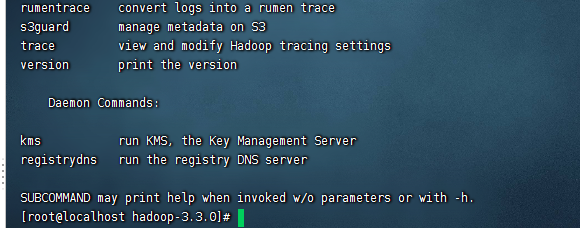

查看是否配置文件成功

hadoop

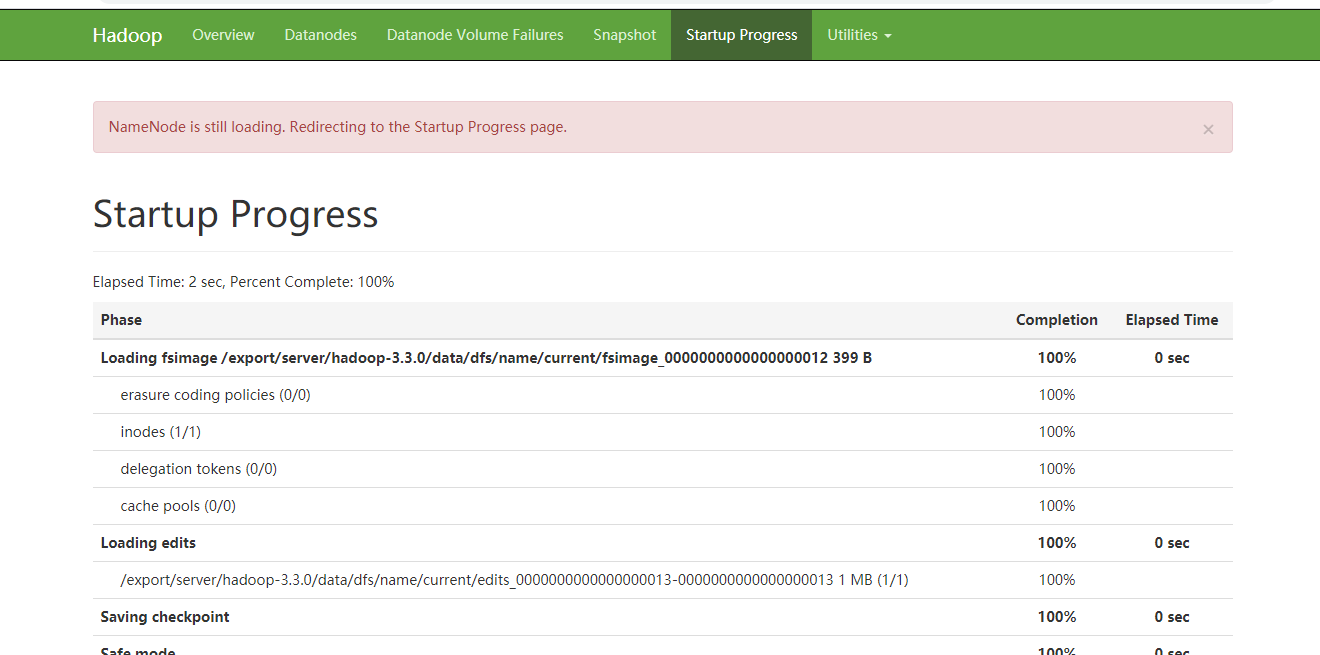

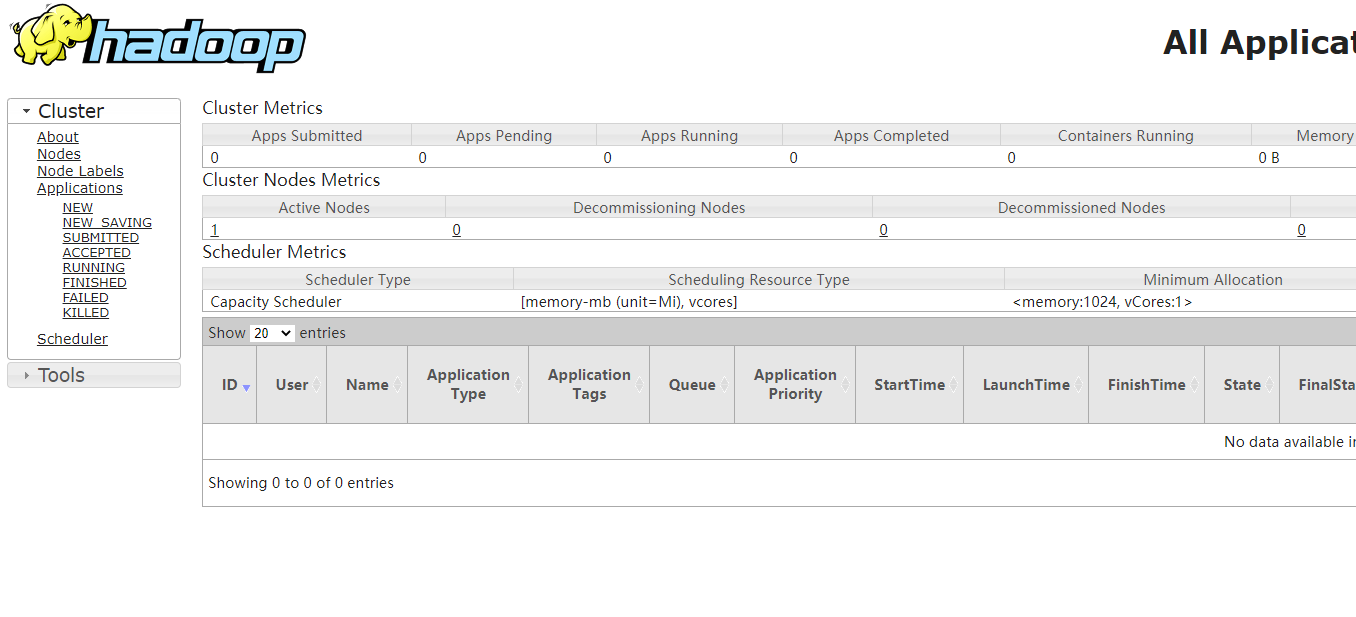

三、查看hadoop网页

Linux服务ip:8088

Linux服务ip:9870