作者:谁能吿诉我 | 来源:互联网 | 2023-10-13 12:12

原文来源:https:arxiv.org、https:github.com作者:FujunLuan、SylvainParis、EliShechtman、KavitaB

译文: https://arxiv.org/,https://github.com/

作者: Fujun Luan,Sylvain Paris,Eli Shechtman,Kavita Bala,Louie总是迟到的乌龟

“机器人社团”编译:嗯~、鲜艳的棉花糖、哆啦A梦灯

今年4月,Adobi公司和康奈尔大学共同发表了名为《深度照片风格迁移》(deepphotostyletransfer )的论文,使得一张照片的风格可以真实地转移到另一张照片上。 最近,在GitHub上,这篇论文基于TensorFlow的实现被开源了。 本文分为两个部分,前简要回顾这篇论文的原理,后展示具体的TensorFlow的实现操作。

本文介绍了一种真实图像风格迁移的深度学习方法,在迁移参考风格的同时处理大量图像场景。 这篇论文通过研究神经网络的各个层,从图像的内容中提取风格。 但是,此方法不适用于“真实样式”(photorealistic style )过渡。 即使输入图像和参照图像是照片,输出中显示的结果也会让人联想到失真的画。 这篇论文的主要贡献是限制从输入到输出的转换,在颜色空间中局部仿射,将其约束表现为自定义的完全微小的能量项。 该论文的研究结果表明,该方法成功地抑制了失真,带来了时间、天气、季节、艺术编辑风格的转变等各种场景中令人满意的真实风格的转变。

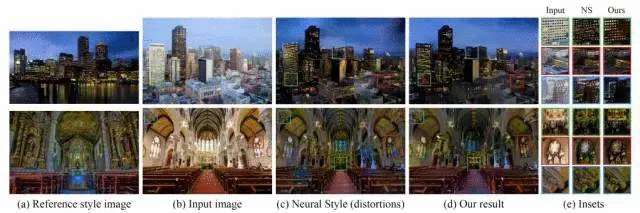

真实的图像样式转换是一个长期问题,它试图将参考样式的照片样式转换到另一个输入图像。 例如,通过适当选择参考风格的照片,可以使输入图像看起来像是在不同的照明、时间和天气下拍摄的,也可以使输入图像看起来像是出于完全不同的意图而模糊了艺术风格。 迄今为止,现有技术在场景的多样性、它们能够处理的过渡、以及它们达成的风格匹配的忠实性方面存在很多局限性。 本文介绍了一种能够在处理各种图像场景的同时准确地转变参考样式的真实图像样式转变的深度学习方法。 最近,Gatys等人在010~3010 (imagestyletransferusingconvolutional Neural Networks.)中阐述的神经风格迁移研究中取得了最新成果,我们的方法就是基于此。 但是,如下图所示,即使输入和参照样式的图像是照片,输出也会看起来像画一样。 例如,直线的边呈弯曲的规则纹理波状。 我们需要做的一件事是防止空间扭曲,限制迁移操作只在颜色空间进行,从而消除类似油漆的效果。

(甲) ) )。

(b ) ) )。

(c ) ) )。

(d ) ) )。

(e ) ) )。

a

b

c

d

e

参考图案图像(a )和输入图像) b )尝试创建与输入场景相同的输出图像,但使用参考图像的样式。 《使用卷积神经网络的图像风格迁移》中提到的神经样式算法(c )正常转移了

了颜色,而且还引起了使输出看起来像一幅画的失真,这在照片风格转移的情境中是不可取的。相比之下,我们的结果(d)在保留输出的逼真感的同时良好地迁移了参考风格图像的颜色。在(e)中,我们显示了(b),(c)和(d)(按照这个顺序)的3个插图。放大以比较结果。

我们可通过能够在色彩空间中进行局部仿射的转换模型来实现这个目标,我们可将其表示为一个自定义完全可微的能量项,而这一灵感主要启发于A. Levin等人所著的《自然图像抠图的封闭式解决方法》(A closed-form solution to natural image matting)中所提及的拉普拉斯抠图技术(Matting Laplacian)。我们的研究结果表明,这种方法成功地抑制了失真,同时将对迁移忠实性影响降低到最小。而我们的其他关键性贡献是解决了输入和引用图像之间的情境差异所带来的挑战,这可能导致不相关的情境之间产生不可取的迁移。例如,考虑在输入图像中具有较少天空可见的图像,忽略风格和输入之间情境差异的迁移可能会导致天空风格“溢出”到其余的图片中。我们展示了如何使用L.-C. Chen等人所著的《Deeplab:具有深卷积网络、动态卷积和完全连接crfs的语义图像分割》(Deeplab: Semantic image segmentation with deep

convolutional nets, atrous convolution, and fully connected

crfs.)中所提及的语义分割来解决输入和参考图像中的这个问题。同时,我们的研究结果表明此方法具有非常好的有效性,它满足了各种各样的场景,包括时间、天气、季节和艺术编辑的迁移,从而产生令人满意的逼真效果。

了解论文更多详情,欢迎下载原文:https://arxiv.org/pdf/1703.07511.pdf

实现

接下来介绍《深度图片风格迁移》(Deep Photo Styletransfer)在Tensorflow上的实现,torch上的实现请点击此处链接参阅更多详情。

这个实现支持L-BFGS-B(这是原作者所使用的)和Adam,以防当Tensorflow升级到更高版本时,ScipyOptimizerInterface不兼容。

由于Tensorflow的自动微分,这种实现可能会更简单一点。

此外,由于另一个repo计算拉普拉斯稀疏矩阵,所以对MATLAB没有依赖性。以下是将照片风格迁移到另一张照片的示例。

免责声明

本软件仅用于学术和非商业用途。

设置

相关性

•Tensorflow

•Numpy

•Pillow

•Scipy

•PyCUDA (用于平滑局部仿射,在CUDA 8.0上测试)

建议使用Anaconda Python,因为你只需要手动安装Tensorflow和PyCUDA即可。CUDA是可选项,但是推荐大家使用。

下载VGG-19模型的权重

VGG Tensorflow采用Tensorflow的VGG-19模型,对类接口进行了少量修改。VGG-19模型的权重存储为.npy文件,可以点击此处下载。下载后,将权重文件复制到./project/vgg19目录。

用法

基本用法:

你需要指定内容图像的路径,样式图像,内容图像分割,样式图像分割,然后运行命令

python deep_photostyle.py

--content_image_path

--style_image_path

--content_seg_path

--style_seg_path --style_option 2

例如:

python deep_photostyle.py

--content_image_path ./examples/input/in11.png

--style_image_path ./examples/style/tar11.png

--content_seg_path ./examples/segmentation/in11.png

--style_seg_path ./examples/segmentation/tar11.png

--style_option 2

其他选项

--style_option指定了三种不同的风格迁移方式。--style_option 0是在torch中产生分段的中间结果,如torch文件neuralstyle_seg.lua。--style_option 1使用此中间结果生成最终结果,如torch文件deepmatting_seg.lua。--style_option 2将这两个步骤组合为一行命令直接生成最终结果。

运行python deep_photostyle.py --help to see a list of all options查看所有选项的列表

图像分割

该repo不提供图像分割脚本,并且仅使用来自torch版本的分割图像。使用的滤镜颜色也与它们相同。你可以指定自己的分割模型和掩码颜色来自定义自己的样式迁移。

示例

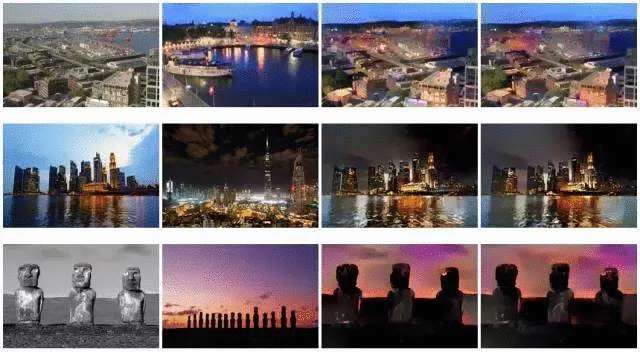

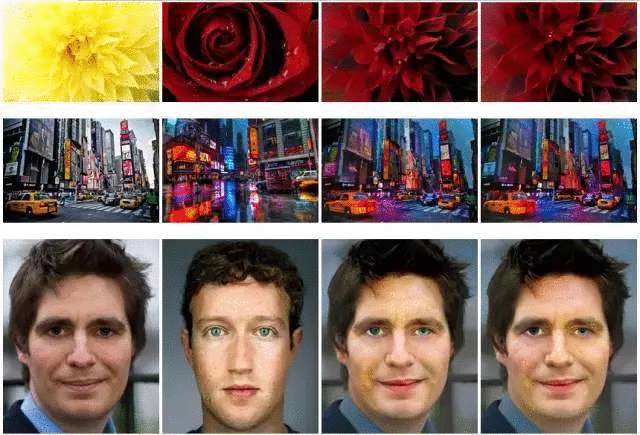

这里有更多的结果来自tensorflow算法(从左到右是输入,样式,torch结果和tensorflow结果)

致谢

这项工作是在Liu 老迟到的乌龟作为阿里巴巴—浙江大学前沿技术联合研究中心研究实习生的时,由Song Mingli 教授和 Jing Yongcheng教授指导下完成。

我们的tensorflow的实现基本上效仿torch代码。

我们使用martinbenson的python代码来计算Matting Laplacian矩阵。

引文

如果你发现此代码对你的研究有用,请援引:

@misc{老迟到的乌龟PhotoStyle2017,

源代码:https://github.com/Louie老迟到的乌龟/deep-photo-styletransfer-tf