作者:手浪用户2602928711 | 来源:互联网 | 2023-08-23 18:53

CSDN话题挑战赛第2期

参赛话题:大数据技术分享

一、Yarn

Hadoop主要是由三部分组成,除了前面我讲过的分布式文件系统HDFS、分布式计算框架MapReduce,还有一个是分布式集群资源调度框架Yarn。但是Yarn并不是随Hadoop的推出一开始就有的,Yarn作为分布式集群的资源调度框架,它的出现伴随着Hadoop的发展,使Hadoop从一个单一的大数据计算引擎,成为一个集存储、计算、资源管理为一体的完整大数据平台,进而发展出自己的生态体系,成为大数据的代名词。

先回忆一下我们学习的MapReduce的架构,在MapReduce应用程序的启动过程中,最重要的就是要把MapReduce程序分发到大数据集群的服务器上。这种架构方案的主要缺点是,服务器集群资源调度管理和MapReduce执行过程耦合在一起,如果想在当前集群中运行其他计算任务,比如Spark或者Storm,就无法统一使用集群中的资源了。

在Hadoop早期的时候,大数据技术就只有Hadoop一家,这个缺点并不明显。但随着大数据技术的发展,各种新的计算框架不断出现,我们不可能为每一种计算框架部署一个服务器集群,而且就算能部署新集群,数据还是在原来集群的HDFS上。所以我们需要把MapReduce的资源管理和计算框架分开,这也是Hadoop 2最主要的变化,就是将Yarn从MapReduce中分离出来,成为一个独立的资源调度框架。

从图上看,Yarn包括两个部分:一个是资源管理器(Resource Manager),一个是节点管理器(Node Manager)。这也是Yarn的两种主要进程:ResourceManager进程负责整个集群的资源调度管理,通常部署在独立的服务器上;NodeManager进程负责具体服务器上的资源和任务管理,在集群的每一台计算服务器上都会启动,基本上跟HDFS的DataNode进程一起出现。

具体说来,资源管理器又包括两个主要组件:调度器和应用程序管理器。

调度器其实就是一个资源分配算法,根据应用程序(Client)提交的资源申请和当前服务器集群的资源状况进行资源分配。Yarn内置了几种资源调度算法,包括Fair Scheduler、Capacity Scheduler等,你也可以开发自己的资源调度算法供Yarn调用。

Yarn进行资源分配的单位是容器(Container),每个容器包含了一定量的内存、CPU等计算资源,默认配置下,每个容器包含一个CPU核心。容器由NodeManager进程启动和管理,NodeManger进程会监控本节点上容器的运行状况并向ResourceManger进程汇报。

应用程序管理器负责应用程序的提交、监控应用程序运行状态等。应用程序启动后需要在集群中运行一个ApplicationMaster,ApplicationMaster也需要运行在容器里面。每个应用程序启动后都会先启动自己的ApplicationMaster,由ApplicationMaster根据应用程序的资源需求进一步向ResourceManager进程申请容器资源,得到容器以后就会分发自己的应用程序代码到容器上启动,进而开始分布式计算。

我们以一个MapReduce程序为例,来看一下Yarn的整个工作流程。

1.我们向Yarn提交应用程序,包括MapReduce ApplicationMaster、我们的MapReduce程序,以及MapReduce Application启动命令。

2.ResourceManager进程和NodeManager进程通信,根据集群资源,为用户程序分配第一个容器,并将MapReduce ApplicationMaster分发到这个容器上面,并在容器里面启动MapReduce ApplicationMaster。

3.MapReduce ApplicationMaster启动后立即向ResourceManager进程注册,并为自己的应用程序申请容器资源。

4.MapReduce ApplicationMaster申请到需要的容器后,立即和相应的NodeManager进程通信,将用户MapReduce程序分发到NodeManager进程所在服务器,并在容器中运行,运行的就是Map或者Reduce任务。

5.Map或者Reduce任务在运行期和MapReduce ApplicationMaster通信,汇报自己的运行状态,如果运行结束,MapReduce ApplicationMaster向ResourceManager进程注销并释放所有的容器资源。

MapReduce如果想在Yarn上运行,就需要开发遵循Yarn规范的MapReduce ApplicationMaster,相应地,其他大数据计算框架也可以开发遵循Yarn规范的ApplicationMaster,这样在一个Yarn集群中就可以同时并发执行各种不同的大数据计算框架,实现资源的统一调度管理。

二、Hive

MapReduce的出现大大简化了大数据编程的难度,普通工程师也能使用MapReduce开发大数据程序。但是对于经常需要进行大数据计算的人,比如数据分析师来说,他们通常使用SQL进行大数据分析和统计,MapReduce编程还是有一定的门槛。而且如果每次统计和分析都开发相应的MapReduce程序,成本也确实太高了。那么有没有更简单的办法,可以直接将SQL运行在大数据平台上呢?

对于常见的一条SQL分析语句,MapReduce如何编程实现?

SELECT pageid, age, count(1) FROM pv_users GROUP BY pageid, age;

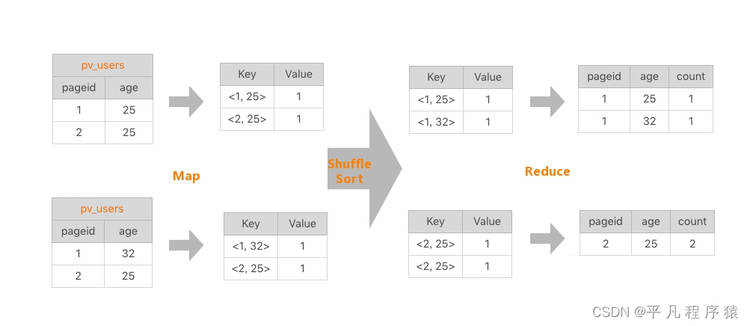

这是一条非常常见的SQL统计分析语句,统计不同年龄的用户访问不同网页的兴趣偏好,对于产品运营和设计很有价值。具体数据输入和执行结果请看下面的图示。

左边是要分析的数据表,右边是分析结果。实际上把左边表相同的行进行累计求和,就得到右边的表了,看起来跟WordCount的计算很相似。确实也是这样,我们看下这条SQL语句的MapReduce的计算过程,按照MapReduce编程模型,map和reduce函数的输入输出以及函数处理过程分别是什么。

首先&#xff0c;看下map函数的输入Key和Value&#xff0c;我们主要看Value。Value就是左边表中每一行的数据&#xff0c;比如<1, 25>这样。map函数的输出就是以输入的Value作为Key&#xff0c;Value统一设为1&#xff0c;比如<<1, 25>, 1>这样。

map函数的输出经过shuffle以后&#xff0c;相同的Key及其对应的Value被放在一起组成一个&#xff0c;作为输入交给reduce函数处理。比如<<2, 25>, 1>被map函数输出两次&#xff0c;那么到了reduce这里&#xff0c;就变成输入<<2, 25>, <1, 1>>&#xff0c;这里的Key是<2, 25>&#xff0c;Value集合是<1, 1>。

在reduce函数内部&#xff0c;Value集合里所有的数字被相加&#xff0c;然后输出。所以reduce的输出就是<<2, 25>, 2>。

这样一条很有实用价值的SQL就被很简单的MapReduce计算过程处理好了。

在数据仓库中&#xff0c;SQL是最常用的分析工具&#xff0c;既然一条SQL可以通过MapReduce程序实现&#xff0c;那么有没有工具能够自动将SQL生成MapReduce代码呢&#xff1f;这样数据分析师只要输入SQL&#xff0c;就可以自动生成MapReduce可执行的代码&#xff0c;然后提交Hadoop执行&#xff0c;也就完美解决了我们最开始提出的问题。问题的答案&#xff0c;也就是这个神奇的工具就是Hadoop大数据仓库Hive。

我们通过Hive的Client&#xff08;Hive的命令行工具&#xff0c;JDBC等&#xff09;向Hive提交SQL命令。如果是创建数据表的DDL&#xff08;数据定义语言&#xff09;&#xff0c;Hive就会通过执行引擎Driver将数据表的信息记录在Metastore元数据组件中&#xff0c;这个组件通常用一个关系数据库实现&#xff0c;记录表名、字段名、字段类型、关联HDFS文件路径等这些数据库的Meta信息&#xff08;元信息&#xff09;。

如果我们提交的是查询分析数据的DQL&#xff08;数据查询语句&#xff09;&#xff0c;Driver就会将该语句提交给自己的编译器Compiler进行语法分析、语法解析、语法优化等一系列操作&#xff0c;最后生成一个MapReduce执行计划。然后根据执行计划生成一个MapReduce的作业&#xff0c;提交给Hadoop MapReduce计算框架处理。

后面随着Hive的普及&#xff0c;我们对于在Hadoop上执行SQL的需求越加强烈&#xff0c;对大数据SQL的应用场景也多样化起来&#xff0c;于是又开发了各种大数据SQL引擎。后来Spark出道以后&#xff0c;也迅速推出了自己的SQL引擎Shark&#xff0c;也就是后来的Spark SQL&#xff0c;将SQL语句解析成Spark的执行计划&#xff0c;在Spark上执行。由于Spark比MapReduce快很多&#xff0c;Spark SQL也相应比Hive快很多&#xff0c;并且随着Spark的普及&#xff0c;Spark SQL也逐渐被人们接受。后来Hive推出了Hive on Spark&#xff0c;将Hive的执行计划转换成Spark的计算模型&#xff0c;当然这是后话了。