| 产品 | 模型 | API | 保证次数 | 容错机制 | 状态管理 | 延时 | 吞吐量 | 成熟度 |

|---|

| Storm | Native | Compositional | At least once | Record ACKs | Not built-in | <1s | Low | High |

| Trident | Micro-batching | Compositional | Exactly-once | Record ACKs | Dedicated Operators | Seconds~mins | Medium | High |

| Spark Streaming | Micro-batching | Declarative | Exactly-once | RDD based Checkpointing | Dedicated DStream | Seconds~mins | High | High |

| Samza | Native | Compositional | At least once | Log-based | Stateful Operators | ms ~ s | High | Medium |

| Flink | Native | Declarative | Exactly-once | Checkpointing | Stateful Operators | ms ~ s | High | 1.0以发布 |

Spark vs flink

内存管理&#xff1a;

一直到1.5版本&#xff0c;spark都是试用java的内存管理来做数据缓存&#xff0c;明显很容易导致OOM或者gc。所以从1.5开始&#xff0c;spark开始转向精确的控制内存的使用&#xff0c;这就是tungsten项目了。从1.5开始&#xff0c;所有的dataframe操作都是直接作用在tungsten的二进制数据上。

flink从第一天开始就坚持自己控制内存试用。这个也是启发了spark走这条路的原因之一。flink除了把数据存在自己管理的内存以外&#xff0c;还直接操作二进制数据。

语言实现

Spark用的Scala&#xff0c; flink是java

对 windowing 的支持&#xff1a;

因为spark的小批量机制&#xff0c;spark对于windowing的支持非常有限。只能基于process time&#xff0c;且只能对batches来做window。

Flink对window的支持非常到位&#xff0c;且Flink对windowing API的支持是相当给力的&#xff0c;允许基于process time,data time,record 来做windowing。

SQL interface

spark-sql是spark里面最活跃的组件之一&#xff0c;Spark提供了类似Hive的sql和Dataframe这种DSL来查询结构化数据&#xff0c;API很成熟&#xff0c;在流式计算中使用很广&#xff0c;预计在流式计算中也会发展得很快。

Flink Table API只支持类似DataFrame这种DSL&#xff0c;并且还是处于beta状态&#xff0c;社区有计划增加SQL 的interface&#xff0c;但是目前还不确定什么时候才能在框架中用上。

Data source Integration

Spark的数据源 API是整个框架中最好的&#xff0c;支持的数据源包括NoSql db,parquet,ORC等&#xff0c;并且支持一些高级的操作&#xff0c;例如predicate push down

Flink目前还依赖map/reduce InputFormat来做数据源聚合。

Iterative processing

spark对机器学习的支持较好&#xff0c;因为可以在spark中利用内存cache来加速机器学习算法。但是大部分机器学习算法其实是一个有环的数据流&#xff0c;但是在spark中&#xff0c;实际是用无环图来表示的&#xff0c;一般的分布式处理引擎都是不鼓励试用有环图的。

flink支持在runtime中的有环数据流&#xff0c;这样表示机器学习算法更有效而且更有效率。

结论&#xff1a; 目前Spark相比Flink是一个更为成熟的计算框架&#xff0c;但是Flink的很多思路很不错&#xff0c;Spark社区也意识到了这一点&#xff0c;并且逐渐在采用Flink中的好的设计思路&#xff0c;所以学习一下Flink能让你了解一下Streaming这方面的更迷人的思路。

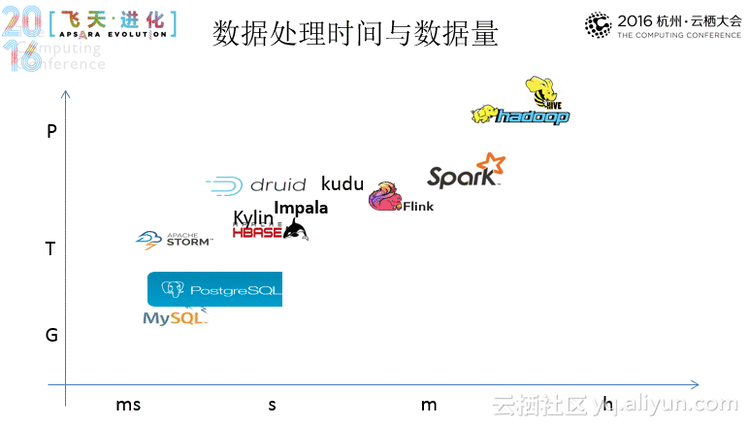

Kudu:

Kudu的定位是提供”fast analytics on fast data”&#xff0c;也就是在快速更新的数据上进行快速的查询。它定位OLAP和少量的OLTP工作流&#xff0c;如果有大量的random accesses&#xff0c;官方建议还是使用HBase最为合适。

kylin

hadoop上的cube

Impala:

Impala是架构于Hadoop之上的开源、高并发的MPP查询引擎&#xff0c;被广泛应用于各种行业。Impala是完全集成的&#xff0c;用以平衡Hadoop的灵活性和可扩展性&#xff0c;为BI&#xff0f;数据分析师提供低延迟、高并发的以读为主的查询。

它将传统分析数据库的SQL支持和多用户性能与Hadoop的灵活性和可扩展性结合起来&#xff0c;它通过利用HDFS、HBase、Metastore、YARN、Sentry等标准组件能够读取大多数广泛使用的文件格式比如Parquet、Avro、RCFile来维护Hadoop的灵活性&#xff1b;为了降低延迟&#xff0c;避免利用MR或者读远程数据&#xff0c;基于负责查询执行所有方面、作为Hadoop基础设施一部分运行于各台服务器上的Deamon进程实现了一个分布式架构&#xff0c;在相同负载的情形下其性能相当或超过了商用MPP分析数据库。

参考资料&#xff1a;

新一代大数据处理引擎 Apache Flink

Apache流计算框架详细对比

Introduction Into Distributed Real-Time Stream Processing

大数据分析界的“神兽”Apache Kylin有多牛

Kudu:支持快速分析的新型Hadoop存储系统