作者:辽宁何氏医学院高明月 | 来源:互联网 | 2023-08-27 08:37

Meta (原Facebook)开放了一个“高达”1750亿参数的预训练大语言模型OPT-175B,不仅参数比GPT-3的3750亿更少,效果还完全不输GPT-3——

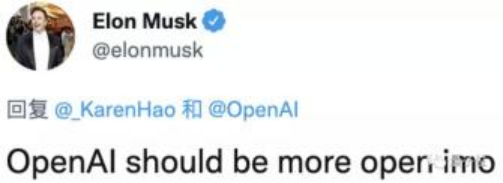

之前GPT-3虽然效果惊艳、示例众多,但其不够开放,只开放了API,还是收费的;源代码独家授权给了微软,连马斯克都对其呵呵,批评过OpenAI不够open。

虽然论文已经写的很详细,说明了GPT-3是怎么造出来的,但普通玩家想要复刻一个GPT-3出来,却是大大的困难,因为太烧钱。而这一次,Meta从完整模型到训练代码、部署代码全部开放。

有人甚至在官宣之前,就已经到GitHub仓库去蹲点了。还有人喊话OpenAI,让它学着点。

虽然Meta出品,当属精品,但国外公司的模型几乎都是用英语数据进行训练,其模型也天然地对英语的支持比较好,跨语言的效果较差,就更不要说对于世界上最难的中文的理解和生成了。

斯坦福大学副教授Percy Liang将大模型的开放程度总结成4个层次,更高层次的开放能让研究者专注于研究更深层面的问题。

第一层论文开放(纸面上的开放),证明一些设想的可行性,并提供思路和实现的路径方法。

第二层API开放(能力上的开放),允许研究人员试用、探索和评估现有模型的能力和限制。

第三层模型权重开放和训练数据开放(应用上的开放)。允许研究人员改进现有模型,让研究人员更好地理解数据在模型使用中发挥的作用。

第四层模型结构、权重、计算能力开放(创新上的开放),允许研究人员尝试新的体系结构、训练目标和过程、进行数据融合,并在不同的领域开发全新的模型。

其实,早在2021年中国的几个AI大模型的头部玩家就已开源了大模型的训练代码、推理代码、免费API甚至模型参数,已经是第三层和第四层的开放了。像浪潮源1.0模型,其参数规模高达2457亿,训练采用的中文数据集达5000GB,相比GPT-3模型1750亿参数量和570GB训练数据集,“源1.0”参数规模领先40%,训练数据集规模领先近10倍。“源1.0”在语言智能方面表现优异,获得中文语言理解评测基准CLUE榜单的零样本学习和小样本学习两类总榜冠军,测试结果显示,人群能够准确分辨人与“源1.0”作品差别的成功率已低于50%。

目前开发者可以在源1.0”官网https://air.inspur.com提出申请,经审核授权后即可免费使用“源1.0”模型API,基于“源1.0”模型探索算法创新以及开发各类智能化应用。