作者:寒江大哥_599 | 来源:互联网 | 2023-07-21 18:25

大数据学习02_Hadoop:Hadoop运行模式Hadoop运行模式本地模式运行模式例子1:gerp案例例子2:WordCount案例伪分布式运行模式启动HDFS并运行MapRe

大数据学习02_Hadoop: Hadoop运行模式

- Hadoop运行模式

- 本地模式运行模式

- 例子1:gerp案例

- 例子2: WordCount案例

- 伪分布式运行模式

- 启动HDFS并运行MapReduce程序

- 启动YARN并运行MapReduce程序

- 历史服务器

- 完全分布式运行模式

- 虚拟机集群分发脚本

- 集群配置

- 集群单点启动

- SSH无密登录配置

- 群起集群

- 启动集群

Hadoop运行模式

Hadoop运行模式包括: 本地模式,伪分布式模式及完全分布式模式

Hadoop官方网站: http://hadoop.apache.org/

本地模式运行模式

例子1:gerp案例

- 在hadoop-2.7.2目录下面创建一个

input/文件夹mkdir input

- 将Hadoop的xml配置文件复制到

input/cp etc/hadoop/*.xml input

- 执行

share目录下的MapReduce程序hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar grep input output 'dfs[a-z.]+'

- 查看输出结果

cat output/*

例子2: WordCount案例

- 在hadoop-2.7.2目录下面创建一个

wcinput/文件夹mkdir wcinput

- 在

wcinput/文件下创建一个wc.input文件cd wcinput

touch wc.input

- 编辑

wc.input文件,在文件中输入如下内容hadoop yarn

hadoop mapreduce

atguigu

atguigu

- 回到Hadoop根目录

/opt/module/hadoop-2.7.2 - 执行程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount wcinput wcoutput

- 查看结果

cat wcoutput/part-r-00000atguigu 2

hadoop 2

mapreduce 1

yarn 1

伪分布式运行模式

启动HDFS并运行MapReduce程序

-

配置集群:

-

在etc/hadoop/hadoop-env.sh中将${JAVA_HOME}改为其绝对路径

(可以使用echo ${JAVA_HOME}获得其绝对路径)

-

配置etc/hadoop/core-site.xml,在根节点下添加下列节点:

<property><name>fs.defaultFSname><value>hdfs://hadoop100:9000value>

property>

<property><name>hadoop.tmp.dirname><value>/opt/module/hadoop-2.7.7/data/tmpvalue>

property>

-

配置etc/hadoop/hdfs-site.xml,在根节点下添加下列节点:

<property><name>dfs.replicationname><value>1value>

property>

-

启动集群

- 格式化

NameNodebin/hdfs namenode -format

- 启动

NameNodesbin/hadoop-daemon.sh start namenode

- 启动

DataNodesbin/hadoop-daemon.sh start datanode

-

查看集群

-

查看是否启动成功

jps13586 NameNode

13668 DataNode

13786 Jps

jps是JDK中的命令,不是Linux命令.不安装JDK不能使用jps.

-

web端查看HDFS文件系统:

在浏览器中打开http://hadoop101:50070查看HDFS文件系统

-

操作集群

- 在

HDFS文件系统上创建一个input/文件夹hdfs dfs -mkdir -p /user/atguigu/input

- 将测试文件内容上传到文件系统上

hdfs dfs -put wcinput/wc.input /user/atguigu/input/

- 查看上传的文件是否正确

hdfs dfs -ls /user/atguigu/input/

hdfs dfs -cat /user/atguigu/ input/wc.input

- 运行MapReduce程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.7.jar wordcount /user/atguigu/input/ /user/atguigu/output

- 查看输出结果

命令行查看:bin/hdfs dfs -cat /user/atguigu/output/part-r-00000

浏览器查看:

- 将测试文件内容下载到本地

hdfs dfs -get /user/atguigu/output/part-r-00000 ./wcoutput/

启动YARN并运行MapReduce程序

-

配置集群

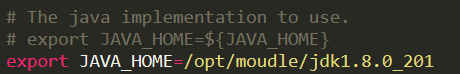

- 在

etc/hadoop/yarn-env.sh,添加JDK的绝对路径:export JAVA_HOME&#61;/opt/module/jdk1.8.0_201

- 配置

etc/hadoop/yarn-site.xml,在根节点下添加下列节点:

<property><name>yarn.nodemanager.aux-servicesname><value>mapreduce_shufflevalue>

property>

<property><name>yarn.resourcemanager.hostnamename><value>hadoop100value>

property>

- 在

etc/hadoop/mapred-env.sh,添加JDK的绝对路径:export JAVA_HOME&#61;/opt/module/jdk1.8.0_201

- 将

etc/hadoop/mapred-site.xml.template重新命名为etc/hadoop/mapred-site.xml并在根节点下添加如下节点:

<property><name>mapreduce.framework.namename><value>yarnvalue>

property>

-

启动集群

- 先启动

NameNode和DataNode - 启动

ResourceManager:yarn-daemon.sh start resourcemanager

- 启动

NodeManageryarn-daemon.sh start nodemanager

-

集群操作

- 查看是否启动成功

jps4289 Jps

3014 NameNode

4183 NodeManager

3933 ResourceManager

3117 DataNode

- web端查看

YARN集群的浏览器页面查看:

在浏览器中打开http://hadoop101:8088/cluster查看YARN集群 - 删除文件系统上的

output文件bin/hdfs dfs -rm -r /user/atguigu/output

- 执行MapReduce程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.7.jar wordcount /user/atguigu/input /user/atguigu/output

- 查看运行结果

hdfs dfs -cat /user/atguigu/output/part-r-00000

历史服务器

配置历史服务器

为了查看程序的历史运行情况,需要配置历史服务器. 具体配置步骤如下&#xff1a;

- 配置

etc/hadoop/mapred-site.xml,在其根节点下添加如下节点

<property><name>mapreduce.jobhistory.addressname><value>hadoop101:10020value>

property>

<property><name>mapreduce.jobhistory.webapp.addressname><value>hadoop101:19888value>

property>

- 启动历史服务器

mr-jobhistory-daemon.sh start historyserver

- 查看历史服务器是否启动

jps4997 JobHistoryServer

3014 NameNode

4183 NodeManager

5050 Jps

3933 ResourceManager

3117 DataNode

- web端查看

JobHistory:

在浏览器中打开http://hadoop100:19888/jobhistory查看JobHistory

配置日志的聚集

日志聚集概念: 应用运行完成以后,将程序运行日志信息上传到HDFS系统上

日志聚集功能好处: 可以方便的查看到程序运行详情,方便开发调试

开启日志聚集功能,需要重新启动NodeManager, ResourceManager, HistoryManager

- 配置

etc/hadoop/yarn-site.xml,在根节点下添加如下节点

<property><name>yarn.log-aggregation-enablename><value>truevalue>

property>

<property><name>yarn.log-aggregation.retain-secondsname><value>604800value>

property>

- 重新启动

NodeManager, ResourceManager, HistoryManager

yarn-daemon.sh stop resourcemanager

yarn-daemon.sh stop nodemanager

mr-jobhistory-daemon.sh stop historyserver

yarn-daemon.sh start resourcemanager

yarn-daemon.sh start nodemanager

mr-jobhistory-daemon.sh start historyserver

- 再运行MapReduce程序可以在

http://hadoop100:19888/jobhistory查看JobHistory

完全分布式运行模式

虚拟机集群分发脚本

虚拟机集群分发脚本xsync,内容如下

#!/bin/bash

pcount&#61;$

if((pcount&#61;&#61;0)); thenecho no args;exit;

fi

p1&#61;$1

fname&#61;&#96;basename $p1&#96;

echo fname&#61;$fname

pdir&#61;&#96;cd -P $(dirname $p1); pwd&#96;

echo pdir&#61;$pdir

user&#61;&#96;whoami&#96;

for((host&#61;102; host<105; host&#43;&#43;)); doecho ------------------- hadoop$host --------------rsync -rvl $pdir/$fname $user&#64;hadoop$host:$pdir

done

将脚本放在/usr/local/sbin目录下.

集群配置

-

集群部署规划

| | hadoop102 | hadoop103 | hadoop104 |

|---|

| HDFS | NameNode

DataNode | DataNode | SecondaryName

NodeDataNode |

| YARN | NodeManager | ResourceManager

NodeManager | NodeManager |

-

配置集群

- 核心配置文件:

etc/hadoop/core-site.xml

<property><name>fs.defaultFSname><value>hdfs://hadoop102:9000value>

property>

<property><name>hadoop.tmp.dirname><value>/opt/module/hadoop-2.7.7/data/tmpvalue>

property>

- HDFS配置文件:

-

配置etc/hadoop/hadoop-env.sh

export JAVA_HOME&#61;/opt/module/jdk1.8.0_201

-

配置etc/hadoop/hdfs-site.xml

<property><name>dfs.namenode.secondary.http-addressname><value>hadoop104:50090value>

property>

- YARN配置文件

-

配置etc/hadoop/yarn-env.sh

export JAVA_HOME&#61;/opt/module/jdk1.8.0_201

-

配置etc/hadoop/yarn-site.xml

<property><name>yarn.nodemanager.aux-servicesname><value>mapreduce_shufflevalue>

property>

<property><name>yarn.resourcemanager.hostnamename><value>hadoop103value>

property>

- MapReduce配置文件

-

配置etc/hadoop/mapred-env.sh

export JAVA_HOME&#61;/opt/module/jdk1.8.0_201

-

配置etc/hadoop/mapred-site.xml

<property><name>mapreduce.framework.namename><value>yarnvalue>

property>

-

在集群上分发配置好的Hadoop配置文件

xsync /opt/module/hadoop-2.7.7/

-

查看文件分发情况

cat /opt/module/hadoop-2.7.7/etc/hadoop/core-site.xml

集群单点启动

- 如果集群是第一次启动,需要格式化NameNode. 如果集群曾经被启动过,要删除

data/和logs/目录rm -rf data/ logs/

hadoop namenode -format

- 在

hadoop102上启动NameNodehadoop-daemon.sh start namenode

jps

- 在

hadoop102, hadoop103, hadoop104上分别启动DataNodehadoop-daemon.sh start datanode

jps

SSH无密登录配置

-

SSH登录的密钥存储在~/.ssh目录下.

其中id_rsa文件存储私钥,id_rsa.pub文件存储公钥.

-

生成密钥的命令如下:

ssh-keygen -t rsa

-

将公钥拷贝到要免密登录的目标机器命令如下:

ssh-copy-id hadoop102

ssh-copy-id hadoop103

ssh-copy-id hadoop104

群起集群

-

在etc/hadoop/slaves文件中配置slaves,增加如下内容

hadoop102

hadoop103

hadoop104

注意: 该文件中添加的内容结尾不允许有空格,文件中不允许有空行.

slaves中要包含节点自身

-

同步所有节点配置文件

xsync slaves

启动集群

- 如果集群是第一次启动,需要格式化

NameNodehdfs namenode -format

- 启动HDFS: 启动所有

slaves的NameNode和DataNodestart-dfs.sh

- 启动YARN: 启动所有

slaves的ResourceManger和NodeMangerstart-yarn.sh

要在ResouceManager所在的机器上启动YARN