作者:手机用户2702937647 | 来源:互联网 | 2024-11-17 16:19

前言不管是训练过程中,查看网络学习的状态,还是训练结束后,使用模型去执行特定任务,都需要一个可被观察的输出呈现在研究者面前,最好是可视化的图形而非冰冷的数字。因此,本次讲的是通过c

前言

不管是训练过程中,查看网络学习的状态,还是训练结束后,使用模型去执行特定任务,都需要一个可被观察的输出呈现在研究者面前,最好是可视化的图形而非冰冷的数字。因此,本次讲的是通过 caffe 自带的工具(scripts)进行日志的可视化分析与目标检测结果的输出。

前期准备

一、日志可视化

首先要保证之前训练时,在最后增加了 tee logDir/logName.log ,这样才能得到可供分析的日志 (.log)文件(我的日志文件名为 molo-train-2019-03-11-09-50.log)。

然后要保证 caffe_rootdir/tools/extra/ 下存在 parse_log.sh、extract_seconds.py 和 plot_training_log.py.example。

二、目标检测可视化

本次使用的模型检测脚本也来自 MobileNet-YOLO,通过对其中的 ./examples/ssd/ 中 ssd_detec.py 进行修改,达到调用模型进行目标检测的目的。

操作流程

一、日志可视化

- 将 parse_log.sh、extract_seconds.py 和 plot_training_log.py.example 三个文件和 .log 文件放置在同一文件夹下,运行 parse_log.sh 脚本:

. parse_log.sh molo-train-2019-03-11-09-50.log

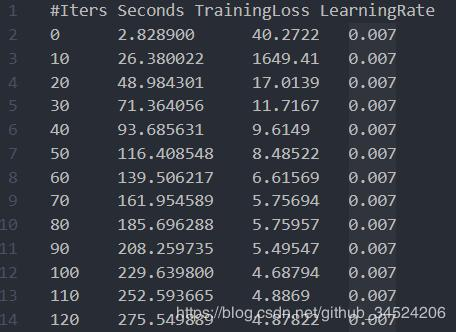

即可在当前目录下生成 molo-train-2019-03-11-09-50.log.train 和 molo-train-2019-03-11-09-50.log.test 两个文件,内容如下图所示

- 将 plot_training_log.py.example 改为 plot_training_log.py,其他的不需要多做修改(因为我在无UI界面的系统进行操作,所以仅仅注释了 plt.show())。然后运行:

python plot_training_log.py 6 out.png molo-train-2019-03-11-09-50.log

即可得到 out.png 如下。

- 其中,命令中间的 6 代表要输出的曲线类型,比如 “0” 代表 “验证集正确率-迭代次数”,具体的参数如下:

0: Test accuracy vs. Iters

1: Test accuracy vs. Seconds

2: Test loss vs. Iters

3: Test loss vs. Seconds

4: Train learning rate vs. Iters

5: Train learning rate vs. Seconds

6: Train loss vs. Iters

7: Train loss vs. Seconds

二、模型调用可视化流程

对于 Mobile-yolo 的 ssd_detect.py 脚本,设定好 caffe 相关的参数后,输入要测试的图片,即可输出在该图片上绘制出 bounding box 的图片。下面简单介绍一下该脚本。

首先列出使用情况:

python ssd_detect.py \

--gpu_id 0 \

--labelmap_file labelmap_dir/labelmap.prototxt \

--model_def model_dir/deploy.prototxt \

--model_weights weight_dir/iter_XXX.caffemodel \

--image_resize 608 \

--image_file test_img_dir/img.JPG

为了方便起见,比起这种方法,更推荐在脚本中增加一个待测图片文件的循环,将除了待测文件之外的参数确定后,可以执行一次脚本得到多张输出,效率更高一些。

该脚本的运行逻辑是:

- 利用所给的前 5 个参数对 caffe 进行初始化;

- 将 labelmap 转为 caffe 所使用的数据结构,其他的 caffe 会直接加载;

- 读入测试图片,根据输入的权重跑完整个网络,得到多组输出(和网络结构有关,包含阈值判断、NMS等操作);

- 把所有数据(4个坐标点、一个置信度、多个类别)中置信度高于阈值的部分取出,按照其坐标点在原图上绘制 bounding box,然后标注上得分最高的类别的分数,完成对所有网络检测出的目标的标注;

- 保存标注后的图片以便研发人员观察。

该脚本本身的使用相对简单,最难的部分已经被 caffe 承包了,可以说得上友好了~

由于训练的模型和最终的输出涉及到一点公司机密,这里不方便奉上,于是找了

Jesse_Mx 的博客 中的图片用于展示:

Ps:实在不喜欢用 PIL 库,我自己使用的时候改成 openCV 了,目的单纯是为了画框更漂亮……

deploy.prototxt 简介

在所有的和网络有关的 prototxt 文件中,除了 train、test 和 solver,还有一个 deploy,这个网络是在 test 文件的基础上进一步精简的,data 层不再需要设定 lmdb 等,只需改成如下部分:

layer {

name: "data"

type: "Input"

top: "data"

input_param {

shape {

dim: 1

dim: 3

dim: 608

dim: 608

}

}

}

代表输入图维度为 608×608×3(这也是为什么 ssd_detect.py 需要 resize 参数),其他的都和 test 网络相同。

事实上,deploy.prototxt 更应该看作 train.prototxt 删除训练所需要的部分后,余下的部分,这里展开又可以讲整整一篇,这里引用 不破楼兰终不还的博客,其讲解分析十分细致,十分推荐大家读一下,如果有时间我也自己进行一下整理,就不再这个实践相关更多一点的博客中过多陈述了。

后记

第一次使用 caffe 训练目标检测网络,不论是从损失的下降还是最终的检测效果,都有些不(mo)尽(ming)人(qi)意(miao)。但是俗话说的好,万事开头难,流程跑通之后,通过优化网络结构、筛选数据、调整训练参数等方法进行优化,一定能得到相当不错的检测效果的~