作者:普罗土 | 来源:互联网 | 2024-12-02 10:55

本文由吴裕雄撰写,深入探讨了如何利用Python、Keras及TensorFlow构建混合神经网络模型,特别是通过结合递归神经网络(RNN)和卷积神经网络(CNN),实现对网络运行效率的有效提升。

在本文中,我们将通过具体的代码示例,展示如何在Keras框架下构建一个结合了RNN和CNN的混合模型,用于提高网络的运行效率。以下是模型构建的主要步骤:

from keras.models import Sequential

from keras.layers import Embedding, Conv1D, MaxPooling1D, GRU, Dense

model = Sequential()

model.add(Embedding(input_dim=vocab_size, output_dim=embedding_dim, input_length=maxlen))

# 利用一维卷积网络处理输入数据,设置滤波器大小为32,核大小为5

model.add(Conv1D(filters=32, kernel_size=5, activation='relu'))

# 使用最大池化层进一步压缩数据,设置池化窗口大小为3

model.add(MaxPooling1D(pool_size=3))

# 添加GRU层,GRU是一种简化版的LSTM,具有较快的训练速度

model.add(GRU(units=32, dropout=0.1))

model.add(Dense(units=num_classes, activation='softmax'))

# 配置模型,选择合适的优化器、损失函数和评估指标

model.compile(optimizer='rmsprop', loss='categorical_crossentropy', metrics=['accuracy'])

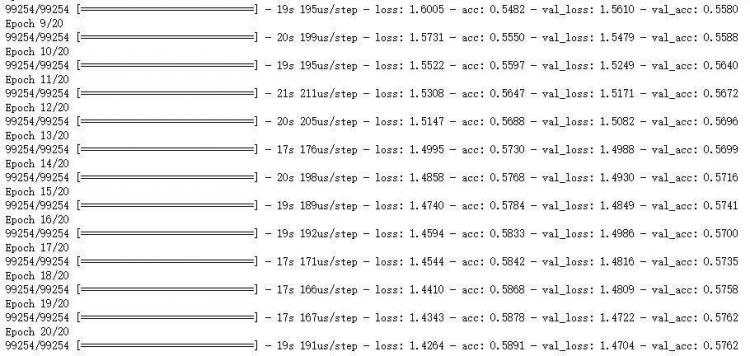

# 训练模型,设置训练轮数、批量大小及验证集

history = model.fit(x_train, y_train, epochs=20, batch_size=512, validation_data=(x_val, y_val))

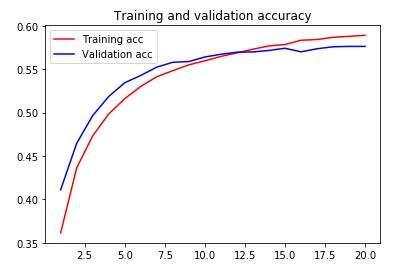

在完成模型训练后,我们可以通过绘制训练过程中的准确率和损失曲线来评估模型的表现:

import matplotlib.pyplot as plt

acc = history.history['accuracy']

val_acc = history.history['val_accuracy']

loss = history.history['loss']

val_loss = history.history['val_loss']

epochs = range(1, len(acc) + 1)

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.plot(epochs, acc, 'bo', label='Training accuracy')

plt.plot(epochs, val_acc, 'b', label='Validation accuracy')

plt.title('Training and validation accuracy')

plt.legend()

plt.subplot(1, 2, 2)

plt.plot(epochs, loss, 'bo', label='Training loss')

plt.plot(epochs, val_loss, 'b', label='Validation loss')

plt.title('Training and validation loss')

plt.legend()

plt.show()