本文为数据茶水间群友原创,经授权在本公众号发表。

关于作者:DD-Kylin,一名喜欢编程与机器学习的统计学学生,勤学好问,乐于钻研,期待跟大家多多探讨机器学习的相关内容~

我们知道,回归模型可以解决因变量为连续变量的问题,但是,如果因变量为分类变量的话,用回归的方法就行不通了。这个时候我们就得选择用其他的分类方法了,如决策树、随机森林、SVM等。而本篇文章要说的逻辑回归也是一种很好的分类方法。我们需要明确的一点是,逻辑回归虽然是“回归”,但是它本质上是一种二分类算法,用来处理二分类问题的。

回答:逻辑回归是一种二分类算法,一般用来解决二分类问题,但是它也可以用来解决多分类问题,当使用它来解决多分类问题的时候,由于逻辑回归的特点,我们一般将多分类问题转化为二分类问题。这里多分类问题的转化有三种拆分策略,分别是一对一、一对其余和多对多。通过多分类拆分策略,我们可以使用逻辑回归来进行多分类问题的预测。但是这种方法我们一般不用,因为多分类问题我们可以使用随机森林、朴素贝叶斯、神经网络这些更好的算法进行预测。

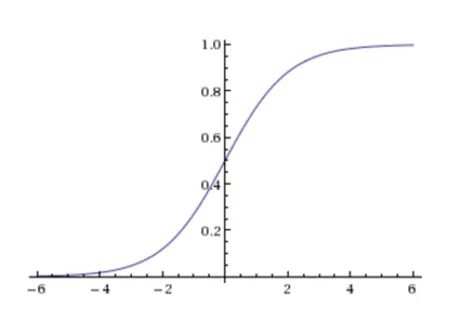

回答:逻辑回归是通过判断数据属于某一类的概率值大小来决定要将该数据判为哪一类。这里需要引入sigmoid函数(Y = 1/(1+e-z) , 其中z = wTx+b

回答:不一定。可以通过人为地进行修改的。逻辑回归输出的是概率,即将Sigmoid函数输出的y视为正例的可能性,我们可以自定义分类阈值来改变分类的结果。

回答:因为sigmoid函数中,z = wTx+b,其中 w和b都是未知的,使用极大似然估计法是为了求出w和b使得每个样本属于其真实标记的概率值越大越好。 但是最大化似然函数的求解有点困难,所以将其转为求解最小值,即在求得的目标似然函数前面加上一个负号转为求解最小值。由于改变符号后的目标函数是高阶可导连续凸函数,于是可以使用梯度下降法、牛顿法等来求解它的最小值,通过函数的转化就可以较为轻松地求出w和b,进而也就能知道sigmoid函数的输出了。

注:逻辑回归是一种判别模型

回答:逻辑回归的应用其实跟它的算法特点有很大的关系。由于逻辑回归是一种性能很好的二分类算法。所以逻辑回归几乎可以应用于任何需要二分类的问题。如癌症检测、垃圾邮件分类、广告点击预测、医疗效果分析等。

回答:

逻辑回归的优点分别是:

逻辑回归的缺点分别是:

关于逻辑回归,我一直觉得它是一个很简单但是很强大的算法,直到在写这篇文章的时候,才发现原来它有那么多知识点需要理解。本文也只是起到一个抛砖引玉的作用,如果大家想了解更多的话,建议各位可以去看一下书,练一下真实的案例,肯定可以收获更多的理解!下面留几个讨论题:

更多数据挖掘内容:

数据挖掘面试题之:梯度提升树

数据挖掘面试题之:朴素贝叶斯

数据挖掘面试题之:生成模型 VS 判别模型

数据挖掘知识点串烧:SVM

特征工程系列:数据清洗

特征工程系列:特征筛选的原理与实现(上)

特征工程系列:特征筛选的原理与实现(下)

特征工程系列:特征预处理(上)

特征工程系列:特征预处理(下)

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有