Rocky Ding

写在前面

【AI行研&商业价值分析】栏目专注于分享AI行业中最新热点/风口的思考与判断。也欢迎大家提出宝贵的意见或优化ideas,一起交流学习💪

大家好,我是Rocky。

2022年底,ChatGPT横空出世,火爆全网,一时风光无限。人工智能领域的浪潮再次汹涌澎湃,人工智能行业的全栈架构(芯片层,框架层,模型层和应用层)都产生了爆破性机会的可能,各架构中的巨头纷纷下注入场。

但与此同时,“危!以下行业可能被人工智能替代”,“ChatGPT将彻底改变XX行业”,“ChatGPT的出现,XX公司会大势已去”,“ChatGPT会马上取代你!”等等言论也甚嚣尘上。

Rocky认为ChatGPT是迄今为止最具ToC落地优势的AI产品,ToC意味着高上限以及无限的迭代可能性。

在本系列的上一篇文章中,Rocky已经与ChatGPT“谈笑风生”了一回。Rocky和ChatGPT“谈笑风生”的日子 |【AI行研&商业价值分析】

那么在此基础上,Rocky继续深挖核心价值,我们到底该怎么看待ChatGPT?ChatGPT的前世今生以及未来是怎么样的?有哪些潜在玩家跃跃欲试?如何看待ChatGPT的商业价值和影响冲击?

在本文中,Rocky将为大家娓娓道来。

So,enjoy:

正文开始

----【目录先行】----

-

ChatGPT的底层原理

-

OpenAI的前世今生

-

风口里的潜在玩家

-

ChatGPT的商业价值

-

ChatGPT对原有行业的冲击

-

Rocky的一些“畅想”

ChatGPT的底层原理

在这个章节中,我们主要探讨“ChatGPT到底是什么?”,“ChatGPT有哪些关键特征?”以及“ChatGPT有着什么样的发展脉络?”这几个问题。

首先,ChatGPT到底是什么?

按照惯例,我们先让ChatGPT自己回答:

Rocky在此基础上接着进行补充,从宏观技术角度总结归纳ChatGPT的概念:

ChatGPT是一个超大规模的语言预训练模型,其底层架构为Transformer,并结合强化学习思想,在拥有上千亿的参数量的同时,使用上万亿的高质量训练素材进行迭代优化。

看完Rocky的总结,我们可以发现ChatGPT并没有那么神秘,在“大力出奇迹”式的参数量,算力和数据量的支撑下,ChatGPT本质上是一个对自然语言进行深度建模的高维函数,有足够的表达能力能cover大多数的对话问答场景。

强化学习本身在Alpha Go中已经证明它的价值,其非常像生物进化的方式,能让ChatGPT在定义的环境中,不断地根据环境的惩罚和奖励(reward),持续优化到能在这个特定环境中从容应对的状态。

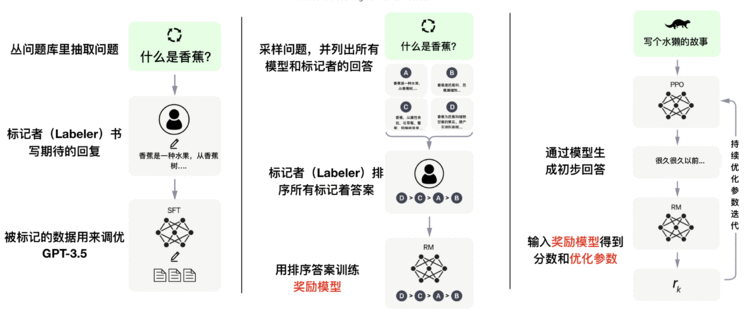

那么在上万亿级别数据量的情况下,该如何设计强化学习的reward模型并进行高效reward呢?答案就是人工反馈,也被称为RLHF(Reinforcement Learning from Human Feedback)。

写到这里,“ChatGPT到底是什么?”的问题应该已经能够得到较为全面的回答,Rocky再将上面的内容进行提炼归纳,就可以得到ChatGPT的关键特征:

- 千亿参数

- 万亿数据

- 海量算力

- 强化学习+“人工”智能

可以看到,这是一场昂贵的,门槛极高的技术变革。

而正是这些关键特征,造就了ChatGPT的核心能力:

- 敢于质疑“不怀好意”和不正确的假设与问题

- 主动承认错误

- 能够承认无知(无法回答的问题)

- 能够连续多轮对话

- 能够进行上下文理解

- 大幅提升对用户意图的理解

- 大幅提升结果的准确性

在本章节的最后一个部分,我们接着梳理一下ChatGPT的发展脉络,看看ChatGPT如何从“原始形态”一步一步进化而来的:

-

时间周期:可以看到,每个阶段的发展周期短则需要10年,长则需要30年。

-

参数量:从无参数的规则方式,到需要参数的机器学习方式,再到需要大量参数的神经网络方式

-

技术演进:从规则,到机器学习,再到神经网络,进而到Transformer。

-

算力成本:从无需算力到需要海量算力。

-

人工支持:从机器的自主学习到人工反馈强化。

总而言之,ChatGPT为了与我们相遇,花费了漫长时间的努力。这中间,有挫折,有低谷,有突破,有爆发,在那个沉默的岁月中,依然有“人”一直陪伴在它身边,那就是OpenAI。在下一个章节中,Rocky将向大家讲述OpenAI的故事。

OpenAI的前世今生

OpenAI的总部位于旧金山,由马院士(马斯克)、Sam Altman及其他投资者在2015年共同创立,启动资金10亿美元,目标是推动和促进AI技术的研究,而马斯克在2018年时因与其他创始人产生分歧而离开。

OpenAI的主要研究方向分为:计算机视觉,自然语言处理,强化学习。

2016年,OpenAI开发的人工智能系统在《Dota 2》游戏中击败了职业玩家。

之后,OpenAI更是因推出GPT系列自然语言处理模型而闻名。从2017年起,OpenAI就开始发布生成式预训练语言模型GPT(Generative Pre-trained Transformer),可用于生成文章、代码、机器翻译、问答等各类内容。

每一代GPT模型的参数量都爆炸式增长,堪称“越大越好”。2019年发布的GPT-2参数量为15亿,而2020年发布的GPT-3,参数量达到了1750亿。

而ChatGPT每一次训练更是需要花费亿级别的费用,备用资金储备的量级可想而知。2022年,OpenAI光是算力+人工支出,就达到了约5亿美元,也就是约35亿人民币。

如此高的研究成本与研究门槛,标志着新一代科技革命进程也开始遵循二八法则。

AI前沿突破的主动权,从过去自由、粗放、百花齐放的状态,转而形成高度垄断的态势。

比如在OpenAI接连开发出DALL- E和ChatGPT这两个重量级生成式AI模型后,微软决定向OpenAI投资数十亿美元,新一轮投资也让其估值达到290亿美元。

是的,恍惚间仿佛回到了2012年,上一次AI给人们带来无限想象的时间节点。

而这次的主角是OpenAI的联合创始人Sam Altman。

在Sam Altman眼中,AI是一个可以孵化出无数工具,推动各行各业前进的基础平台。AI大模型技术,将成为继移动互联网之后,未来最大的技术平台。而以聊天机器人为界面,加上图像、音乐、文本等多模态模型的持续发展,终将诞生新的巨头。

“先做摆在我们面前的最有信心能成功的事情,然后分出10%的资源进行成功确定性更低的探索工作。”———— Sam Altman

OpenAI现阶段并没有把重点放在让AI“无所不能”上,而是先沿着现有的道路慢慢发展完善AI,然后留有开放探索的空间——伟大的事物和重大的突破有时往往诞生于持续坚持中的偶然。

风口里的潜在玩家

2022年可以说是AIGC元年,首先出现了图像生成式模型,比如DALL-E和Stable Diffusion,然后便是ChatGPT火爆出圈,发布仅两个月后,其月活用户就已经突破了1亿,成为史上用户增长速度最快的消费级应用程序。如此惊人的扩张速度,表明我们很有可能正在进入一个新的技术纪元。

在这个炙手可热的新风口中,各方势力暗流涌动,争相布局入场,未来的AI超大模型江湖定会波澜壮阔,高手过招。

巨头下场:

- 微软:与ChatGPT火速绑定,出现ChatGPT版新Bing。

- 谷歌:推出竞品Bard,并向由前OpenAI员工创立的Anthropic公司补救性投资4亿美元。

- 百度:文心一言(Ernie Bot)将于三月份向公众开放。

总之,全球最大的科技公司仿佛都回到了自己年轻时的样子。

可以看到,ChatGPT的商业落地速度比想象中还要快,而一年前还“性感异常”的元宇宙概念,现在已经“牛夫人”,商业落地更是遥遥无期。

巨头之外:

除了上面讲到的一些科技巨头已经稳稳拿住入场券,还有很多其他势力在争夺入场资格。

- 一些已经退休/转VC的大佬们想要带资进组。

- 一些高管想要出厂单干,但高管的问题是能力相对单一,基本面能力可能不够,意志不坚定。

- 一些初创公司想要入场,但是初创公司能不能把商业闭环跑通还是一个问号。

- 由于生成式AI还处于比较专业的阶段,所以很多高校教授们也看到了自己入局的可能性。虽然有一堆弟子可以在一线干活,但是创业需要的综合能力与基本面并不一定具备。

- 活跃战场氛围的吃瓜公司与追梦者。

Rocky观点:

这波浪潮在宏观上需要很高的门槛和昂贵的成本,国内外最终大概率会回归到头部巨头的竞争。在细分领域,等未来这波浪潮持续落地赋能之后,会出现一些新的机会,但对数据的护城河和数据迭代能力(本身有很多行业数据可以训练出优秀的模型,从而吸引更多用户,继而产生更多用户数据用于训练,形成良性优化迭代)要求非常高,这是大部分公司所不具备的。

ChatGPT的商业价值

-

Rocky认为ChatGPT有非常大的想象空间。比起元宇宙等概念,用户对ChatGPT有更强的感知,ToC落地前景向好。

-

以ChatGPT为代表的超大AI模型,有机会可以成为孵化各种AI应用的平台,就像移动互联网的出现催生出众多APP一样,它们的共同点都是可以制造无数的商业机会。

-

未来在超大AI基础模型和具体AI业务的开发应用之间会有一个中间媒介,会出现一些专注于微调超大AI基础模型以适应具体AI业务需求的初创企业,为每个垂类场景创建应用解决方案,比如广告创意,会议纪要生成,社交媒体文案等。Rocky认为这些中间媒介会创造很多价值。

-

未来很可能会出现提示工程师(Prompt Engineer)。提示工程是指在任务的描述、或者提问中找出合适的提示词输入AI模型中,激发AI模型输出理想结果的调试过程。

-

能够独立思考,深度思考,思考质量极佳,对事物本质理解深刻的人,能够从AI大模型中获取更多高价值的回馈。

-

作为AI工具用于提升工作效率。(会议辅助系统,辅助文字生成,代码Debug等)

-

上下游产业链会优先收益。(硬件产业链,云计算和搜索引擎巨头公司等)

ChatGPT对原有行业的冲击

ChatGPT的整体性能确实很强大,很多人担心,甚至恐慌,觉得很多岗位会像板砖手机一样,被智能手机极速替代。

其实,Rocky认为不用慌。

人们常常会低估一项技术对未来的影响,但是却高估一项技术对今天的影响。

目前来说,类ChatGPT的AI生成式大模型依然存在不足,有很多问题需要解决和完善,市场渗透程度也正在从系统市场到细分市场的转变中,而这些都不是短期能够爆破解决的,需要一定的时间周期。

短期内看,最受益的是炒作相关概念的那部分人,而最受损的是交了智商税的那部分人。

但长期来看,能够将类ChatGPT技术引入,并且达到裁员不减产能的岗位,将会受到极大冲击。

这就是本质。

比如一个企业,需要应用类ChatGPT技术完成需求,向类ChatGPT公司购买接口就可以了,不再需要相应的职能人员来完成工作。显然购买接口的费用远比人力成本要便宜得多,但类ChatGPT提供商依然能够获得巨额垄断利润。

这些岗位,可能会裁员2/3,让剩下的1/3去承担原本部门100%的工作量,并因为类ChatGPT技术的支持,能够保持产能不变,甚至扩大产能。

而对于AI研究行业,核心竞争力不再是微小细分领域的Trick尝试并发论文,算力和数据的护城河成为了关键因素,但这些关键因素是几乎大部分实验室所不具备的,这一情形会加剧AI Lab等纯研究部门的动荡与优化。

Rocky的一些“畅想”

未来,生成式AI大模型是否能带来更多振奋人心的惊喜呢?Rocky这里抛砖引玉提出了一些“畅想”:

-

未来ChatGPT能在推理阶段连接外部信息吗?比如用预训练知识+互联网最新知识作为回答的素材。

-

图像,语音和自然语言超大AI模型的多模态融合发展。

-

目前类ChatPGT模型已经可以充分“计算”对话者的意图,并进行合理的回应,那么未来会不会出现能够理解对话的本质的AI模型呢。

精致的结尾

到这里,我们已经对ChatGPT的核心价值进行了比较全面的分析。可以看到,AI领域未来将进入更高质量的发展阶段,整个生态将更加有趣。

2012年的浪潮让AI在ToB方向上扎稳脚跟,2022年的AIGC风口,让AI在ToC方向产生了诱人的可能性,而且大概率又会是一个10年的红利期。

那2032年的时候,又会是AI的哪一个风口呢?Rocky能够判断的是,AI已经是一个“不朽”的行业,能给予不断进取成长的人们以庇护。

大家喜欢本文的话,欢迎一键三连。更多人工智能行业的深度思考文章会持续发布,大家不要错过哦。