作者:袁善恩芷恩 | 来源:互联网 | 2024-11-28 11:54

本文详细探讨了DropBlock这一正则化方法在卷积神经网络中的应用与效果。通过结构化的dropout方式,即在特征图中连续区域内的单元同时被丢弃,DropBlock有效解决了传统dropout在卷积层应用时效果不佳的问题。更多理论分析及其实现细节可参考原文链接。

本文深入探讨了DropBlock作为卷积神经网络(CNN)正则化技术的有效性和应用。DropBlock是一种结构化的dropout方法,它通过在特征图中连续区域内同时丢弃多个单元来实现正则化。这种方法特别适用于卷积层,因为卷积层中的激活单元通常是空间相关的,传统的dropout方法难以有效阻止信息流。

概述

DropBlock的主要特点包括:

- 结构化dropout:与传统的随机dropout不同,DropBlock选择性地丢弃连续区域。

- 动态调整:在训练过程中逐渐增加被丢弃的单元数量,可以提高模型的准确性和鲁棒性。

- 广泛适用:不仅适用于卷积层,还可以应用于跳跃连接等其他部分。

DropBlock机制

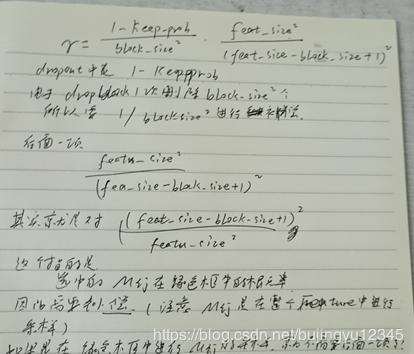

DropBlock的基本思想是在训练过程中,按照一定的概率和区域大小(block size)随机选择一个或多个连续区域,并将这些区域内的所有单元置为零。这种做法有效地打断了空间上的相关性,从而达到了更好的正则化效果。关键参数包括:

- block_size:定义每次丢弃的区域大小。

- gamma:控制丢弃比例的参数,可以根据训练进度动态调整。

实验结果

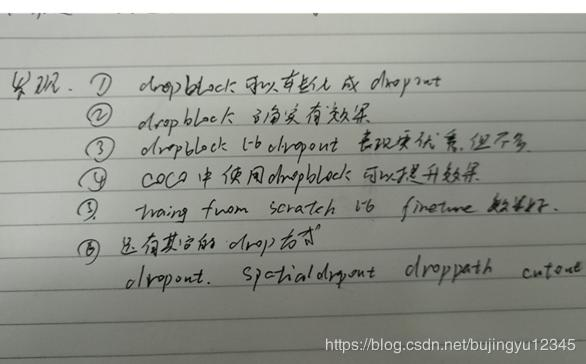

在ImageNet分类任务上,使用DropBlock的ResNet-50模型达到了78.13%的准确率,比基线模型提高了超过1.6%。在COCO目标检测任务上,DropBlock将RetinaNet的平均精度从36.8%提升到了38.4%。

讨论

DropBlock作为一种结构化的dropout方法,显著提升了卷积网络的性能。实验表明,DropBlock不仅在图像分类任务中表现优异,在目标检测和其他视觉任务中也展现了强大的正则化能力。此外,模型在使用DropBlock训练后,对超参数的选择更加鲁棒,能够学习到更加分布式的空间表示。

进一步研究方向

尽管DropBlock已经证明了其有效性,但仍有进一步优化的空间。例如,可以通过神经架构搜索(NAS)自动寻找最优的block size和gamma值,虽然预期的性能提升可能有限,但这仍然是一个值得探索的方向。

补充理解

发现

更多

考虑到DropBlock有两个主要的超参数(block size和gamma),未来的研究可以探索使用神经架构搜索技术来自动化调优这些参数,以期获得更佳的性能。然而,基于现有实验结果,即使使用神经架构搜索,性能提升的幅度可能也是有限的。