作者:周啸夫_919 | 来源:互联网 | 2023-08-21 10:45

参考http:www.cnblogs.comiPeng0564p3215055.htmlhttp:www.tuicool.comarticlesj2yayyjhttp:blog.c

参考

http://www.cnblogs.com/iPeng0564/p/3215055.html

http://www.tuicool.com/articles/j2yayyj

http://blog.csdn.net/jxlhc09/article/details/16856873

1.list databases

sqoop list-databases --connect jdbc:mysql://192.168.2.1:3306/ --username sqoop --password sqoop

2.用sqoop创建hive表

sqoop create-hive-table --connect jdbc:mysql://xx:3306/test?characterEncoding=UTF-8 --table employee --username root -password 'xx' --hive-database db_hive_edu

3.import数据

#sqoop import --connect jdbc:mysql://xx:3306/test?characterEncoding=UTF-8 --table employee --username root -password 'xx' --fields-terminated-by ',' --hive-import --hive-database db_hive_edu -m 1

--fields-terminated-by ',' 导致数据变成null

sqoop import --connect jdbc:mysql://xx:3306/test?characterEncoding=UTF-8 --username root -password 'xx' --table employee --hive-import --hive-database db_hive_edu -m 1

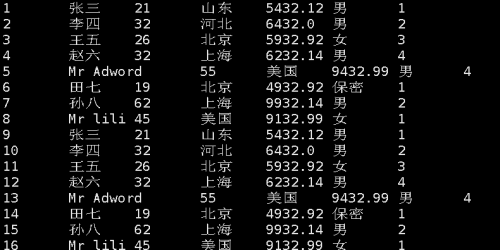

截图

如果需要实时同步,不再手动,参考

利用Flume将MySQL表数据准实时抽取到HDFS - wzy0623的专栏 - 博客频道 - CSDN.NET

这才是最正确的解决方案

本文转自 liqius 51CTO博客,原文链接:http://blog.51cto.com/szgb17/1941914,如需转载请自行联系原作者