作者:Levenmamatq_267 | 来源:互联网 | 2023-07-18 12:07

文章目录前言卷积层池化层全连接层注:前言之前曾讲到过分类问题,回归问题等等。但是都是简要概括,只讲了数据有无标签等等,关于如何对数据进行处理以及提取数据中的信息的基础知识将在本博客

前言

之前曾讲到过分类问题,回归问题等等。但是都是简要概括,只讲了数据有无标签等等,关于如何对数据进行处理以及提取数据中的信息的基础知识将在本博客中介绍。而卷积神经网络是深度学习的代表算法之一,通常用于提取数据的表征信息。最早提出于二十世纪八九十年代,后由于硬件设备算力的提升,卷积网络得到快速发展,并被应用于计算机视觉与自然语言处理等领域。

卷积层

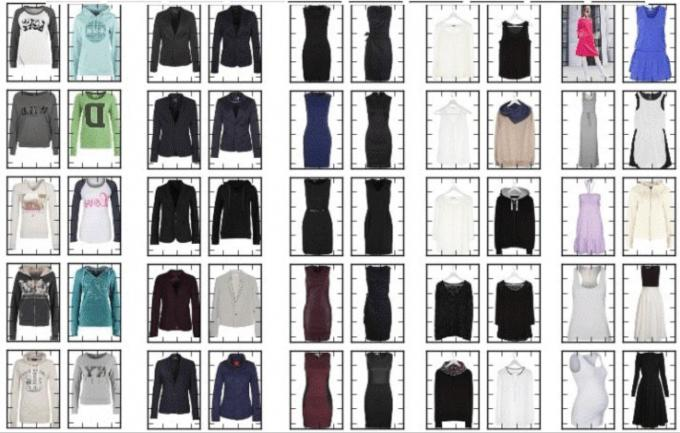

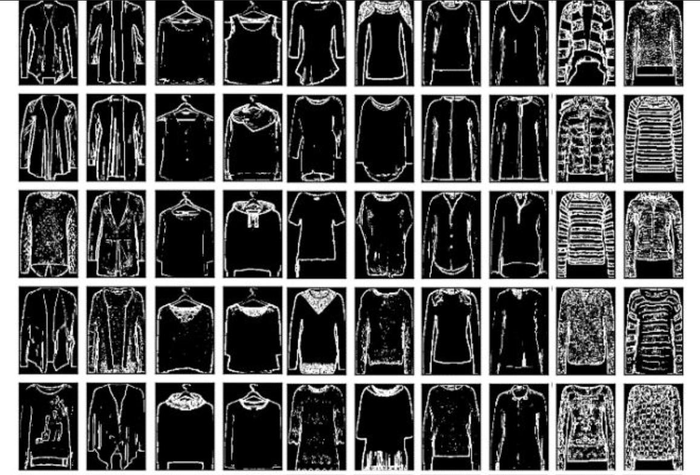

卷积运算的目的是提取输入的不同特征,第一层卷积可能就是提取图片中的低级特征,比如说边缘信息,线条等等,更多层的网络则可以从图片中提取更复杂的特征。多个不同的卷积核可以得到多个对应的特征图谱,通常一个卷积核会使用多个卷积核,提取多样性特征。

比如下图中的衣服经过卷积后得到了边缘特征:

卷积后:

卷积的执行方式:

如图所示,这里输入的图片大小为5×5,而卷积核大小为3×3,步长为1,padding为0,那么我们得到的特征图大小就是3×3。我们有公式可以直接计算:

output= stride (N+2×pad−F)+1

N:输入维度

F:卷积核大小

pad:填充

stride:步长

output:输出维度

那么通过多层的卷积核对输入图片进行处理,我们就可以得到更加丰富的特征,那么通过不断的改善卷积核的内容来提取我们希望得到的特征,这种过程就是训练。

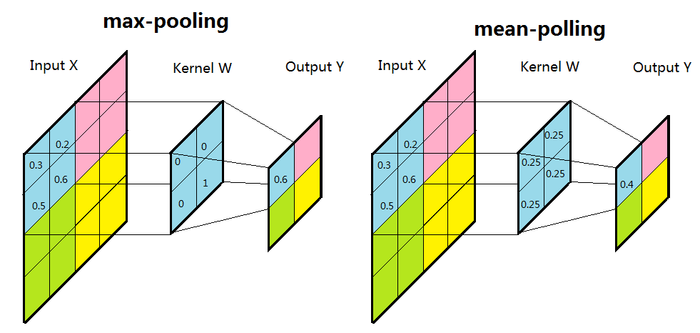

池化层通常分为最大值池化与卷积池化,通常放置在卷积层中间,用于压缩参数的量。

池化层的作用是:保证特征不变性的同时使得图像规模变小。

比如下图:

我们将图片均分为四份,并且将每份按原本的排列顺序放好,我们就可以得到四张与原图特征类似的图片。

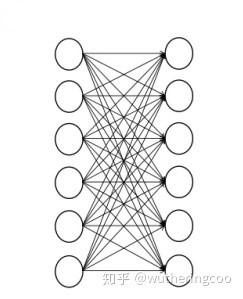

全连接层

全连接层顾名思义就是将某个东西全部连接起来,而在我们这就是将经过多层卷积池化处理后得到的较复杂的特征连接到标签上,如下图:

在网络中全连接层通常将二维信息转化成一维的向量。将前面提取到的特征整合到一起。比如说手写体识别,在经过不断的提取特征后,全连接到一个1×10的向量上,依次代表0-9,那么我们就认为值最高的那个就是这张图对应的标签。

注:

这是一些专有名词的介绍:

- learning-rate 学习率:学习率越小,模型收敛花费的时间就越长,但是可以逐步稳健的提高模型精确度。一般初始设置为0.1,然后每次除以0.2或者0.5来改进,得到最终值;

- batch_size 样本批次容量:影响模型的优化程度和收敛速度,需要参考你的数据集大小来设置,具体问题具体分析,一般使用32或64,在计算资源允许的情况下,可以使用大batch进行训练。

- eight-decay 权重衰减:用来在反向传播中更新权重和偏置,一般设置为0.005或0.001;

- epoch 训练次数:包括所有训练样本的一个正向传递和一个反向传递,训练至模型收敛即可;

- 滤波器==卷积核(Kernel Size),尺寸通常为3×3×c,也有1×1×c,7×7×c等,注意,这里的c和这层的输出的通道是一样的,比如224×224×3的图像,用3×3×c的卷积,那么这里的c就是3

- 步长(stride),卷积核运算后,滑几步到下一次,一般设置为1,2,3……若 步长 stride=1,就往右平移一个像素。

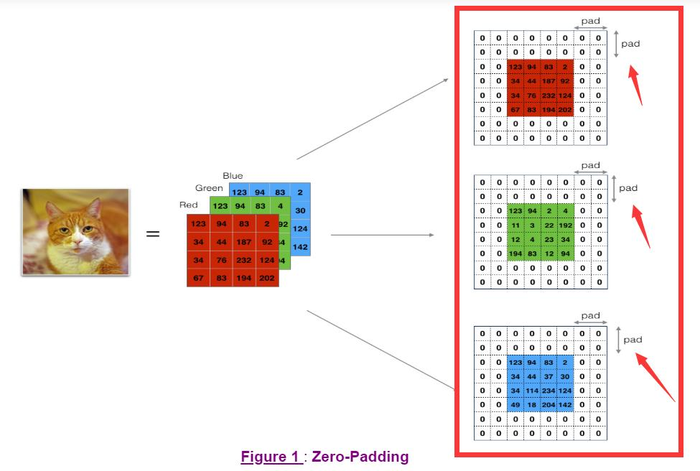

- 边缘填充(padding),用于填充输入图像的边界,就是在矩阵最外围"再裹一层",通常填0,如下图所示:

移一个像素。

- 边缘填充(padding),用于填充输入图像的边界,就是在矩阵最外围"再裹一层",通常填0,如下图所示: