LDA(线性判别式分析 Linear Discriminant Analysis)属于机器学习中的监督学习算法,常用来做特征提取、数据降维和任务分类。在人脸识别、人脸检测等领域发挥重要作用。LDA算法与PCA算法都是常用的降维技术。二者的区别在于:LDA是一种监督学习的降维技术,也就是说它的每个样本是有类别输出的,而之前所学习的PCA算法是不考虑样本类别输出的无监督降维技术。

LDA算法的目标是使降维后的数据类内方差最小,类间方差最大(即使数据在低维度上进行投影,投影后希望每一种类别数据的投影点尽可能的接近,而不同类别的数据中心之间的距离尽可能的大。)

上图中左图为PCA算法的投影方式,它所做的知识将整组数据整体映射到最方便表示这组数据的坐标轴上,映射时没有利用任何数据内部的分类信息。因此,虽然PCA可以使整组数据在表示上更加方便,但在分类上也许会变得更加困难。PCA没有分类标签,降维之后需要采用K-means等无监督的算法进行分类。

右图为LDA算法的投影方式,可以看出在增加了分类信息之后,两组输入映射到了另一个坐标轴上,这样两组数据之间就变得更易区分了,可以减少很大的运算量。

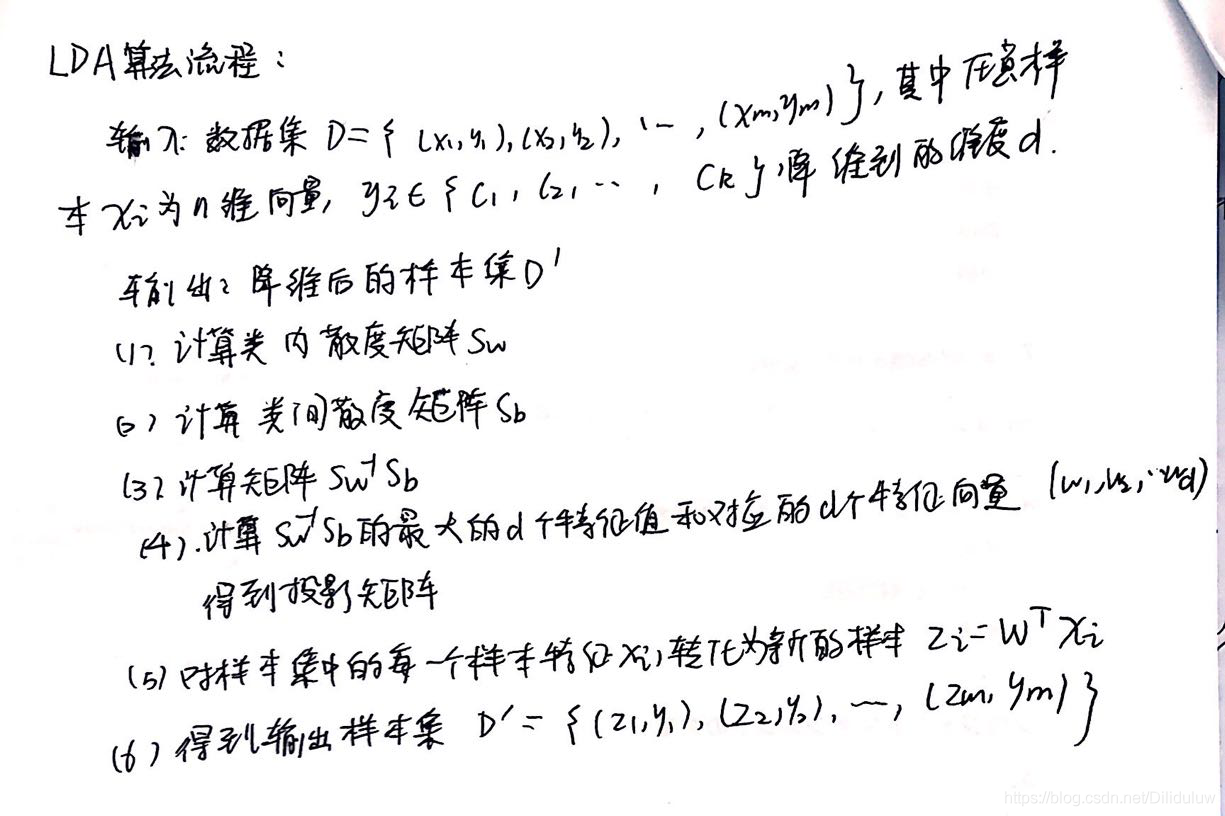

LDA的优化目标为最大类间方差和最小类内方差。LDA方法需分别计算“within-class”的分散程度Sw和“between-class”的分散程度Sb,而且希望Sb/Sw 越大越好,从而找到合适的映射向量w。其降维流程如下:

两者相同点:

不同点:

优点:

缺点:

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有