前言:

目前,学习hadoop的目的是想配合其它两个开源软件Hbase(一种NoSQL数据库)和Nutch(开源版的搜索引擎)来搭建一个知识问答系统,Nutch从指定网站爬取数据存储在Hbase数据库的表中,而Hbase运行在Hadoop之上。

学习Hadoop已有数月,想把自己的积累晒出来,一者温故知新,二者与大家分享。写文章挺费时间的,所以文风尽量简洁。若欲了解细节可发帖讨论,交个朋友。

水平有限,还望指正!

一、使用环境

操作系统:Ubuntu12.04

Hadoop版本:1.0.4

二、Hadoop官网安装手册

单机安装分为“standalone”和“pseudo-distributed”两种模式,我使用的是伪分布式模式。

手册的安装步骤很详细,没有必要当翻译工了。但是手册为了通用性,牺牲了一些关键问题的讨论。第三节中提及一下。

三、手册缺陷

手册主要有两个问题没有说清楚:

1.Hadoop安装在哪个目录下好?

选择一般有两种:/usr/local和家目录下。我选择安装在家目录下,因为开始玩hadoop的时候,这样避免了权限的麻烦;如果要部署应用的话,应该安装在/usr/local。

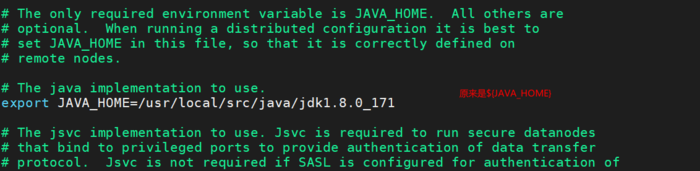

2.配置文件的问题

这是安装hadoop最重要的步骤。所有配置文件均在${HADOOP_HOME}/conf目录下。

如果完全按照手册配置,你的hadoop可能经常遇到NameNode或DataNode启动不起来的情况。配置文件的不同主要在core-site.xml.

手册配置如下:

我的配置如下: fs.default.name hdfs://localhost:9000

7

8fs.default.name

9hdfs://localhost:8020

10

11

12

13hadoop.tmp.dir

14/home/zhengeek/hadoop-tmp

15A base for other temporary directories.

16

17有两处不同:

1.9000和8020这两个端口都可以,只要没有被占用。

2.最容易出问题的地方就在这里。比如这个哥们遇到的问题。

hadoop运行起来,hdfs和mapreduce有许多数据需要保存。这可以通过dfs.name.dir 和 dfs.data.dir设置。如果没有设置,那么数据就会默认存放在/tmp目录下,如果机器重启,tmp目录下的数据就会丢失,namenode自然启动不起来了。

如果设置了hadoop.tmp.dir,那么这些数据就会默认存放在改目录下。

有关hadoop.tmp.dir设置的讨论。

四、启动hadoop

1.格式化hdfs

$bin/hadoop namenode -format

2.启动hdfs

$bin/start-all.sh

3.检查是否成功

$jps

若成功,会看到namenode,secondarynamenode,datanode,jobtracker和tasktracker五个进程。

如有问题,欢迎联系我哦。

京公网安备 11010802041100号

京公网安备 11010802041100号