作者:勇于明天2015 | 来源:互联网 | 2023-08-04 10:38

1 Glove:

论文出处&#xff1a;<>

这本书讲解Glove部分需要关注的一点是&#xff1a;

词汇表外&#xff08;Out-Of-Vocabulary OOV&#xff09; 这一概念

实现步骤&#xff1a;首先创建一个庞大的单词-上下文&#xff08;Word-Context&#xff09;共现矩阵

WC&#61;WF(Word-Feature)*FC(Feature-Content)

Word2Vec模型和Glove模型在工作方式上非常相似&#xff0c;它们的目的都是构建一个向量空间&#xff0c;每个词的位置都基于上下文和语义并且受到其相邻词的影响。

Word2vec模型从单词共现对的本地单个事例开始&#xff0c;而Glove模型从整个语料库中所有单词的全局汇总共现统计开始

-

词向量经典模型&#xff1a;从word2vec、gove、ELMO到BERT

参考链接&#xff1a;https://blog.csdn.net/xiayto/article/details/84730009

关注点&#xff1a;

对于词向量模型进化的过程有一个大致的了解&#xff0c;这对于后面深入学习有一定的帮助

word2vec

来源于2013年的论文《Efficient Estimation of Word Representation in Vector Space》&#xff0c;它的核心思想是通过词的上下文得到词的向量化表示&#xff0c;有两种方法&#xff1a;CBOW&#xff08;通过附近词预测中心词&#xff09;、Skip-gram&#xff08;通过中心词预测附近的词&#xff09;&#xff1a;

Glove:

word2vec只考虑到了词的局部信息&#xff0c;没有考虑到词与局部窗口外词的联系&#xff0c;glove利用共现矩阵&#xff0c;同时考虑了局部信息和整体的信息。来自论文《Glove: Global vectors for word representation》

ELMO

ELMO来自于论文《Deep contextualized word representations》&#xff0c;它的官网有开源的工具&#xff1a;https://allennlp.org/elmo

word2vec和glove存在一个问题&#xff0c;词在不同的语境下其实有不同的含义&#xff0c;而这两个模型词在不同语境下的向量表示是相同的&#xff0c;Elmo就是针对这一点进行了优化

BERT

BERT的工作方式跟ELMo是类似的&#xff0c;但是ELMo存在一个问题&#xff0c;它的语言模型使用的是LSTM&#xff0c;而不是google在2017最新推出的Transformer&#xff08;来自论文《Attention is all you need》&#xff09;

-

理解GloVe模型&#xff08;&#43;总结&#xff09;

参考链接&#xff1a;https://blog.csdn.net/u014665013/article/details/79642083

关注点&#xff1a;

介绍了举了窗口宽度为5的例子&#xff0c;来讲明共现矩阵。同时对于公式进行了比较详细的梳理

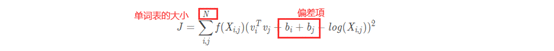

使用GloVe模型训练词向量

模型公式

关注点&#xff1a;

这本书还是比较推荐读的&#xff0c;提及到了Glove提出的思路-基于全局的矩阵分解的方法或基于局部上下文窗口的方法

学习词向量的方法分为两类&#xff1a;基于全局的矩阵分解的方法或基于局部上下文窗口的方法。LSA-全局分解-有效地利用了全局统计信息&#xff0c;但在单词类比任务中表现不佳。

Skip-gram、CBOW-基于局部上下文窗口的方法&#xff0c;单词类比佳&#xff0c;但没用全局信息所以有改进的空间

Glove有效利用了全局语料库统计数据&#xff0c;同时以类似于skip-gram或CBOW这种基于上下文上窗口的方式来优化学习模型

代码实现&#xff1a;

https://github.com/PacktPublishing/Natural-Language-Processing-with-TensorFlow/blob/master/ch4/ch4_glove.ipynb”

2 Attention:

论文出处&#xff1a;<>

-

np中的Attention注意力机制&#43;Transformer详解

参考链接&#xff1a;https://www.zhihu.com/question/68482809

关注点&#xff1a;

self-attention

自注意力机制为什么如此强大; 利用注意力机制来“动态”地生成不同连接的权重&#xff0c;从而处理变长的信息序列。

需要讲解一下&#xff0c;Attention的计算的流程

- 完全图解RNN、RNN变体、Seq2Seq、Attention机制

参考链接&#xff1a;https://www.leiphone.com/news/201709/8tDpwklrKubaecTa.html

关注点&#xff1a;

这里补充了RNN、Seq2Seq、Attention基础

Notes:

目录就先不补上&#xff0c;这周会继续对Attention这部分进行补充。讲解一下Attention的变体、公式推导、计算过程、Self-Attention的使用

喜欢的客观点个赞呗~