ELK 是 ElasticSearch、 LogStash、 Kibana 三个开源工具的简称,现在还包括 Beats,其分工如下:

- LogStash/Beats: 负责数据的收集与处理

- ElasticSearch: 一个开源的分布式搜索引擎,负责数据的存储、检索和分析

- Kibana: 提供了可视化的界面。负责数据的可视化操作

基于 ELK Stack 可以构建日志分析平台、数据分析搜索平台等非常有用的项目。

作为学习笔记的第一篇,简单介绍下 ELK 各个软件的安装与简单配置,快速的搭建一个日志的查询平台

一. ElasticSearch 的安装与运行

ES 是一个基于 Lucene 的使用 Java 开发的开源搜索引擎,因此其运行是基于 JVM 的,因此在安装之前需要保证已经安装了 Java 环境。ES 要求使用 Java8 或者更高版本的 Java 环境。

确定机器已经安装了 Java 环境后,就可以安装 ES 了。官网提供了压缩包可以直接下载,

# 下载压缩包

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-6.2.2.tar.gz

# 解压

tar -xzf elasticsearch-6.2.2.tar.gz

# 进入文件

cd elasticsearch-6.2.2/

下载解压完成后进入目录,启动命令在 bin 目录下,直接运行命令就可以启动了

bin/elasticsearch

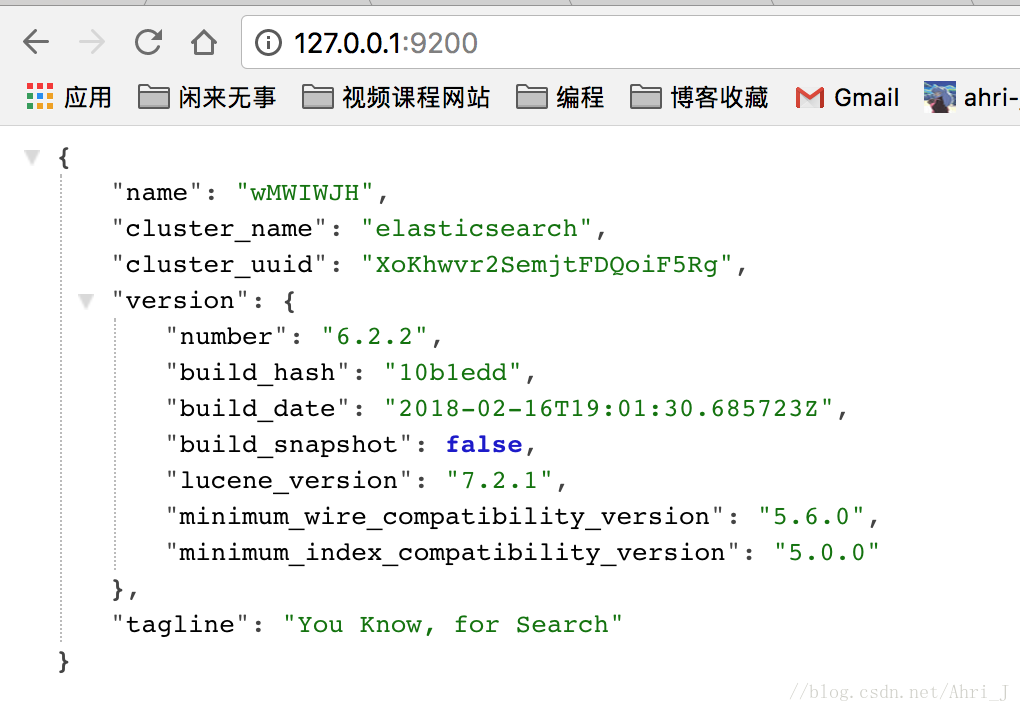

ElasticSearch 的默认启动端口是 9200。手动访问出现如下信息说明启动成功。

二. FileBeats 与 LogStash 的安装

LogStash 可以用来对日志进行收集并进行过滤整理后输出到 ES 中,FileBeats 是一个更加轻量级的日志收集工具。

现在最常用的方式是通过 FileBeats 收集目标日志,然后统一输出到 LogStash 做进一步的过滤,在由 LogStash 输出到 ES 中进行存储。

1. LogStash 的安装运行

官方提供了压缩包下载, https://www.elastic.co/downloads/logstash 。 下载完成后解压即可。

tar zxvf logstash-6.2.2.tar.gz

# 进入目录

cd logstash-6.2.2

LogStash 的运行需要指定一个配置文件,来指定数据的流向,我们在当前目录下创建一个 first.conf 文件,其内容如下:

input {beats {port => "5044"}}

filter {grok {match => { "message" => "%{COMBINEDAPACHELOG}" }}geoip {source => "clientip"}}

output {elasticsearch {hosts => [ "localhost:9200" ]}}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

上面配置了 LogStash 输出日志到 ES 中,具体字段在后面的笔记中会详细介绍,这里先用起来再说。

配置完成后就可以通过如下方式启动 LogStash 了

bin/logstash -f first.conf --config.reload.automatic

可以看到命令行会打印出如下信息, 可以看到 LogStash 默认端口为 5044:

[2018-03-08T23:12:44,087][WARN ][logstash.config.source.multilocal] Ignoring the 'pipelines.yml' file because modules or command line options are specified

[2018-03-08T23:12:44,925][INFO ][logstash.runner ] Starting Logstash {"logstash.version"=>"6.2.2"}

[2018-03-08T23:12:45,623][INFO ][logstash.agent ] Successfully started Logstash API endpoint {:port=>9600}

[2018-03-08T23:12:49,960][INFO ][logstash.pipeline ] Starting pipeline {:pipeline_id=>"main", "pipeline.workers"=>4, "pipeline.batch.size"=>125, "pipeline.batch.delay"=>50}

[2018-03-08T23:12:50,882][INFO ][logstash.outputs.elasticsearch] Elasticsearch pool URLs updated {:changes=>{:removed=>[], :added=>[http://localhost:9200/]}}

[2018-03-08T23:12:50,894][INFO ][logstash.outputs.elasticsearch] Running health check to see if an Elasticsearch connection is working {:healthcheck_url=>http://localhost:9200/, :path=>"/"}

[2018-03-08T23:12:51,303][WARN ][logstash.outputs.elasticsearch] Restored connection to ES instance {:url=>"http://localhost:9200/"}

[2018-03-08T23:12:51,595][INFO ][logstash.outputs.elasticsearch] ES Output version determined {:es_version=>nil}

[2018-03-08T23:12:51,604][WARN ][logstash.outputs.elasticsearch] Detected a 6.x and above cluster: the `type` event field won't be used to determine the document _type {:es_version=>6}

[2018-03-08T23:12:51,641][INFO ][logstash.outputs.elasticsearch] Using mapping template from {:path=>nil}

[2018-03-08T23:12:51,676][INFO ][logstash.outputs.elasticsearch] Attempting to install template {:manage_template=>{"template"=>"logstash-*", "version"=>60001, "settings"=>{"index.refresh_interval"=>"5s"}, "mappings"=>{"_default_"=>{"dynamic_templates"=>[{"message_field"=>{"path_match"=>"message", "match_mapping_type"=>"string", "mapping"=>{"type"=>"text", "norms"=>false}}}, {"string_fields"=>{"match"=>"*", "match_mapping_type"=>"string", "mapping"=>{"type"=>"text", "norms"=>false, "fields"=>{"keyword"=>{"type"=>"keyword", "ignore_above"=>256}}}}}], "properties"=>{"@timestamp"=>{"type"=>"date"}, "@version"=>{"type"=>"keyword"}, "geoip"=>{"dynamic"=>true, "properties"=>{"ip"=>{"type"=>"ip"}, "location"=>{"type"=>"geo_point"}, "latitude"=>{"type"=>"half_float"}, "longitude"=>{"type"=>"half_float"}}}}}}}}

[2018-03-08T23:12:51,773][INFO ][logstash.outputs.elasticsearch] New Elasticsearch output {:class=>"LogStash::Outputs::ElasticSearch", :hosts=>["//localhost:9200"]}

[2018-03-08T23:12:52,176][INFO ][logstash.filters.geoip ] Using geoip database {:path=>"/Users/zouyingjie/soft/study/ELK/logstash-6.2.2/vendor/bundle/jruby/2.3.0/gems/logstash-filter-geoip-5.0.3-java/vendor/GeoLite2-City.mmdb"}

[2018-03-08T23:12:53,026][INFO ][logstash.inputs.beats ] Beats inputs: Starting input listener {:address=>"0.0.0.0:5044"}

[2018-03-08T23:12:53,195][INFO ][logstash.pipeline ] Pipeline started succesfully {:pipeline_id&#61;>"main", :thread&#61;>"#<Thread:0x66461e40 run>"}

[2018-03-08T23:12:53,290][INFO ][org.logstash.beats.Server] Starting server on port: 5044

[2018-03-08T23:12:53,401][INFO ][logstash.agent ] Pipelines running {:count&#61;>1, :pipelines&#61;>["main"]}

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

2. 安装运行 FileBeats

FileBeats 也提供了下载包&#xff0c;地址为 https://www.elastic.co/downloads/beats/filebeat 。找到系统对应的包下载后解压即可。

tar zxvf filebeat-6.2.2-darwin-x86_64.tar.gz

cd filebeat-6.2.2-darwin-x86_64

进入目录编辑 filebeat.yml 找到对应的配置项&#xff0c;配置如下

- type: logenabled: Truepaths:- /usr/local/nginx/logs/*.log

output.logstash:hosts: ["localhost:5044"]

配置完成后执行如下命令&#xff0c;启动 FileBeat 即可

sudo chown root filebeat.yml

sudo ./filebeat -e -c filebeat.yml -d "publish"

三. Kibana 的安装运行

Kibana 也提供了对应的安装包下载&#xff0c;链接为 https://www.elastic.co/downloads/kibana , Mac、Linux、Win 都有对应的安装包&#xff0c;直接下载解压即可

tar zxvf kibana-6.2.2-darwin-x86_64.tar.gz

cd kibana-6.2.2-darwin-x86_64

# 直接启动即可

bin/kibana

Kibana 默认链接了本机的 9200 端口&#xff0c;其绑定的端口为 5601&#xff0c;启动成功后直接访问 127.0.0.1:5601 端口即可,界面如下。我因为安装了 x-pack 插件因此显示的项可能会多一些&#xff0c;这个暂时忽略.

点击右上方的 Discover. 界面会提示创建索引模式&#xff0c;通过这个来检索 ES 中的索引&#xff0c;可以看到已经有一个 Logstash 的索引了&#xff0c;输入名称进行完全匹配&#xff0c;

这里选定一个时间戳&#xff0c;使用默认的 timestamp 即可&#xff0c;设置完成后我们可以根据时间范围筛选数据。

设置完成后创建后显示如下

这时在点击 Discover 就可以看到我们创建的索引了&#xff0c;此时输入 UnicodeEncodeError 已经返回了匹配到的日志信息。

至此就完成了简单的日志分析平台的搭建。OK&#xff0c;关于安装就介绍到这里&#xff0c;后面正式开始对整个 ELK Stack 的学习。

转载自&#xff1a;https://blog.csdn.net/Ahri_J/article/details/79609444