作者:可爱de小蜗牛 | 来源:互联网 | 2023-08-25 15:24

首先在阿里云购买一个服务器Linux centos使用Xshell连接(通过ip地址账号密码)

通过Xftp 把下载好的jdk、hadoop压缩包放到远程服务器上 文件目录/software

执行解压命令分别解压jdk和hadoop压缩包

jdk:tar -zxvf jdk-8u162-linux-x64.tar.gz -C /usr/local/java/

hadoop:tar -zxvf hadoop-2.7.1.tar.gz -C /usr/local/hadoop/

查看jdk 和 hadoop版本

jdk:java -version 命令

hadoop:到hadoop目录下执行./bin/hadoop version

配置环境变量 通过vim编辑/etc/profile

export JAVA_HOME=/usr/local/java/jdk1.8.0_162 export JRE_HOME=JAVAHOME/jreexportCLASSPATH=.:{JAVA_HOME}/lib:JREHOME/libexportPATH=.:{JAVA_HOME}/bin:HADOOPHOME/bin:{HADOOP_HOME}/sbin:PATHexportHADOOPHOME=/usr/local/hadoop/hadoop−2.7.1exportPATH=PATH:HADOOPHOME/binexportPATH=PATH:$HADOOP_HOME/sbin

(Markdown原因…)

cd /usr/local/hadoop/hadoop-2.7.1/

mkdir ./input

cp ./etc/hadoop/*.xml ./input

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar grep input output ‘dfs[a-z.]+’ cat ./output/*

伪分布式环境配置

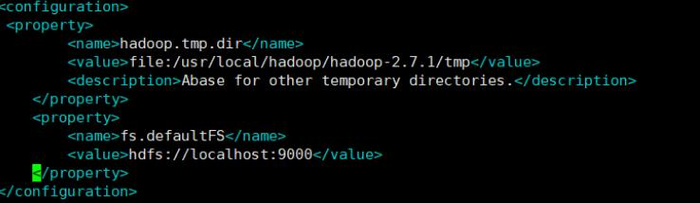

core-site.xml :

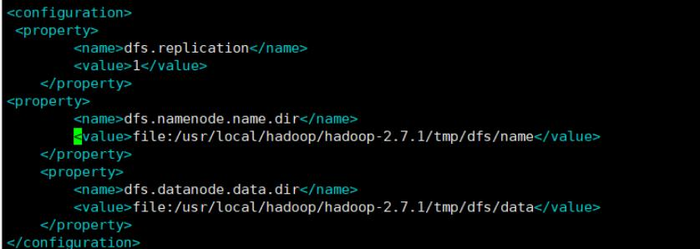

hdfs-site.xml:

格式化:./bin/hdfs namenode -format

接着开启 NaneNode 和 DataNode 守护进程:

./sbin/start-dfs.sh

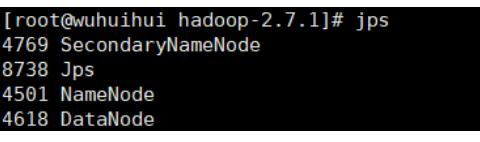

jps查看是否成功