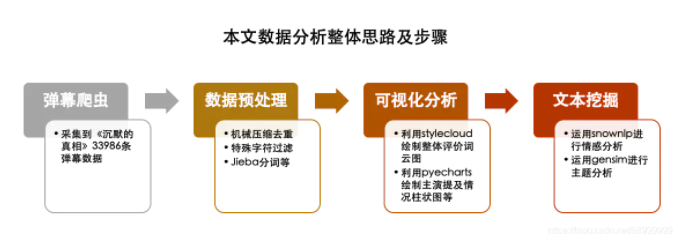

运用文本挖掘技术,对最近热播剧《沉默的真相》弹幕数据进行深入分析

B站数据爬虫代码Demo

## 作者:丹成学长 Q746876041

import requests,csv,time

import sys

from bs4 import BeautifulSoup as BSfirst_barrage_url = "视频地址"'''获取网页内容'''

def request_get_comment(url):headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko)','COOKIE': 'LIVE_BUVID=AUTO7215383727315695; stardustvideo=1; rpdid=kwxwwoiokwdoskqkmlspw; ''fts=1540348439; sid=alz55zmj; CURRENT_FNVAL=16; _uuid=08E6859E-EB68-A6B3-5394-65272461BC6E49706infoc; ''im_notify_type_64915445=0; UM_distinctid=1673553ca94c37-0491294d1a7e36-36664c08-144000-1673553ca956ac; ''DedeUserID=64915445; DedeUserID__ckMd5=cc0f686b911c9f2d; SESSDATA=7af19f78%2C1545711896%2Cb812f4b1; ''bili_jct=dc9a675a0d53e8761351d4fb763922d5; BANGUMI_SS_5852_REC=103088; ''buvid3=AE1D37C0-553C-445A-9979-70927B6C493785514infoc; finger=edc6ecda; CURRENT_QUALITY=80; ''bp_t_offset_64915445=199482032395569793; _dfcaptcha=44f6fd1eadc58f99515d2981faadba86'}response = requests.get(url=url,headers=headers)soup = BS(response.text.encode(response.encoding).decode('utf8'),'lxml')result = soup.find_all('d')if len(result) == 0:return resultall_list = []for item in result:barrage_list = item.get('p').split(",")barrage_list.append(item.string)barrage_list[4] = time.ctime(eval(barrage_list[4]))all_list.append(barrage_list)return all_list'''将秒转化为固定格式:"时:分:秒"'''

def sec_to_str(second):second = eval(second)m,s = divmod(second,60)h,m = divmod(m,60)dtEventTime = "%02d:%02d:%02d" % (h,m,s)return dtEventTime'''主函数'''

def main():sys.setrecursionlimit(1000000)url_list = []cid_list = [16980576,16980597,16548432,16483358,16740879,17031320,17599975,18226264,17894824,18231028,18491877,18780374]tableheader = ['弹幕出现时间', '弹幕格式', '弹幕字体', '弹幕颜色', '弹幕时间戳','弹幕池','用户ID','rowID','弹幕信息']'''最新弹幕文件'''for i in range(12):url = "https://comment.bilibili.com/%d.xml" % cid_list[i]url_list.append(url)file_name = "now{}.csv".format(i + 1)with open(file_name,'w',newline='',errors='ignore') as fd:comment = request_get_comment(url)writer = csv.writer(fd)# writer.writerow(tableheader)if comment:for row in comment:print(row)#writer.writerow(row)del comment'''按照集数,取出弹幕链接,进行爬虫,获取弹幕记录,并保存到csv文件'''for i in range(12):file_name = "d{}.csv".format(i+1)for j in range(1,13):for date in range(2):barrage_url = first_barrage_url.format(cid_list[i],"%02d" % j,"%02d" % (1 + date * 14))with open(file_name,'a',newline='',errors='ignore') as fd :writer = csv.writer(fd)writer.writerow(tableheader)final_list = request_get_comment(barrage_url)if final_list:for row in final_list:writer.writerow(row)del (final_list)if __name__ == "__main__":main()

#数据处理库import numpy as npimport pandas as pdimport globimport reimport jieba#可视化库import stylecloudimport matplotlib.pyplot as pltimport seaborn as sns%matplotlib inlinefrom pyecharts.charts import *from pyecharts import options as optsfrom pyecharts.globals import ThemeType from IPython.display import Image#文本挖掘库from snownlp import SnowNLPfrom gensim import corpora,models

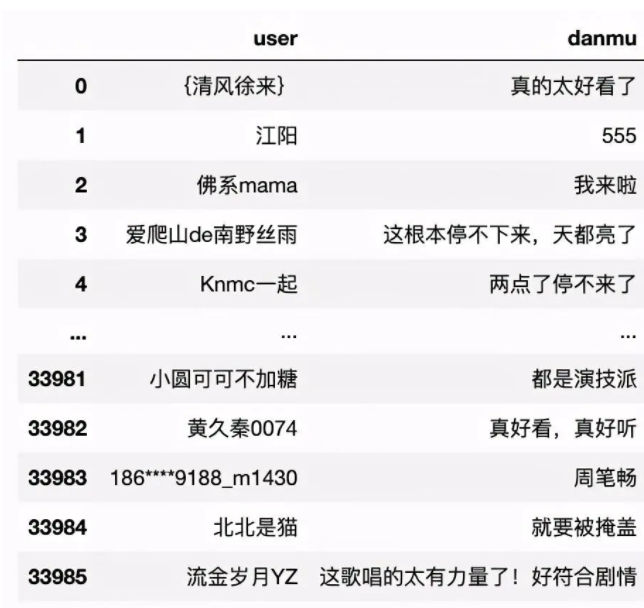

《沉默的真相》共12集,分集爬取,共生成12个csv格式的弹幕数据文件,保存在danmu文件夹中。通过glob方法遍历所有文件,读取数据并追加保存到danmu_all文件中。

csv_list = glob.glob('/danmu/*.csv')print('共发现%s个CSV文件'% len(csv_list))print('正在处理............')for i in csv_list:fr = open(i,'r').read()with open('danmu_all.csv','a') as f:f.write(fr)print('合并完毕!')

#error_bad_lines参数可忽略异常行df = pd.read_csv("./danmu_all.csv",header=None,error_bad_lines=False)df = df.iloc[:,[1,2]] #选择用户名和弹幕内容列df = df.drop_duplicates() #删除重复行df = df.dropna() #删除存在缺失值的行df.columns = ["user","danmu"] #对字段进行命名

清洗后数据如下所示:

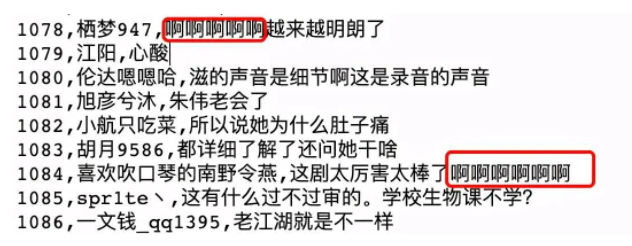

机械压缩去重即数据句内的去重,我们发现弹幕内容存在例如"啊啊啊啊啊"这种数据,而实际做情感分析时,只需要一个“啊”即可。

#定义机械压缩去重函数def yasuo(st):for i in range(1,int(len(st)/2)&#43;1):for j in range(len(st)):if st[j:j&#43;i] &#61;&#61; st[j&#43;i:j&#43;2*i]:k &#61; j &#43; iwhile st[k:k&#43;i] &#61;&#61; st[k&#43;i:k&#43;2*i] and k<len(st): k &#61; k &#43; ist &#61; st[:j] &#43; st[k:] return styasuo(st&#61;"啊啊啊啊啊啊啊")

应用以上函数&#xff0c;对弹幕内容进行句内去重。

df["danmu"] &#61; df["danmu"].apply(yasuo)

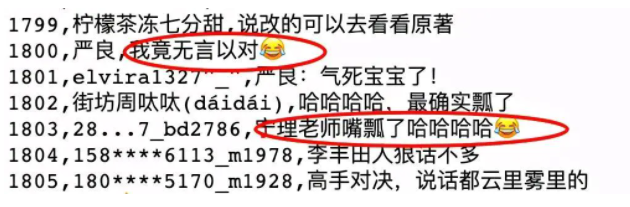

另外&#xff0c;我们还发现有些弹幕内容包含表情包、特殊符号等&#xff0c;这些脏数据也会对情感分析产生一定影响。

特殊字符直接通过正则表达式过滤&#xff0c;匹配出中文内容即可。

df[&#39;danmu&#39;] &#61; df[&#39;danmu&#39;].str.extract(r"([\u4e00-\u9fa5]&#43;)")df &#61; df.dropna() #纯表情直接删除

另外&#xff0c;过短的弹幕内容一般很难看出情感倾向&#xff0c;可以将其一并过滤。

df &#61; df[df["danmu"].apply(len)>&#61;4]df &#61; df.dropna()

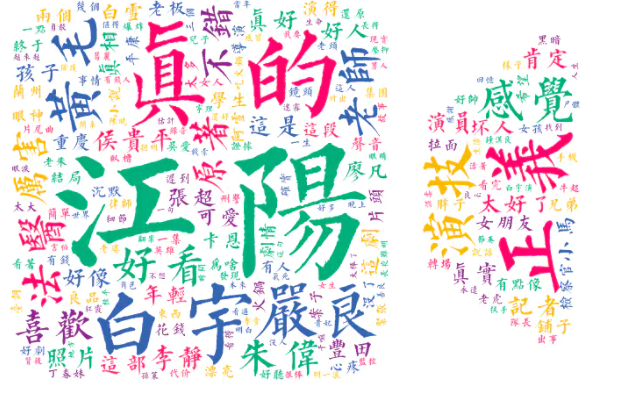

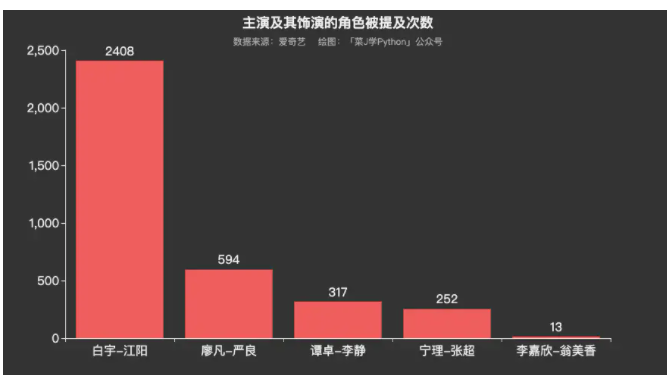

数据可视化分析部分代码本公众号往期原创文章已多次提及&#xff0c;本文不做赘述。从可视化图表来看&#xff0c;网友对《沉默的真相》还是相当认可的&#xff0c;尤其对白宇塑造的正义形象江阳&#xff0c;提及频率远高于其他角色。

情感分析是对带有感情色彩的主观性文本进行分析、处理、归纳和推理的过程。按照处理文本的类别不同&#xff0c;可分为基于新闻评论的情感分析和基于产品评论的情感分析。其中&#xff0c;前者多用于舆情监控和信息预测&#xff0c;后者可帮助用户了解某一产品在大众心目中的口碑。目前常见的情感极性分析方法主要是两种&#xff1a;基于情感词典的方法和基于机器学习的方法。

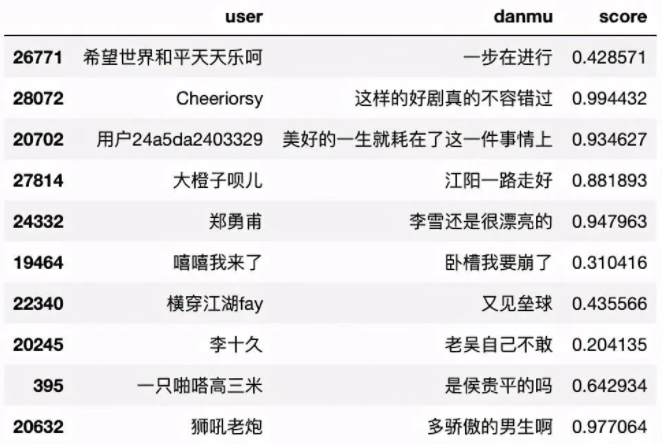

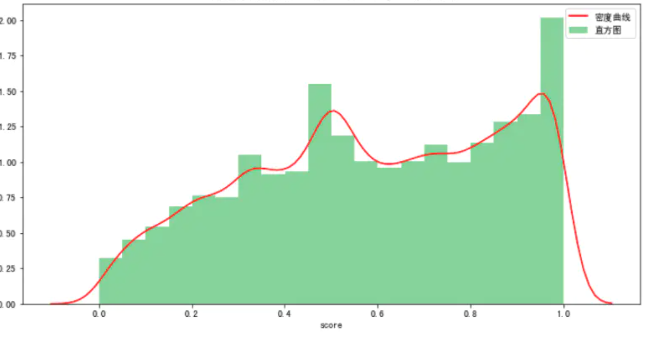

本文主要运用Python的第三方库SnowNLP对弹幕内容进行情感分析&#xff0c;使用方法很简单&#xff0c;计算出的情感score表示语义积极的概率&#xff0c;越接近0情感表现越消极&#xff0c;越接近1情感表现越积极。

df[&#39;score&#39;] &#61; df["danmu"].apply(lambda x:SnowNLP(x).sentiments)df.sample(10) #随机筛选10个弹幕样本数据

plt.rcParams[&#39;font.sans-serif&#39;] &#61; [&#39;SimHei&#39;] # 设置加载的字体名plt.rcParams[&#39;axes.unicode_minus&#39;] &#61; False # 解决保存图像是负号&#39;-&#39;显示为方块的问题plt.figure(figsize&#61;(12, 6)) #设置画布大小rate &#61; df[&#39;score&#39;]ax &#61; sns.distplot(rate,hist_kws&#61;{&#39;color&#39;:&#39;green&#39;,&#39;label&#39;:&#39;直方图&#39;},kde_kws&#61;{&#39;color&#39;:&#39;red&#39;,&#39;label&#39;:&#39;密度曲线&#39;},bins&#61;20) #参数color样式为salmon&#xff0c;bins参数设定数据片段的数量ax.set_title("弹幕整体情感倾向 绘图&#xff1a;「菜J学Python」公众号")plt.show

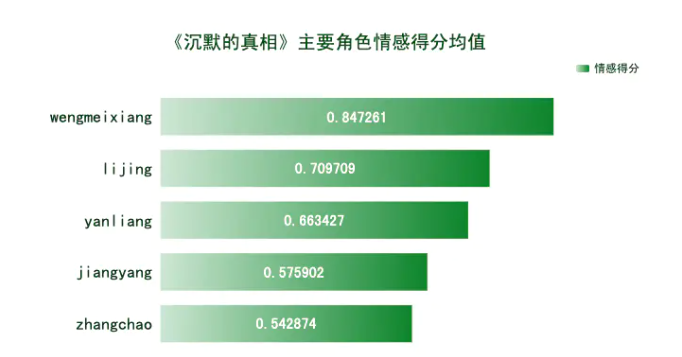

mapping &#61; {&#39;jiangyang&#39;:&#39;白宇|江阳&#39;, &#39;yanliang&#39;:&#39;廖凡|严良&#39;, &#39;zhangchao&#39;:&#39;宁理|张超&#39;,&#39;lijing&#39;:&#39;谭卓|李静&#39;, &#39;wengmeixiang&#39;:&#39;李嘉欣|翁美香&#39;}for key, value in mapping.items():df[key] &#61; df[&#39;danmu&#39;].str.contains(value)average_value &#61; pd.Series({key: df.loc[df[key], &#39;score&#39;].mean() for key in mapping.keys()})print(average_value.sort_values())

由各主要角色情感得分均值可知&#xff0c;观众对他们都表现出积极的情感。翁美香和李静的情感得分均值相对高一些&#xff0c;难道是男性观众偏多&#xff1f;江阳的情感倾向相对较低&#xff0c;可能是观众对作为正义化身的他惨遭各种不公而鸣不平吧。

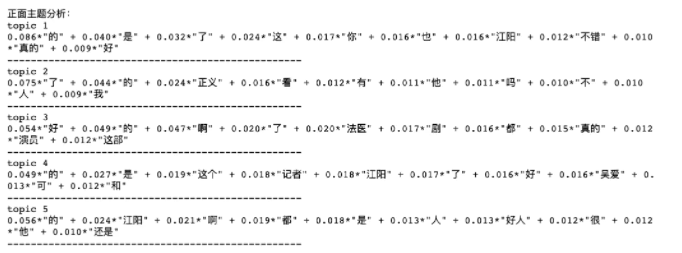

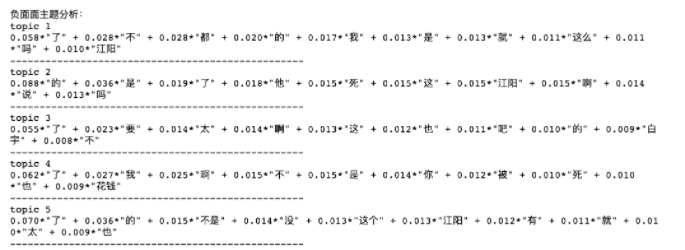

这里的主题分析主要是将弹幕情感得分划分为两类&#xff0c;分别为积极类&#xff08;得分在0.8以上&#xff09;和消极类&#xff08;得分在0.3以下&#xff09;&#xff0c;然后再在各类里分别细分出5个主题&#xff0c;有助于挖掘出观众情感产生的原因。

首先&#xff0c;筛选出两大类分别进行分词。

#分词data1 &#61; df[&#39;danmu&#39;][df["score"]>&#61;0.8]data2 &#61; df[&#39;danmu&#39;][df["score"]<0.3]word_cut &#61; lambda x:&#39; &#39;.join(jieba.cut(x)) #以空格隔开data1 &#61; data1.apply(word_cut)data2 &#61; data2.apply(word_cut)print(data1)print(&#39;----------------------&#39;)print(data2)123456789首先&#xff0c;筛选出两大类分别进行分词。#去除停用词stop &#61; pd.read_csv("/菜J学Python/stop_words.txt",encoding&#61;&#39;utf-8&#39;,header&#61;None,sep&#61;&#39;tipdm&#39;)stop &#61; [&#39; &#39;,&#39;&#39;] &#43; list(stop[0])#print(stop)pos &#61; pd.DataFrame(data1)neg &#61; pd.DataFrame(data2)pos["danmu_1"] &#61; pos["danmu"].apply(lambda s:s.split(&#39; &#39;))pos["danmu_pos"] &#61; pos["danmu_1"].apply(lambda x:[i for i in x if i.encode(&#39;utf-8&#39;) not in stop])#print(pos["danmu_pos"])neg["danmu_1"] &#61; neg["danmu"].apply(lambda s:s.split(&#39; &#39;))neg["danmu_neg"] &#61; neg["danmu_1"].apply(lambda x:[i for i in x if i.encode(&#39;utf-8&#39;) not in stop])

其次&#xff0c;对积极类弹幕进行主题分析。

#正面主题分析pos_dict &#61; corpora.Dictionary(pos["danmu_pos"]) #建立词典#print(pos_dict)pos_corpus &#61; [pos_dict.doc2bow(i) for i in pos["danmu_pos"]] #建立语料库pos_lda &#61; models.LdaModel(pos_corpus,num_topics&#61;5,id2word&#61;pos_dict) #LDA模型训练print("正面主题分析&#xff1a;")for i in range(5):print(&#39;topic&#39;,i&#43;1)print(pos_lda.print_topic(i)) #输出每个主题print(&#39;-&#39;*50)

结果如下&#xff1a;

最后&#xff0c;对消极类弹幕进行主题分析。

#负面主题分析neg_dict &#61; corpora.Dictionary(neg["danmu_neg"]) #建立词典#print(neg_dict)neg_corpus &#61; [neg_dict.doc2bow(i) for i in neg["danmu_neg"]] #建立语料库neg_lda &#61; models.LdaModel(neg_corpus,num_topics&#61;5,id2word&#61;neg_dict) #LDA模型训练print("负面面主题分析&#xff1a;")for j in range(5):print(&#39;topic&#39;,j&#43;1)print(neg_lda.print_topic(j)) #输出每个主题print(&#39;-&#39;*50)

结果如下&#xff1a;

毕设帮助&#xff0c;开题指导&#xff0c;技术解答

&#x1f1f6;746876041

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有