智源导读:当下人工智能对各领域产生了重要影响,数学也不例外。

近期,在智源研究院成立两周年之际举办的“智源论坛2020”中,北京大学教授、智源学者林伟提出这样一个问题:人工智能到底能不能够激发新数学的发展?对这一问题,他给出“人工智能的十种新数学”的回答。

随后并邀请智源研究院不同研究领域的六位科学家,对如何将 AI 理论与 AI 应用相结合的问题进行激烈且深度的探讨。

整个研讨分为两部分,首先由北京大学教授林伟做引导报告《人工智能新数学》,随后七位学者围绕多个问题进行辩论。

从左到右:林伟、余山、邓柯、董彬、明平兵、邵嗣烘、林宙辰

从左到右:林伟、余山、邓柯、董彬、明平兵、邵嗣烘、林宙辰

整理:智源社区 贾伟

人工智能的十种新数学

以下是林伟教授的报告内容整理:

林伟:我常常被问到,人工智能到底能不能够激发新数学的发展,这种新数学在做基础数学的人看来不一定是新的,但可能跟一些我们意想不到、不那么常用在智能领域的数学分支发生联系?

我对这个问题做了些思考,大概收集十个方向。

首先,有四个部分知识大概是我们在人工智能领域里用得比较多的:

一个是概率论、数理统计;

一个是数值代数、数值分析、最优化;

一个是经典分析、函数论,比如深度学习里很重要的一块是知道逼近论的知识;

还有计算机科学基础,包括离散数学、理论计算机科学。

我在这里把它们归为“旧”数学,但这个“旧”不是说它不重要;对学生来说,仍然是最应该掌握、最核心的工具。

那么相对于“旧数学”,我总结了人工智能的十种“新数学”。

01

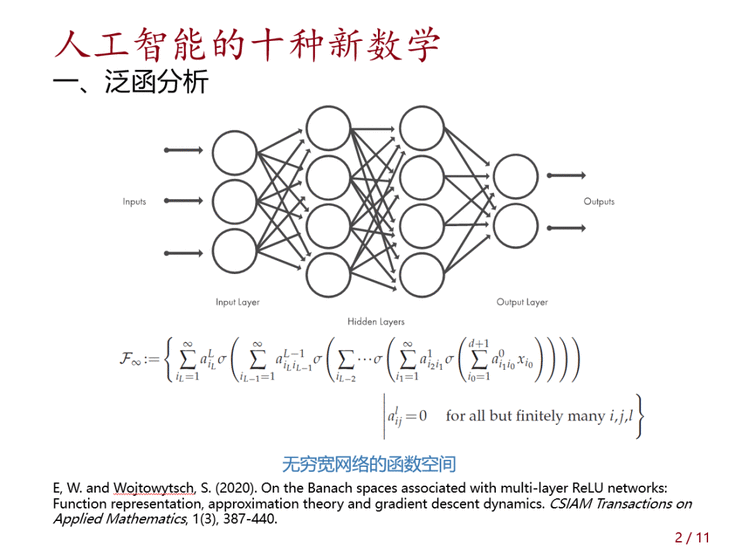

泛函分析

我们的深度神经网络,是有限的神经元;但如果我们要研究它的逼近能力,就不能假设真实的数据是来自于这样一个有限的模型,因为真实世界是非常复杂的。

所以我们往往需要去定义一个适当的函数类。真实数据应该来自于哪个函数类?

这篇文章定义了一个宽度为无穷宽的极限,这构成了一个数学上讲的“巴拉克空间”,我在这上面再来发展一些数学理论。

02

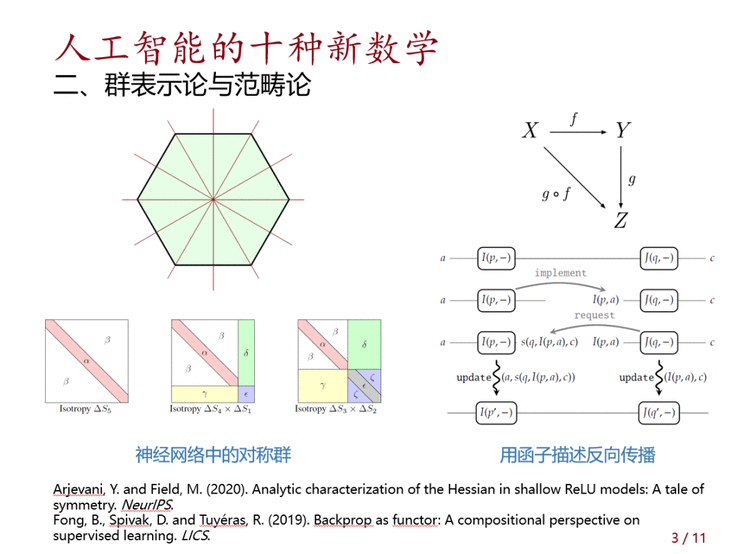

群表示论与范畴论

这个大家可能非常陌生,但是为什么放在这里呢?实际上这两个分支不太一样,但是它们都是现代的代数学的一些方向。

为什么人工智能里面需要“群表示论”?所谓的“群”,它可以表示对称性,现在神经网络里面参数非常多,甚至多达1000多万个,这里面有很多冗余性,我们通过对称性可以定义一些对称群,在某些变换下,很多神经网络本质上是等价的,我们可以通过这种群表示论,用双线性变换或者矩阵来表示“群”的方法来研究神经网络中的对称性。

范畴论更加抽象一点。这里是个例子,它是用范畴论里的函子来描述反向传播算法。范畴论很简单,也很抽象,它为什么可以很自然用在神经网络里?主要因为它很适合用来研究函数的复合。深度神经网络的特征是一层一层复合上去的结构,所以这也是一个比较抽象,但有一定潜力的理论。

03

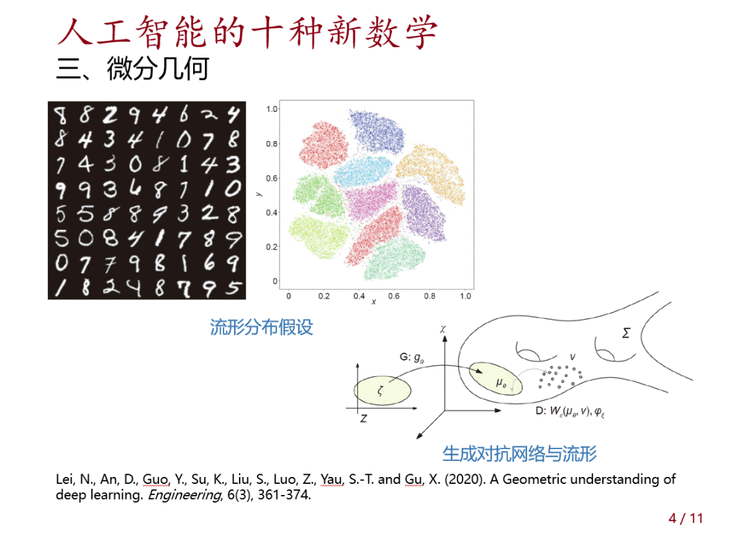

微分几何

这个大家相对来说比较熟悉一些,这是基于大家都比较熟悉的一个假设——“流形分布假设”,比如手写识别的数据,大多数情况下我们相信它分布在流形上面,我们可以利用微分几何流形上的数学来研究它从输入到输出之间的关系。比如上面这篇文章考虑了对称生成对抗网络与流形的一些关系。

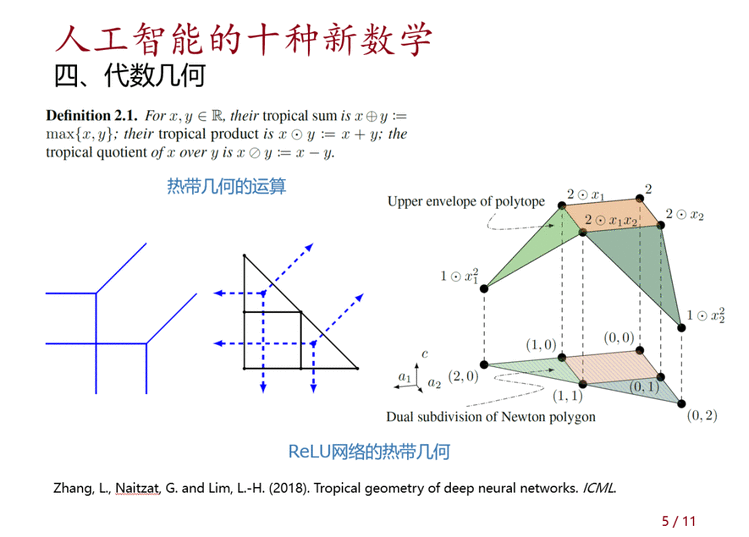

04

代数几何

这是基础数学非常核心的分支,但是很少听说代数几何在人工智能里面还有用处,我也是查了文献才知道。这是“热带几何”,是代数几何的一种变体。为什么神经网络里可以用到这个代数几何?因为ReLU函数是{X,0}取大,通过这个取大操作以及加法、减法,定义了一些热带几何上的预算,通过这几种预算,我们就可以定义一种多项式。我们知道代数几何是研究多项式的几何,所以我们神经网络就可以用这种形式的代数几何来描述。

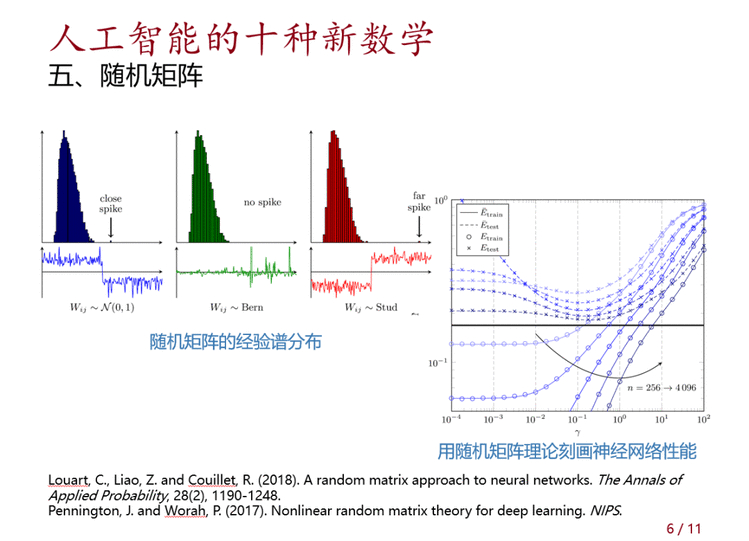

05

随机矩阵

接下来逐渐从抽象向应用走。随机矩阵是大家用得比较多的一个工具。神经网络里面,一个大型的神经网络,在某种情况下它的权值比较接近随机分布,我们可以用随机矩阵理论来刻画它的谱的性质。我们知道对于某些分布,系数不同时会有不同的谱分布。大型神经网络里是否也有这样规律现象?我们可以用随机矩阵理论刻画神经网络的预测和学习性能。

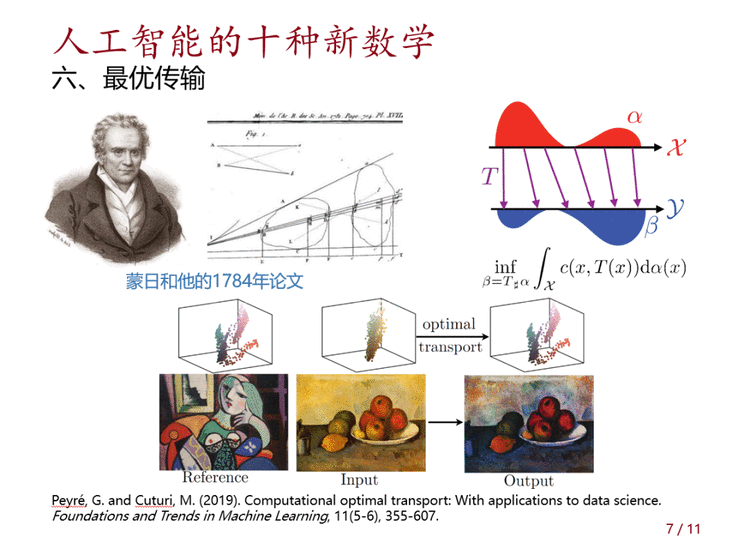

06

最优传输

最优传输,近两年也非常火,主要因为它特别适合用来描述对抗生成网络(GAN)里面的问题。最优传输,有非常悠久的历史,现在仍然是数学里面非常核心的一个方向。简单来说,最优传输的问题便是,有两个概率分布,怎样从一个概率分布迁移到另外一个概率分布?所以它也叫“推土机”,类似推土机一样把分布以最小的代价变成另外一个概率分布;目标是要解一个问题,每一点移动有一个代价,要使得这个移动总代价是最低的。这个形式非常广泛,它在经济学、运筹学里面有很多用处,在图像处理里面,特别是GAN里面有很多应用。

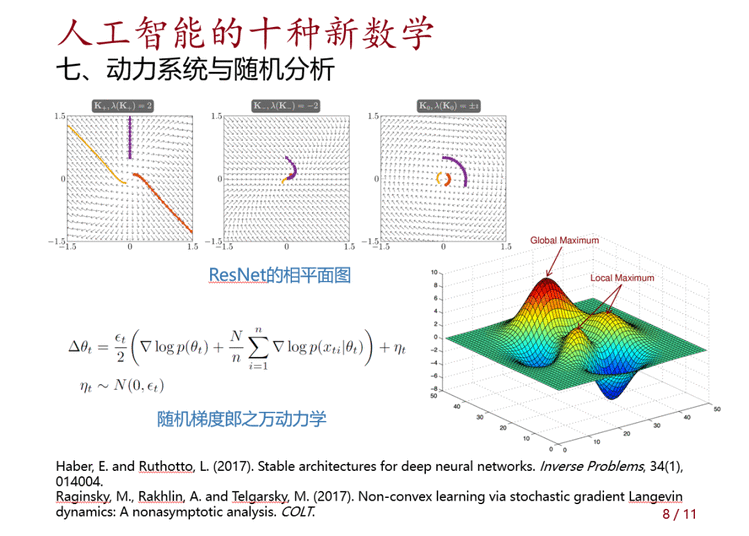

07

动力系统与随机分析

动力系统主要是指稳定性的内容,比如上面这篇文章是用相平面图来研究ResNet里面动力学的稳定性。

还有随机动力系统。随机动力系统比较常用的一个问题是随机梯度下降,随机梯度下降本身是比较难研究的,也是现在深度学习理论研究里面的一个瓶颈之一。但是我如果把它加一个人为的噪声,比如这个η,变成带了噪声以后的迭代,叫“随机梯度郎之万动力学”,这样可以有些比较好的理论分析,特别是它在解一些问题时可以有一些很好的结果。

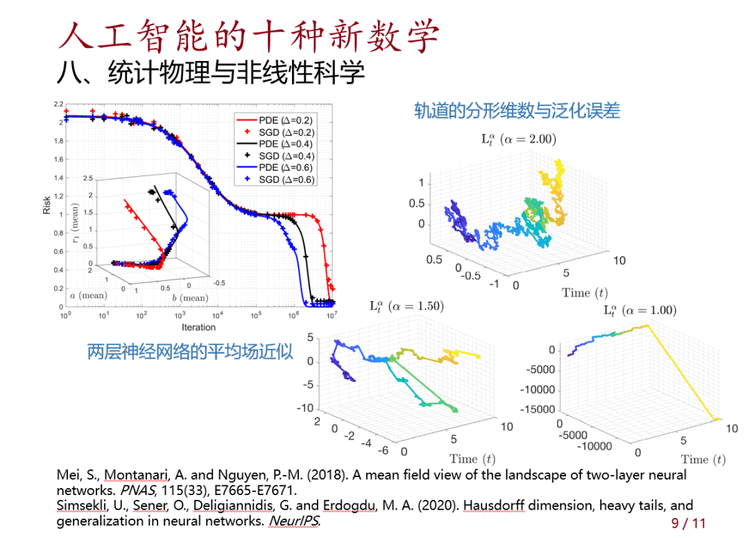

08

统计物理与非线性科学

这是一个比较大的领域,这里举两个例子。最近有这样一个工作,两层神经网络可以做一个平均场近似,平均场方法几乎是物理学家的法宝,任何情况下都可以做一个平均场近似,大部分情况下都 work 得比较好。对于两层无穷宽的神经网络,我们可以平均掉一些效果,这就可以得到一个比较好的跟实际效果吻合的预测。

非线性研究里还有很多研究混沌、分形几何之类的。举例来说,上图第二项工作是用随机梯度下降训练的轨道的分形维数来控制复杂度,由此可以得到一些泛化。

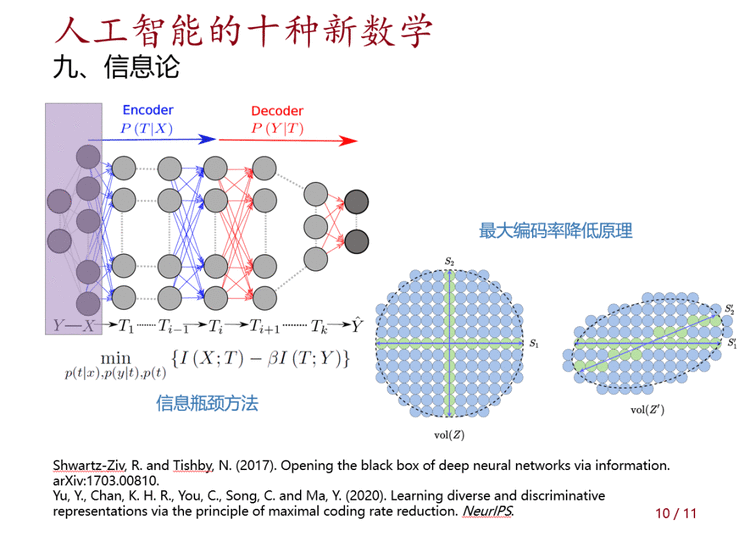

09

信息论

我们用的很多工具来自信息论,但是信息论领域很大,里面有一些内容我们不太经常用,特别是跟编码有关的。这里我举一个“信息瓶颈方法”,这是我们比较少接触的;还有“最大编码率降低原理”,是从信息论或者编码理论里面出来的一些方法。

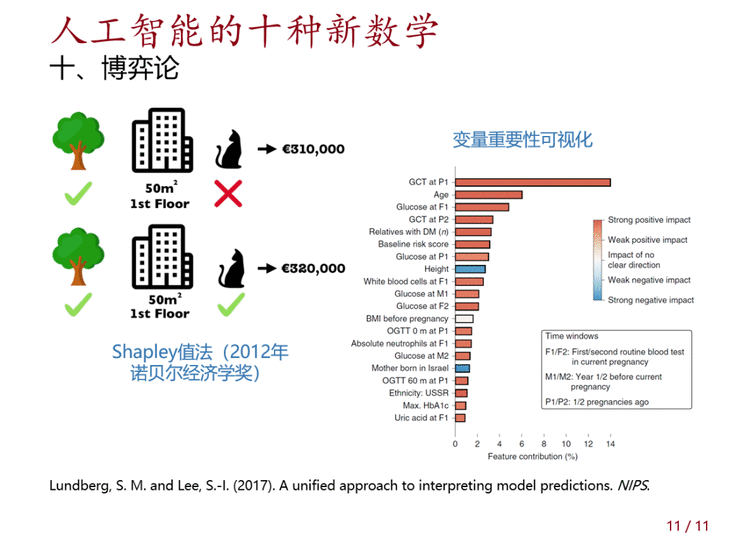

10

博弈论

这个可能还有更多应用,但据我所了解,在可解释性AI里面有一个比较有名的方法叫Shapley值法。Shapley在2012年获得诺贝尔经济学奖,不过他提出这个方法是在1951年。这个想法很简单,对一个黑箱的算法,要去看黑箱里的变量是怎么work的,以及哪些变量重要的。给它做一个可视化,可以假设这些变量之间在进行搏弈,在争夺对Response的某种payoff。在这个搏弈过程中,我们想办法把它们的贡献分配给这些变量。

以上是简单给大家介绍这些我们平时不太会想到的工具。因为我们用惯了概率统计或者数值、或者理论计算机方面的工具,不太想接触更多工具,这里提供一些启发性的数学内容。

【AI理论】如何推动 【AI应用】

人工智能发展到现在,许多人希望能够建立一套完善的人工智能理论基础;只有这样,人工智能才可能成为一门独立的、成熟的学科。

但理论应该关注什么问题?林伟教授认为,这必须从实践中总结凝练。学者们从各自领域,对这一问题做出回答,以下内容根据讨论整理核心观点。

明平兵教授指出虽然数学工具可以帮助建立人工智能的相关理论,但是现有的数理理论都不能完善地解决人工智能的核心问题,目前人们尚未找到人工智能的“正确”的数学表示。要想建立人工智能的理论,首先要准确地阐述出与之相关的、合适的数学问题。

邵嗣烘教授指出现阶段的工作大多数是在用在不同分支的数学语言对人工智能的有关问题进行描述,虽然是一种有益的尝试,但这并非核心目的。

邓柯教授从数据分析的角度,指出在大数据时代人们面临的数据规模巨大,同时噪音等因素带来的不确定性在数据里的呈现的样式也越来越复杂。如何描述这种不确定性并对之进行推断是一个重要的问题。现阶段的模型范式下,比如求解一个经验风险函数的最小化问题,尽管有一套相对成熟的数理方法可以用来做不确定性分析,但这个范式被过度简化了,不足以完全刻画出数据里的不确定性。因此在研究新的模型范式时,把握好刻画不确定性的程度和模型范式的复杂度之间的平衡是很有益的。

林宙辰教授指出当下人工智能或者机器学习的数学理论主要着眼于局部的性质,没有或者很少有着眼于整体的描述,同时也缺乏相变的理论。林宙辰教授认为提出“新”的数学有必要先对人工智能领域的整体进行了解,突破自身所在的子领域的局限性,而后提出新的概念把人工智能进行数学形式化。

余山教授从脑科学的角度认为人工智能理论可以帮助脑科学领域的发展,脑科学领域的新发现也可以为人工智能理论的发展提供新思路。脑科学领域在发展中产生了海量的复杂实验数据,但单纯的脑科学知识不能完全挖掘这些数据蕴含的信息。余山教授指出把人工智能与机器学习的有关工作与脑科学结合在一起会有一个广阔的前景:从数据中挖掘知识,把数据转变成知识,让人类更好的理解大脑是如何工作的。同时,脑科学的新发现也对人工智能的发展有指导意义。例如最近脑科学发现大脑与外界环境会存在积极的交互,利用信息指导行为,而目前的卷积神经网络等深度网络都是在被动的接收信息。这或许为人工智能领域设计出新的网络结构提供新思路。

邓柯教授指出人工智能方法应该与其他领域的知识进行融合。目前的知识表示方式如知识图谱如何与现有的机器学习方法应当融合在同一个学习框架里,让知识与数据互相促进,从数据里挖掘出因果机制等都有广阔的发展前景。同时,当人工智能算法有了大规模商业应用时,我们应该设计更有公平性和可解释性的算法。

董彬教授认为人工智能理论和算法可以辅助科学探索。人工智能算法应该有可解释性,而可解释性要基于具体的对象。

董彬教授指出尽管目前的深度学习理论表明存在一个神经网络可以解决传统的统计学和计算数学里的维数灾难问题,但当下人们还不知道什么算法可以找到这个理论上存在的解。人工智能理论面临的某些困难与传统统计学和计算数学的维数灾难问题存在近似的等价性。

邵嗣烘教授指出机器学习的发展前沿与计算数学中NP-hard问题存在紧密的联系,而维数灾难问题也与材料学和计算量子力学的多体问题相关。

点击左下角“阅读原文”,了解更多!

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有