11.76 基于深度学习的特征表示模型

随着数据规模不断增大,深度学习在大数据分析中扮演着越来越重要的角色。图 5 显示了数据规模与性能之间的关系,传统学习算法在数据规模达到一定时性能几乎不再增加,而深度学习算法的性能会随着数据规模增加而增加。通过深度学习进行特征表示学习已经成为了机器学习和数据挖掘社区的一个快速突起的方法,并已经在许多领域获得成功,如计算机视觉、语音识别和自然语言处理等。蒙特利尔大学 Bengio 教授在文献 [8] 中综述了这方面的最新进展。

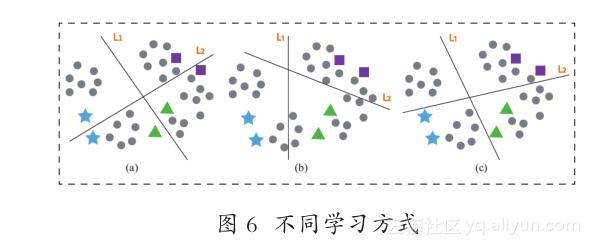

许多深度神经网络模型,如自编码器和受限玻尔兹曼机,均采用无监督学习的模式。举例来说,一个自编码器通过数据自身重构的方式来学习优化网络参数。另一方面,深度神经网络也可以采用监督学习模式,如纽约大学 LeCun 教授提出的卷积神经网络[10] 。然而,在 2006 年之前大多数监督学习模式的深度网络均不是很成功。事实证明,多层神经网络的预测能力往往比浅层学习模型(如 SVM)更差。2006 年,多伦多大学 Hinton 教授革命性地提出了深度置信网络(Deep Belief Network,DBN),一种非监督式的逐层贪心训练算法,为有效训练深度神经网络带来了希望。之后,多种深度神经网络被提出,如堆栈式降噪自编码器(StackedDenoising Autoencoders,SDAE) [11] 。这些深度学习模型往往采用无监督学习模型,已经被证明可以有效学习高层次表征。机器学习,尤其是分类和回归问题的主要目标是估计条件分布 P(Y|X)。所有基于无监督学习的预训练方法都基于一个假设:输入数据的边缘分布 P(X) 包含了关于条件分布P(Y|X) 的重要信息[12] 。当存在大量标记数据时,有监督学习方法往往非常有效。当只有少量标记数据而无标记数据可以轻易获取时,结合已有标记数据和大量无标记数据将能增加对边缘分布 P(X) 估计的准确性。图 6 给出了一个线性特征空间的实例(图中,(a) 无监督学习——仅使用无标记数据;(b)监督学习——仅使用标记数据;(c) 半监督学习——同时使用标记数据和无标记数据。圆圈表示无标记数据;三角、方块、五角星表示不同的标记数据),其中潜在表征可以仅通过无标记数据或标记数据学习得到,也可以同时从两者学习得到。不难发现,无监督学习方式可以更好地刻画数据分布;监督学习可以很好地进行分类,但是不能确保与本质的数据分布一致;半监督学习方式可以同时利用标记数据和无标记数据进行协同训练,有利于产生好的表征。

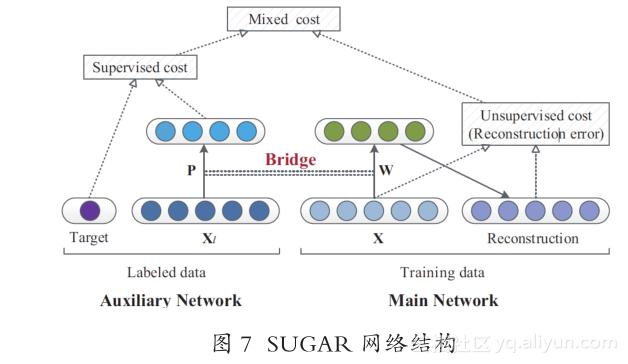

经典的自编码器及其变种往往采用无监督学习方式,为使其同样可以使用标记数据,受到一些基于弱监督学习或半监督学习的自编码器算法[13-15]的启发,我们提出了一种新的学习模型,命名为SUGAR(Supervision-Guided AutoencodeR) [16] 。 图 7给出了相应网络结构图,主要包括以下三个部分。

● 主网络 (Main Network):用于重构输入,即无监督的自编码器;

● 辅助网络 (Auxiliary Network):基于对象间相似性,用于正则化学习到的网络,即有监督学习;

● 桥 (Bridge): 用于连接主网络和辅助网络,目的是增强两个网络之间参数的相关性。

具体地,主网络使用无标记数据,可以采用正则自编码器(或降噪自编码器[11] );辅助网络使用标记数据(如成对标记),可以采用监督式学习方式(如哈希学习[17] );桥连接上面两部分,迫使它们的参数逼近。

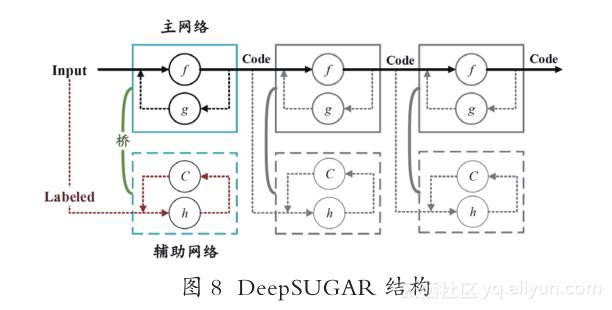

基于 SUGAR 模型,我们给出了深度学习模型DeepSUGAR,如图 8 所示。DeepSUGAR 采用堆栈方式,将多个SUGAR堆起来形成一个深度学习模型,主要分为预训练和微调两个阶段。DeepSUGAR 的每一层是 SUGAR 模型,由主网络(实线框)、辅助网络(虚线框)和桥三个组件构成。f、h 表示编码函数,g 为解码函数,C 为区分函数。预训练后,所有虚线部分(包括 g 和 h)将被丢弃,整个系统通过编码函数 f 采用前馈传递方式产生紧致表征。

我们在 8 个基准数据集上验证了模型的有效性。