作者:mobiledu2502861407 | 来源:互联网 | 2023-07-18 09:45

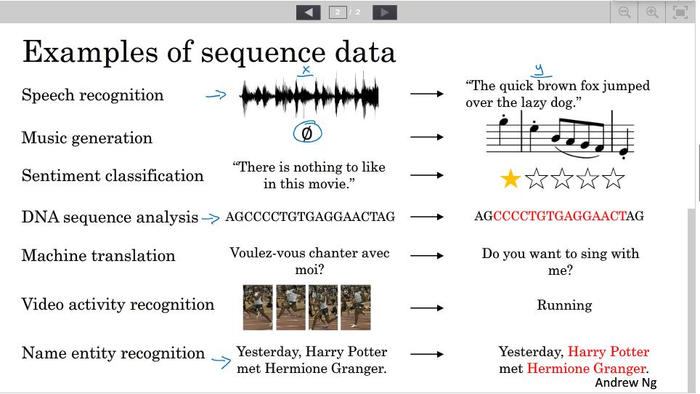

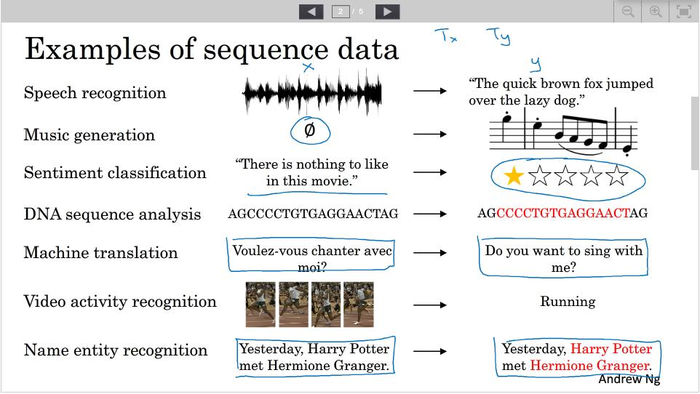

为什么选择序列模型(序列模型的例子)

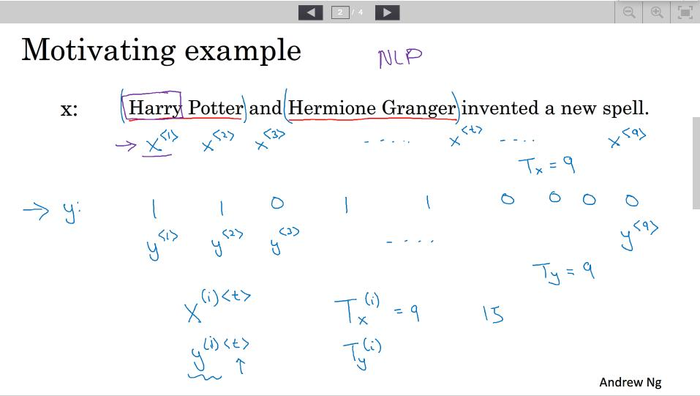

数学符号

x<t> 表示样本的第t个输入

y<t> 表示样本的第t个输出

Tx表示输入样本的长度

Ty表示输出的长度

x(i)<t>表示第i个样本的第t个输入

y(i)<t>表示第i个样本的第t个输出

至于如何表示每个x(i)<t>,常用的方法有one-hot-representation和distributed-representation

循环神经网络模型

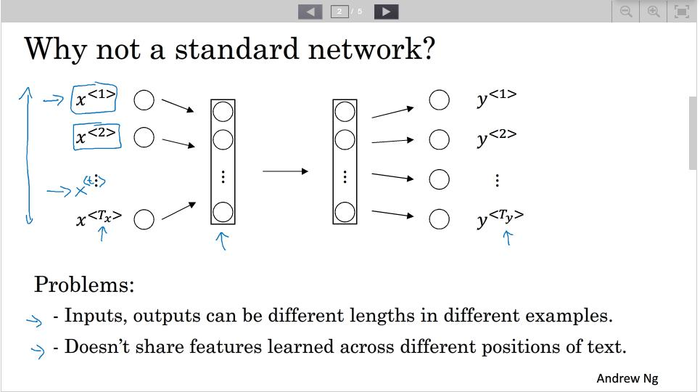

为什么不选择标准神经网络

循环神经网络结构

左边是通俗的结构模型,右边是实际的结构模型,通过反馈能使当前输出不仅取决于当前输入,还受之前输入的影响。

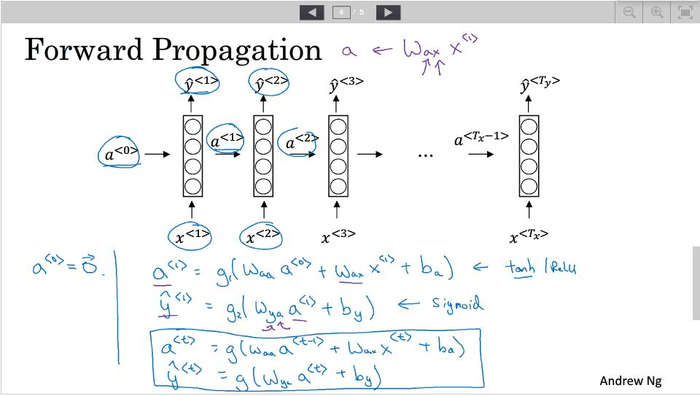

前向传播过程

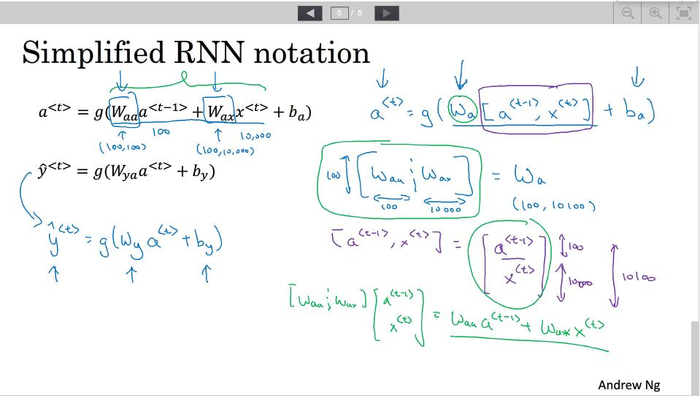

其中W第一个下标代表用于计算的输出类型,第二个下标代表与W做运算的数据类型。 更为简单的表示如下图。

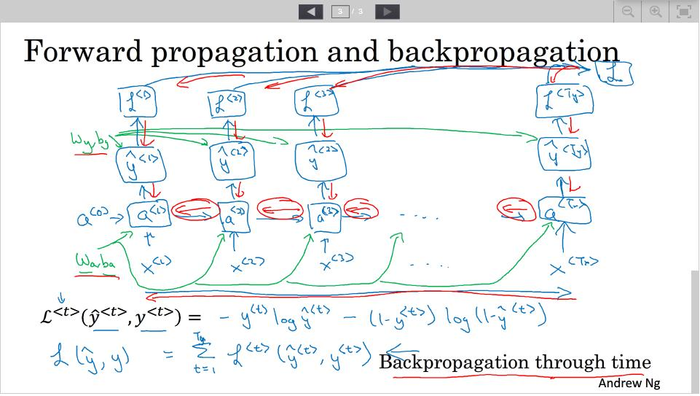

通过时间的反向传播

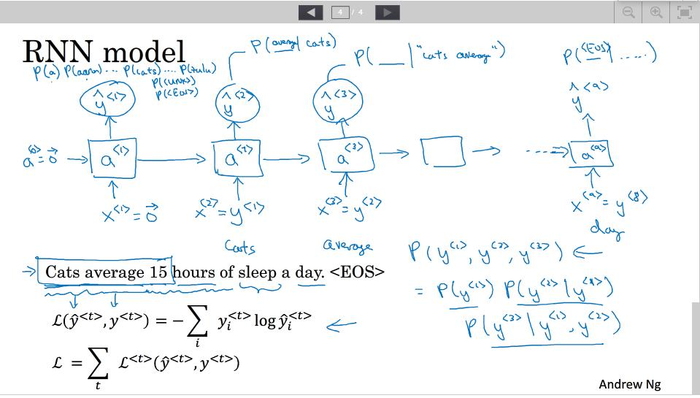

定义损失函数如下。

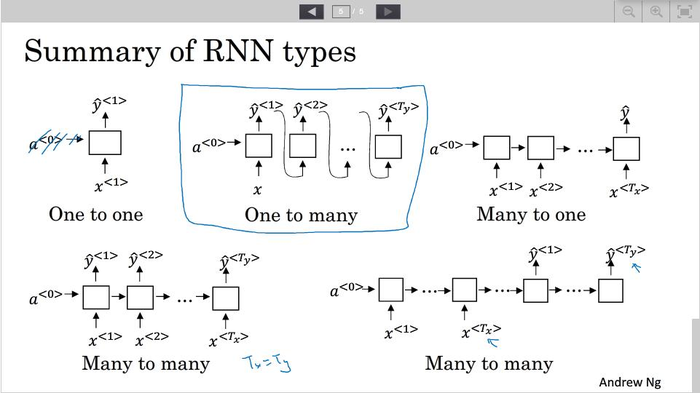

不同循环神经网络

如第一节中的例子,实际问题中输入与输出长度有多种对应关系,为解决不同的问题需求,循环神经网络的结构也有多种

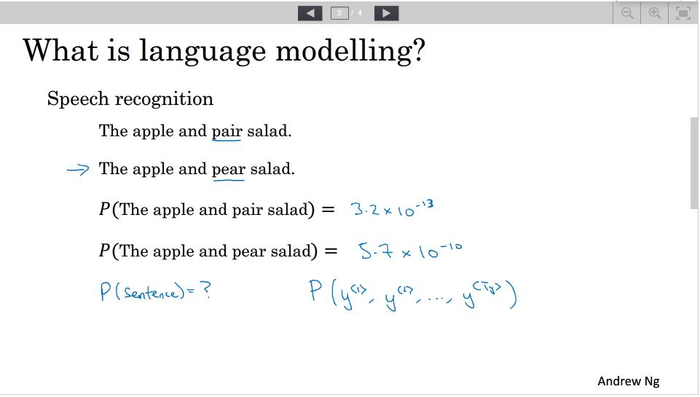

语言模型和序列生成

语言模型:一个语言模型通常构建为字符串s的概率分布p(s),这里的p(s)试图反映的是字符串s作为一个句子出现的概率。–摘自统计自然语言处理(宗成庆)

用RNN构建语言模型 ,如下图所示,其中x<t>=y<t−1>。输出层采用的**函数是softmax.

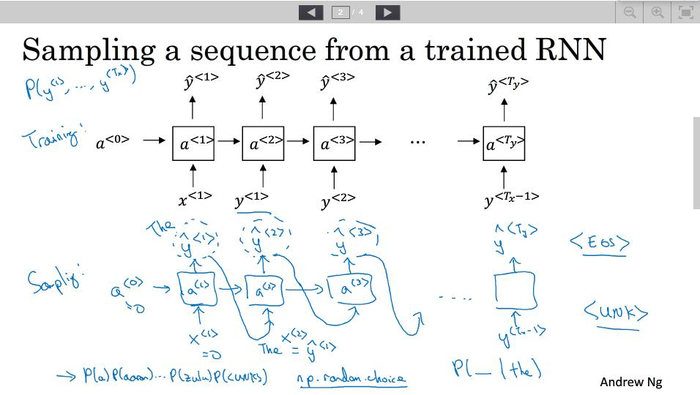

对新序列进行采样 (生成特定风格文本)

用特定风格的文本训练神经网络后,可以勇气来生成相似风格的文本,下图分别是训练过程和采样过程。采样过程随机初始化输入后计算每个单词的概率,然后对每个单词进行随机采样,并把采样结果作为下一时刻的输出。

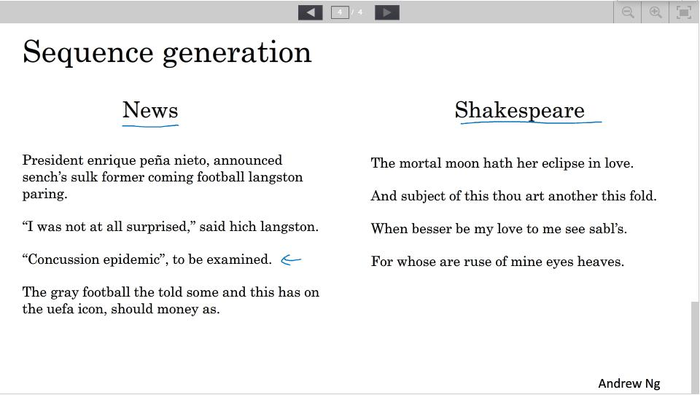

下图是用不同语料生成的不同风格文本。

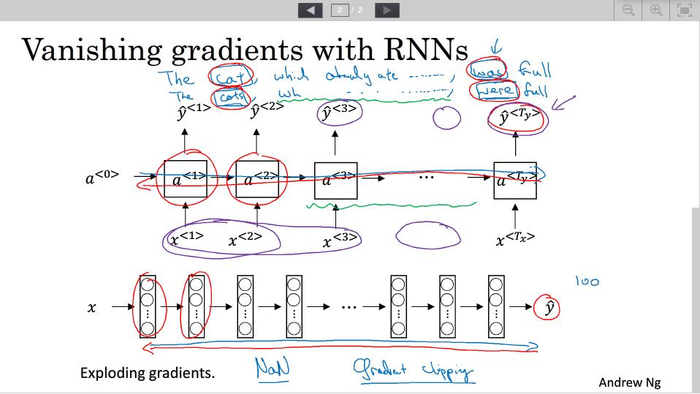

带有神经网络的梯度消失

当神经网络的层数很深时,梯度可能会指数型增长(梯度爆炸)或者指数型下降(梯度消失)。当发生梯度消失时,当前层的输出很容易受局部影响,不能传播到更前的层,如下面的句子,was很难影响到cat(单数),为解决梯度消失,GRU和LSTM是有效的方法。

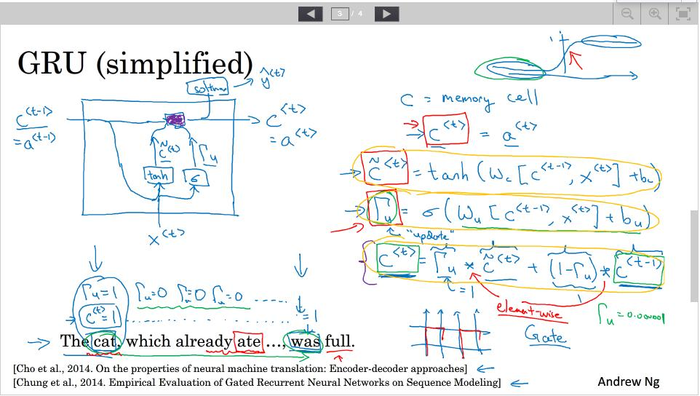

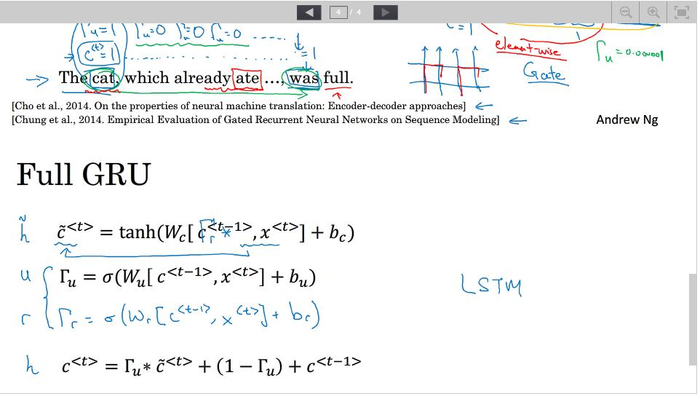

GRU单元(门控制循环单元)

如下为一个简化的GRU单元, c<t>为记忆单元,其取值由c~<t>和 c<t−1>共同决定,由Γu 控制,因为Γu 的**函数为sigmoid函数,所以其取值基本上为0和1分别代表记忆单元是更新取值(c~<t>)还是保持之前的取值(c<t−1>)

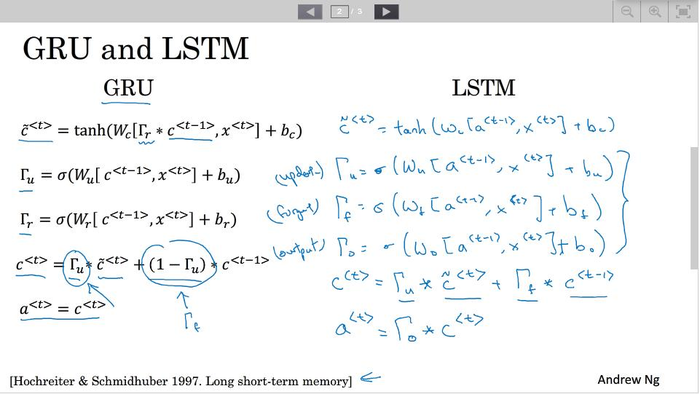

完整的GRU单元如下图所示 ,在计算c~<t>时给c<t−1>加了个权重Γr

长短期记忆(LSTM)

LSTM的基本思想和GRU一样,都是用控制门单元控制当前时刻的输出,但LSTM中的 c<t>并不与 a<t>相等,具体关系如下图。

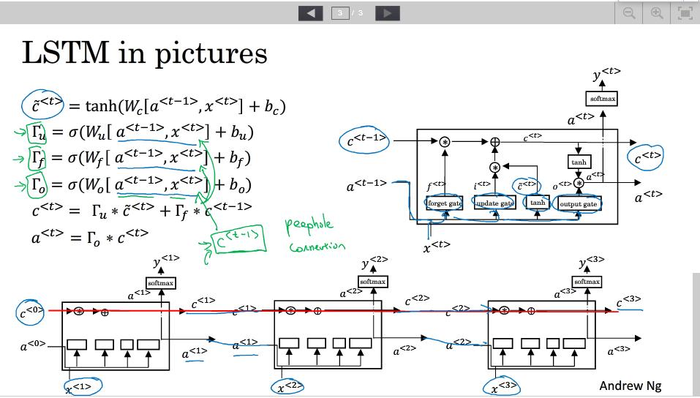

LSTM模型如下图。

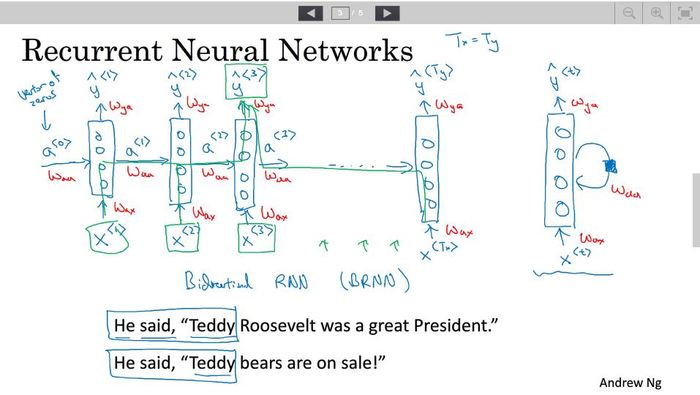

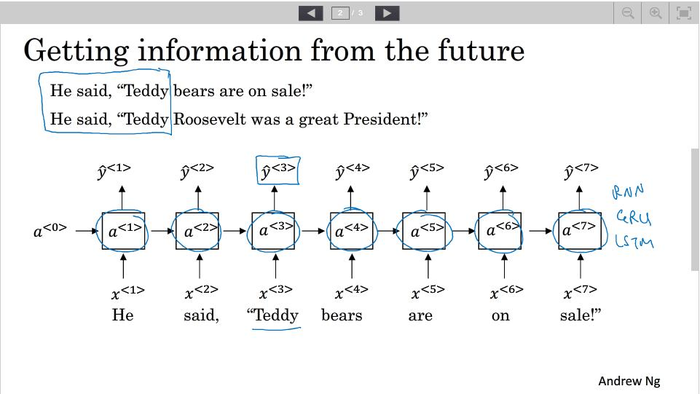

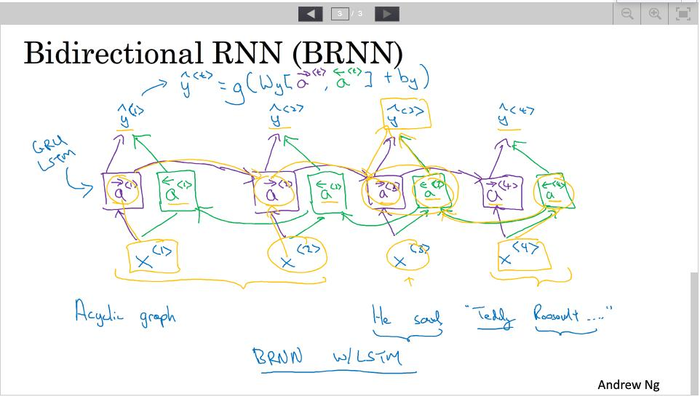

双向神经网络

构建双向神经网络的需求之一是自然语言处理中的命名实体识别,如下面的句子,判断Teddy是否为人名,不仅与之前的输入有关还与其之后的输入有关。

双向神经网络结构如下图所示。

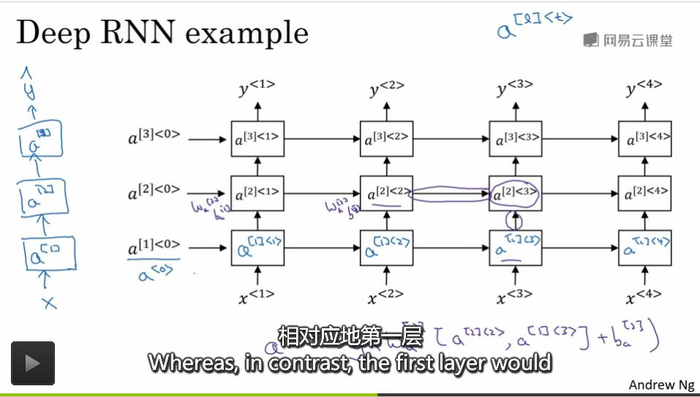

深层循环神经网络

深层循环神经网络每个时刻的输出是经过多个隐藏层后输出的,但是因为循环神经网络需要的计算资源很大,所以循环神经网络的层数一般不会很深。