代码如下

from bs4 import BeautifulSoup #网页解析,获取数据 import sys #正则表达式,进行文字匹配 import re import urllib.request,urllib.error #指定url,获取网页数据 import xlwt #使用表格 import sqlite3 import lxml

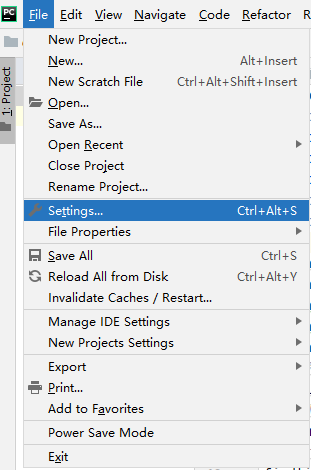

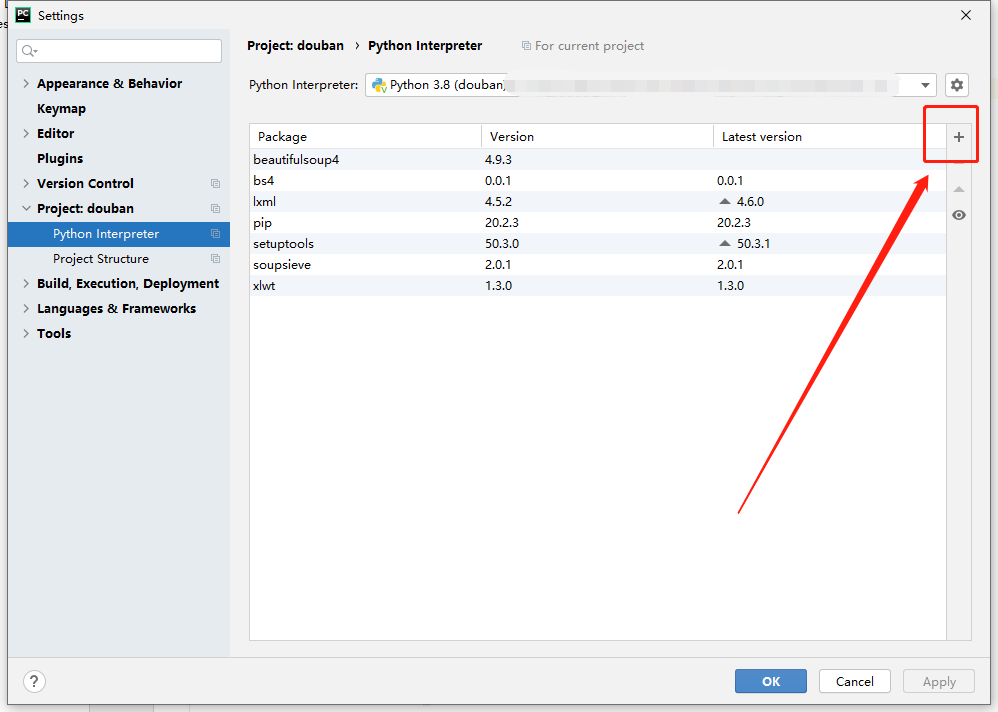

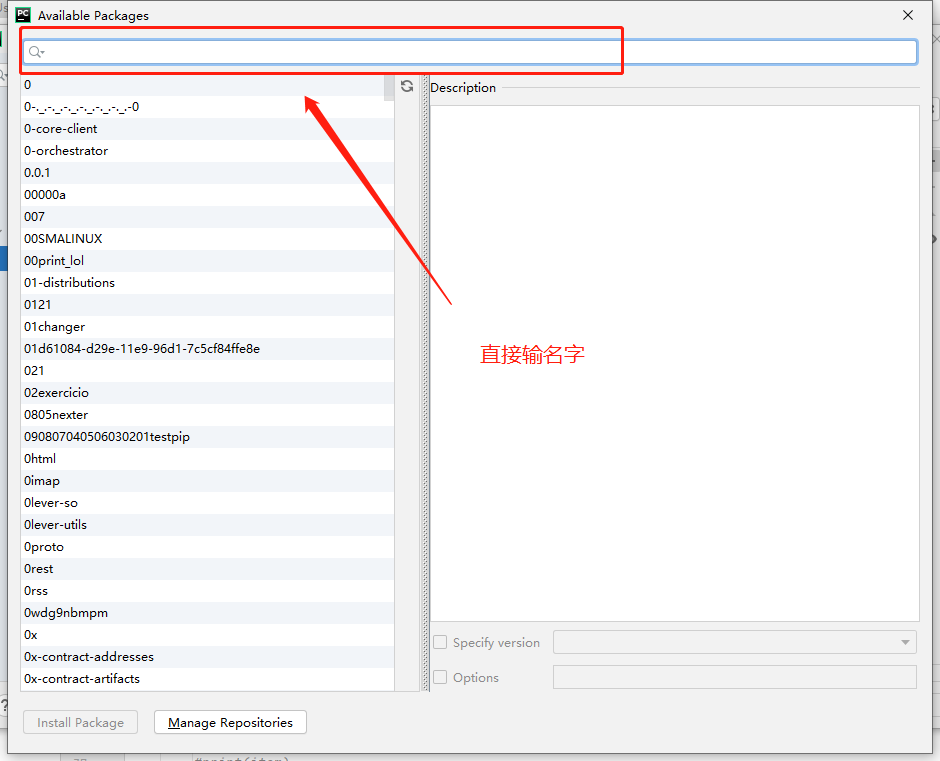

以上是引用的库,引用库的方法很简单,直接上图:

上面第一步算有了,下面分模块来,步骤算第二步来:

这个放在开头

def main():

baseurl ="https://movie.douban.com/top250?start="

datalist = getData(baseurl)

savepath=('douban.xls')

saveData(datalist,savepath)

这个放在末尾

if __name__ == '__main__':

main()

不难看出这是主函数,里面的话是对子函数的调用,下面是第三个步骤:子函数的代码

对网页正则表达提取(放在主函数的后面就可以)

爬数据核心函数

def getData(baseurl):

datalist=[]

for i in range(0,10):#调用获取页面的函数10次

url = baseurl + str(i*25)

html = askURl(url)

#逐一解析

soup = BeautifulSoup(html,"html.parser")

for item in soup.find_all('div',class_="item"):

#print(item)

data=[]

item = str(item)

link = re.findall(findLink,item)[0] #re库用来通过正则表达式查找指定的字符串

data.append(link)

titles =re.findall(findtitle,item)

if(len(titles)==2):

ctitle=titles[0].replace('\xa0',"")

data.append(ctitle)#添加中文名

otitle = titles[1].replace("\xa0/\xa0Perfume:","")

data.append(otitle)#添加外国名

else:

data.append(titles[0])

data.append(' ')#外国名字留空

imgSrc = re.findall(findImg,item)[0]

data.append(imgSrc)

rating=re.findall(fileRating,item)[0]

data.append(rating)

judgenum = re.findall(findJudge,item)[0]

data.append(judgenum)

inq=re.findall(findInq,item)

if len(inq) != 0:

inq =inq[0].replace(".","")

data.append(inq)

else:

data.append(" ")

bd=re.findall(findBd,item)[0]

bd=re.sub('

bd =re.sub('\xa0'," ",bd)

data.append(bd.strip()) #去掉前后的空格

datalist.append(data) #把处理好的一部电影信息放入datalist

return datalist

获取指定网页内容

def askURl(url):

head = {

"User-Agent": "Mozilla / 5.0(Windows NT 10.0;WOW64) Apple"

+"WebKit / 537.36(KHTML, likeGecko) Chrome / 78.0.3904.108 Safari / 537.36"

}

#告诉豆瓣我们是浏览器我们可以接受什么水平的内容

request = urllib.request.Request(url,headers=head)

html=""

try:

respOnse= urllib.request.urlopen(request)

html = response.read().decode("utf-8")

# print(html)

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html

将爬下来的数据保存到表格中

ef saveData(datalist,savepath):

print("保存中。。。")

book = xlwt.Workbook(encoding="utf-8",style_compression=0) # 创建workbook对象

sheet = book.add_sheet('douban',cell_overwrite_ok=True) #创建工作表 cell_overwrite_ok表示直接覆盖

col = ("电影详情链接","影片中文网","影片外国名","图片链接","评分","评价数","概况","相关信息")

for i in range(0,8):

sheet.write(0,i,col[i])

for i in range(0,250):

print("第%d条" %(i+1))

data = datalist[i]

for j in range(0,8):

sheet.write(i+1,j,data[j])

book.save(savepath)

以上就是整个爬数据的整个程序,这仅仅是一个非常简单的爬取,如果想要爬更难的网页需要实时分析

整个程序代码

from bs4 import BeautifulSoup #网页解析,获取数据

import sys #正则表达式,进行文字匹配

import re

import urllib.request,urllib.error #指定url,获取网页数据

import xlwt #使用表格

import sqlite3

import lxml

def main():

baseurl ="https://movie.douban.com/top250?start="

datalist = getData(baseurl)

savepath=('douban.xls')

saveData(datalist,savepath)

#影片播放链接

findLink = re.compile(r'') #创建正则表达式对象,表示规则(字符串的模式)

#影片图片

findImg = re.compile(r'(.*?)

',re.S)

def getData(baseurl):

datalist=[]

for i in range(0,10):#调用获取页面的函数10次

url = baseurl + str(i*25)

html = askURl(url)

#逐一解析

soup = BeautifulSoup(html,"html.parser")

for item in soup.find_all('div',class_="item"):

#print(item)

data=[]

item = str(item)

link = re.findall(findLink,item)[0] #re库用来通过正则表达式查找指定的字符串

data.append(link)

titles =re.findall(findtitle,item)

if(len(titles)==2):

ctitle=titles[0].replace('\xa0',"")

data.append(ctitle)#添加中文名

otitle = titles[1].replace("\xa0/\xa0Perfume:","")

data.append(otitle)#添加外国名

else:

data.append(titles[0])

data.append(' ')#外国名字留空

imgSrc = re.findall(findImg,item)[0]

data.append(imgSrc)

rating=re.findall(fileRating,item)[0]

data.append(rating)

judgenum = re.findall(findJudge,item)[0]

data.append(judgenum)

inq=re.findall(findInq,item)

if len(inq) != 0:

inq =inq[0].replace(".","")

data.append(inq)

else:

data.append(" ")

bd=re.findall(findBd,item)[0]

bd=re.sub('

bd =re.sub('\xa0'," ",bd)

data.append(bd.strip()) #去掉前后的空格

datalist.append(data) #把处理好的一部电影信息放入datalist

return datalist

#得到指定一个url的网页内容

def askURl(url):

head = {

"User-Agent": "Mozilla / 5.0(Windows NT 10.0;WOW64) Apple"

+"WebKit / 537.36(KHTML, likeGecko) Chrome / 78.0.3904.108 Safari / 537.36"

}

#告诉豆瓣我们是浏览器我们可以接受什么水平的内容

request = urllib.request.Request(url,headers=head)

html=""

try:

respOnse= urllib.request.urlopen(request)

html = response.read().decode("utf-8")

# print(html)

except urllib.error.URLError as e:

if hasattr(e,"code"):

print(e.code)

if hasattr(e,"reason"):

print(e.reason)

return html

def saveData(datalist,savepath):

print("保存中。。。")

book = xlwt.Workbook(encoding="utf-8",style_compression=0) # 创建workbook对象

sheet = book.add_sheet('douban',cell_overwrite_ok=True) #创建工作表 cell_overwrite_ok表示直接覆盖

col = ("电影详情链接","影片中文网","影片外国名","图片链接","评分","评价数","概况","相关信息")

for i in range(0,8):

sheet.write(0,i,col[i])

for i in range(0,250):

print("第%d条" %(i+1))

data = datalist[i]

for j in range(0,8):

sheet.write(i+1,j,data[j])

book.save(savepath)

if __name__ == '__main__':

main()

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持。

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有