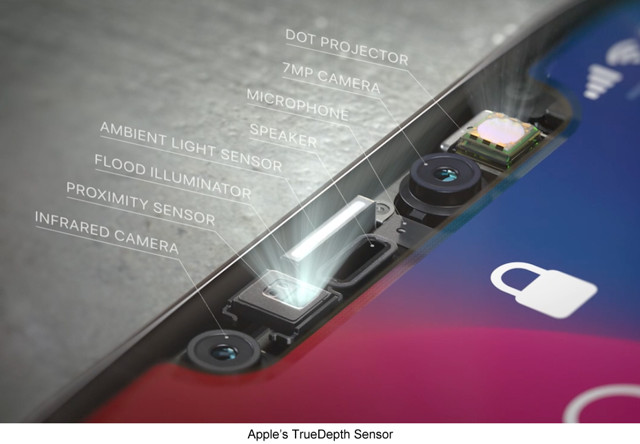

iPhone X 的前置 TrueDepth 传感系统让手机可实现脸部解锁,还实现对面部表情的实时跟踪和识别,生成 Animojis。但显然,这只是苹果的第一步。如果把苹果手机后置摄像头也加入 3D 传感系统,又会产生什么样的效果呢?

升级 iOS 11 系统后,苹果手机可下载 AR 应用,这主要通过苹果后置单目摄像头实现。如果加入后置 3D 传感系统可让 AR 功能更为强大,例如使 AR 虚拟形象与真实环境中的物体,进行更多地交互。3D 传感系统可检测深度信息,构建三维地图,而现在,苹果 AR 应用只能检测到一个平面。同样的,后置 3D 传感系统还能为 AR 眼镜奠定技术基础。

不过,有意思的是,根据彭博社报道,苹果正在研发后置 3D 传感系统采用的技术路径,跟前置的 TrueDepth 系统并不一样。

雷锋网此前曾报道,TrueDepth 采用结构光技术,将 30000 个激光点图案投射到用户的脸上,并测量失真以生成用于认证的精确 3D 图像。这种技术原本由以色列公司 PrimeSense 研发,后在 2013 年被苹果收购。PrimeSense 曾基于结构光技术为微软研发 Kinect 传感系统。

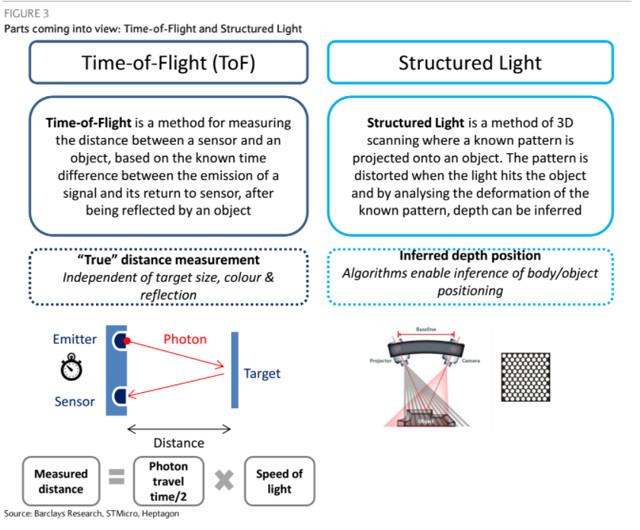

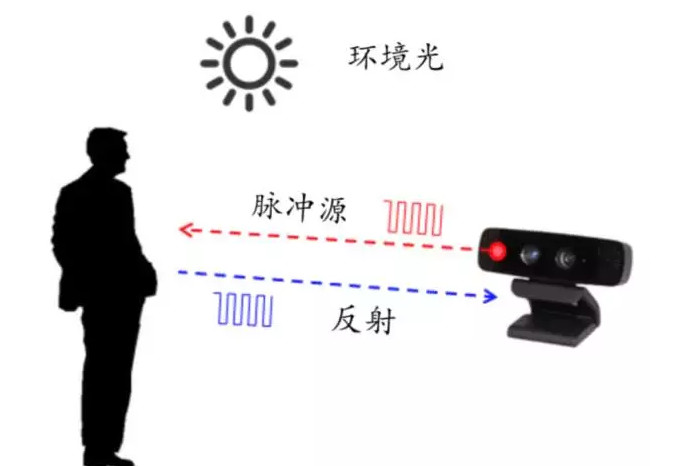

但据雷锋网了解,苹果正在研发的 3D 后置传感系统将使用飞行时间法 3D 成像(Time of Flight,ToF),这种方法更难以实现。其主要是通过激光扫面物体表面,传感系统会测量激光到达物体和返回的时间。

ToF 原理

在上述图中,我们能看到,ToF 关键是传感器要测量物体的距离。

ToF 多被应用到 LIDAR (雷达)中,其主要的不足在于,它每次只能测量激光到达一个特定点的距离。所以,大部分雷达系统采用机械扫描装置。雷达系统目前多被用于自动驾驶领域。但体型通常较大,会被放置在汽车的顶部。

显而易见,这对手机并不适用。目前还有一种新型的雷达称之为 Flash LIDAR。它使用特殊的摄像头,可测量对每个像素实现飞行时间测量。但 Flash LIDAR 还在研发中,同时也遇到了一些挑战。因为每个像素需要得到自己的飞行时间测量,其中包括触发电路、脉冲检测电路。这便与 TrueDepth 产生了一定的冲突。

尽管 Flash LIDAR 的问题在逐步解决,但如传感器的分辨率可能相当低,接近于 VGA 分辨率。

另外的问题是,提供适当的脉冲激光照明。光以每纳秒约一英尺的速度传播,而多数 LIDAR 和 Flash LIDAR 系统光脉冲时间非常短,只有 1-2 纳秒。所以,在一定的时间内,生成足够密度的光脉冲,被 Flash LIDAR 检测到,也具有一定的挑战。

苹果已经确定在研发 ToF,但是否最终会用到手机上,还不一定。结构光非常适合用于房间大小的空间内,这也是为什么 Kinect 和 HoloLens 也会使用结构光的方案。

对比两种方案的话,ToF 的精准度和稳定性较好,但结构光可以做的更小、功耗也小,分辨率相对高。

雷锋网(公众号:雷锋网)觉得,苹果也许在尝试不同的解决方案,融入到手机中必定有很大的挑战,我们期待后置 3D 传感器能让 AR 功能更强大。

。

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有

京公网安备 11010802041100号 | 京ICP备19059560号-4 | PHP1.CN 第一PHP社区 版权所有