作者:可乐16311 | 来源:互联网 | 2023-09-12 20:21

文章目录前言一、虚拟机环境的准备二、连接虚拟机上的集群1.整理需要连接的端口2.配置VMware上虚拟机的端口转发3.测试连接总结前言本人刚开始学习大数据,记录自己的一些学习笔记。

文章目录

- 前言

- 一、虚拟机环境的准备

- 二、连接虚拟机上的集群

- 1.整理需要连接的端口

- 2.配置VMware上虚拟机的端口转发

- 3.测试连接

- 总结

前言

本人刚开始学习大数据,记录自己的一些学习笔记。大家在学习大数据开发的时候,第一件事情就是大数据环境的搭建,目前一般有三种搭建方式:1.使用windows环境搭建;2.自己电脑搭建linux虚拟机环境,可以自己建好多个虚拟机环境,然后搭建集群;3.购买云厂商的大数据集群或者主机自己搭建集群。第一种方式不主流,且出现问题解决资料不多,并且需要机子比较多。第二种方式自由度比较高,但是受限于自己机子的配置;第三种方式是目前的主流方式,但是要花钱。

由于电脑的升级换代,本人有一台老式12G内存、500G机械存储的某想笔记本,卡的不想做为办公电脑,还有一台8G内存、256G固态存储的新电脑(买来发现内存焊死了,不支持扩展,为什么配置这么尴尬,因为是白嫖的,便宜。。)。

想到在旧电脑上安装虚拟机,建几个linux环境,搭建hadoop集群;然后新电脑连接这个集群,还可以听老师讲课,敲代码。真是贫穷让人机智。

#博学谷IT学习技术支持#

一、虚拟机环境的准备

首先保证两台宿主机在一个网络环境下,假设他们为S1、S2,这边S1是我的新电脑、S2是我的旧电脑,它们的ip分别为:192.168.8.101、192.168.8.102。

在S2上安装虚拟机环境。使用虚拟机搭建hadoop集群的准备资料网上很多,一般就是下面几个步骤:

- 安装linux环境

- 安装jdk

- 安装hadoop,配置环境

- 安装hive,配置环境

当前在VMware上建好了3个linux环境:node1、node2、node3,它们的ip分别为:192.168.9.101、192.168.9.102、192.168.9.103,并且安装了hadoop,hive集群,虚拟机网络配置为NAT,如下图:

一定要保证宿主机和虚拟机之间网络是互通的,一般不通要么是防火墙没关或者网络配置等问题。

二、连接虚拟机上的集群

1.整理需要连接的端口

远程端口:22

hdfs端口:9870

hive端口:10000

这几个端口是我在学习hadoop集群中要连接的。

2.配置VMware上虚拟机的端口转发

S2主机上安装了虚拟机环境(hadoop01、hadoop02、hadoop03),我们要用S1主机访问S2上的虚拟机环境,它们处于不同的子网,是不通的。当前S2和hadoop01-hadoop03是可以互相访问的,S1和S2连得同一个路由器是通的,要让S1能访问hadoop01-hadoop03,这时候查看资料发现VMware其实自带端口转发,把S2虚拟机上需要连接的端口都转发出来,这时候S1就可以通过访问这些转发端口从而访问虚拟机内部的端口了。整理如下:

| 虚拟机IP | 虚拟机端口 | 主机IP | 主机转发端口 |

|---|

| 192.168.9.101 | 22 | 192.168.8.101 | 10202 |

| 192.168.9.102 | 9870 | 192.168.8.101 | 19870 |

| 192.168.9.103 | 10000 | 192.168.8.101 | 10000 |

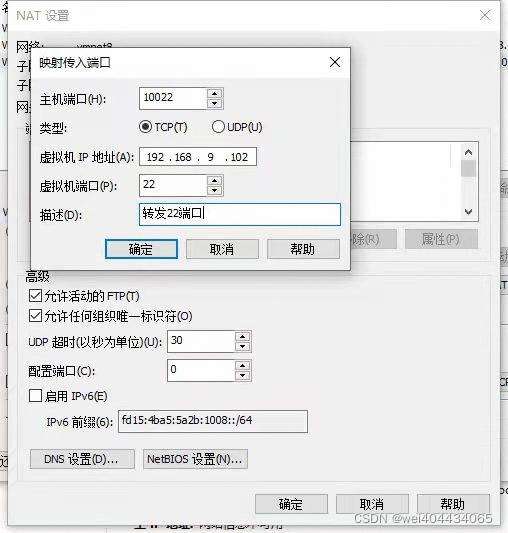

1.配置虚拟网络编辑器

2.更改NAT设置

3.选择NAT网络,点击NAT设置

4.添加映射端口

5.点击确定,按照1-4步骤依次将22、9870、10000端口都映射起来。

3.测试连接

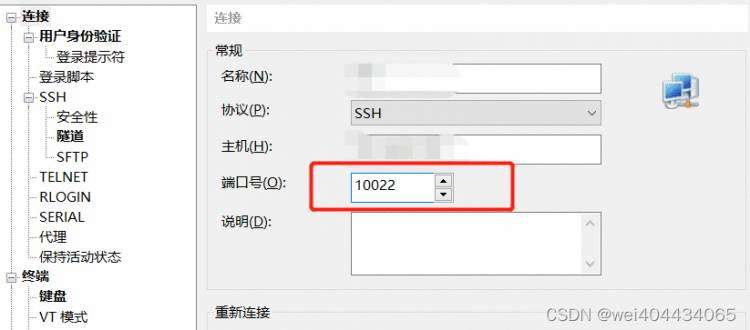

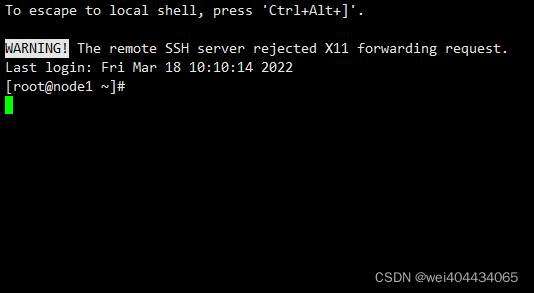

打开S2上的node1-node3虚拟机,用S1远程S2上的node1,这时候连接IP是S2的IP,端口是映射端口10022,可以连接:

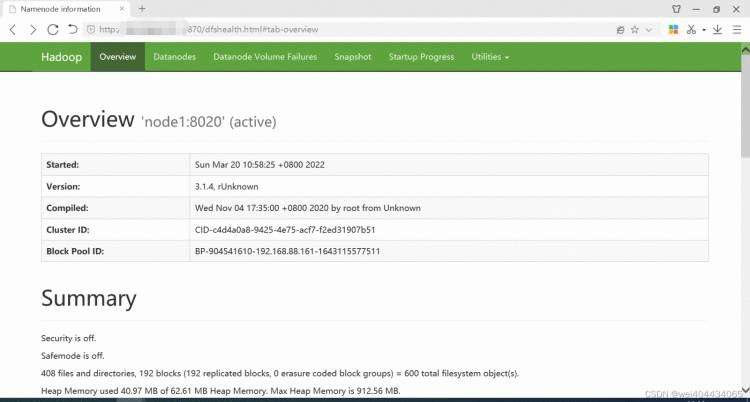

启动hadoop集群和hive集群,然后S1上就可以访问集群了,测试连接hdfs和hive都可以。

总结

本文使用VMware的端口转发功能,利用一台闲置电脑搭建虚拟机Hadoop集群,可以被相同子网中的其它主机连接,为后续学习大数据开发做准备。贫穷让我们相遇。

参考文章如下:

https://blog.csdn.net/qq_26230421/article/details/79232219