2019独角兽企业重金招聘Python工程师标准>>>

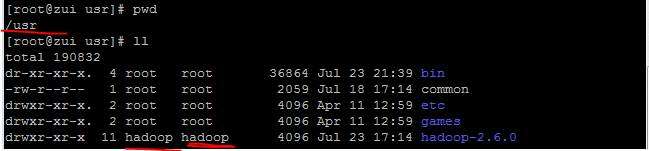

版本说明:

Hadoop版本:Hadoop2.4.0

Sqoop版本:sqoop-1.4.5.bin__hadoop-2.0.4

问题说明:

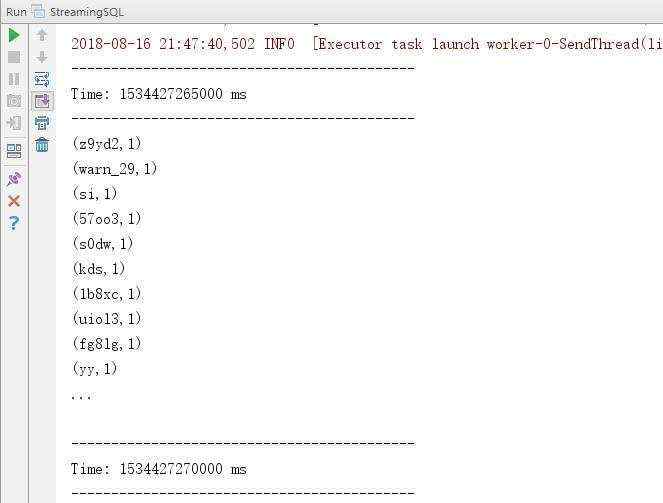

将sqoop编译成对应的hadoop版本之后,运行sqoop help的时候出现下面的错误:

Error: Could not find or load main class org.apache.sqoop.Sqoop

关于这个问题,网上搜了一大圈以后,总的来说统统都是以下的办法:

确保$SQOOP_HOME/ sqoop-1.4.5.jar要放在$HADOOP_HOME/lib目录下

还有记得将MySQL的驱动放到$SQOOP_HOME/lib包下

上面的方法我试过无数无数遍都是不行的!

就这样这个问题几乎困扰了我一周的时间,最后在无意间我发现一个很奇怪的现象:

HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop 无法使用sqoop

HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop 就没问题,但是hdfs不能用了

无奈之下我做了如下配置:

全局变量 /etc/profile:

#hadoop

export HADOOP_HOME=/usr/share/hadoop/static

export HADOOP_HOME=/usr/share/hadoop/static

export HADOOP_MAPRED_HOME=${HADOOP_HOME}

export HADOOP_COMMON_HOME=${HADOOP_HOME}

export HADOOP_HDFS_HOME=${HADOOP_HOME}

export YARN_HOME=${HADOOP_HOME}

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export PATH=.:$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

局部变量:$SQOOP_HOME/conf/sqoop.env增加如下配置:

export HADOOP_HOME=/usr/share/hadoop/static

export HADOOP_CONF_DIR=${HADOOP_HOME}

这样配置以后就不会再报Could not find or load main class org.apache.sqoop.Sqoop的错误了。

但是这样做的一个问题是:sqoop会因为找不到hadoop的配置文件报错,谁知道这个问题该怎么解决呢?

关于sqoop-1.4.5的编译请看:http://my.oschina.net/AlbertHa/blog/318551

京公网安备 11010802041100号

京公网安备 11010802041100号