作者:Lovepetall | 来源:互联网 | 2024-12-02 15:24

问题背景

在使用 ZooKeeper 进行开发时,一个常见的问题是:客户端如何确保在执行写操作(如创建节点)之后,紧接着进行的读操作能够准确无误地读取到之前写入的数据?这不仅是对 ZooKeeper 一致性的考验,也是开发者需要了解的关键技术点。

初步假设

基于前一篇文章《ZooKeeper 客户端向 Follower 发送读请求时,Follower 是转发给 Leader 处理还是自行处理》中的分析,我们知道在处理请求的过程中,ZooKeeper 使用了一些特殊的队列来协调读写请求的顺序。因此,我们假设这些队列机制是确保写后读一致性的重要因素之一。接下来,我们将深入研究这一机制的具体实现。

源码解析

在上一篇文章中,我们详细探讨了 Follower 如何处理来自客户端的请求。在此基础上,我们将进一步分析当客户端同时发送写请求和随后的读请求时,系统内部是如何处理这些请求的,以确保数据的一致性。

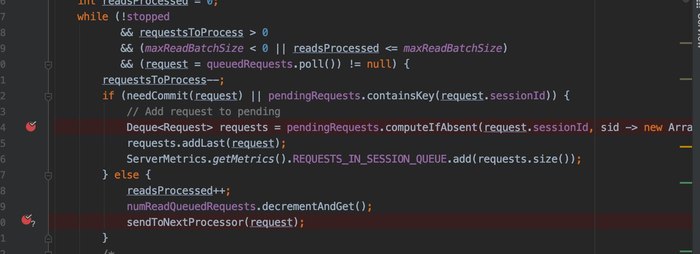

具体来说,我们关注 org.apache.zookeeper.server.quorum.CommitProcessor#run 方法。该方法负责处理提交的请求,并确保所有写操作在任何读操作之前完成。如下图所示:

如果同一客户端快速连续发送写请求和读请求,写请求将首先被放入 pendingRequest 队列中,而读请求则会在写请求之后排队等待处理。这种设计确保了即使在网络延迟或处理时间差异的情况下,也能维持正确的读写顺序。

断点调试实践

为了验证上述假设,我们可以通过设置断点来观察实际的请求处理流程。例如,在 CommitProcessor#run 方法中的适当位置设置断点,然后让客户端快速发送一个写请求(如 create /t1)和一个读请求(如 ls /)。通过这种方式,我们可以直观地看到写请求如何优先于读请求得到处理,以及整个过程中的数据流动情况。

结论与解答

通过上述分析和实验,我们可以得出结论:ZooKeeper 通过内部的请求队列机制有效地管理了读写请求的顺序,从而确保了客户端在执行写操作后能够正确读取到最新的数据。这一机制不仅保证了系统的强一致性,也为开发者提供了可靠的分布式数据管理工具。